Егор Овчинников

Спасибо!

Я в данном вопросе больше интересуюсь общим пониманием. Не только в ключе того сета. Хочу понять, РАЗ И НАВСЕГДА, просто последовательность применения подобных методов. Я так понимаю ты просто после обучения модели смотрел feature_importances? И признаки с самыми низкими значениями удалял?

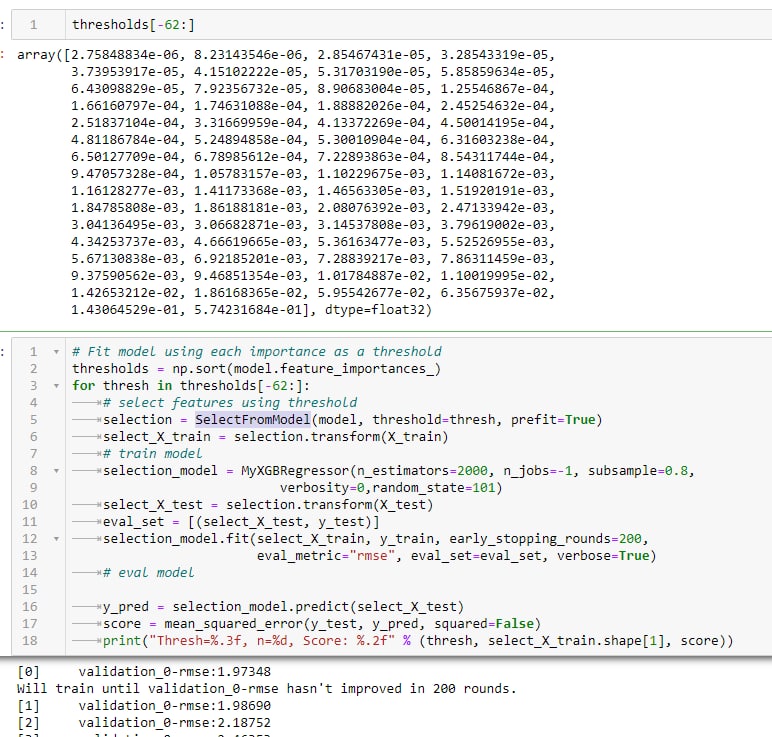

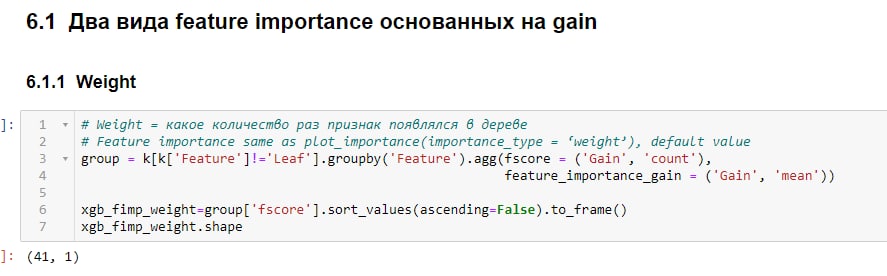

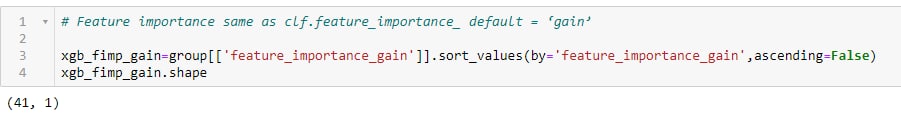

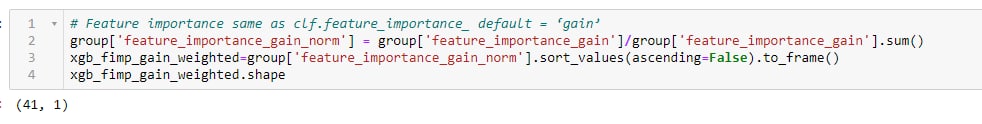

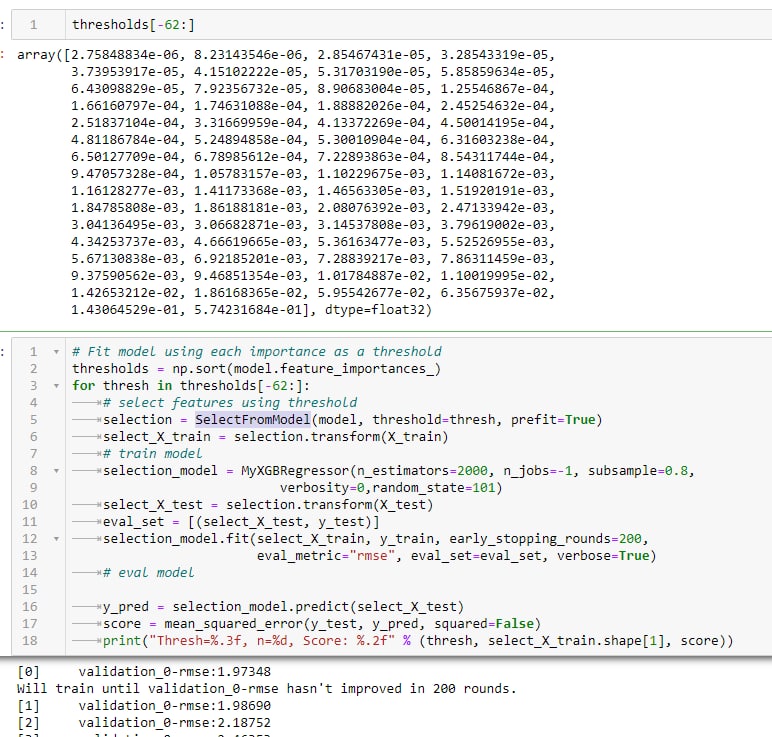

есть такой подход, если мы говорим о моделях. у которых есть атрибут coef_ или feature_importances_, как в xgboost - SelectFromModel sklern. допустим, у вас есть 62 признака значимых, вы их сортируете по значимости и начинаете с помощью этого прибамбаса удалять по одному признаку и смотреть что получится, как в примере. В итоге вы увидите минимальтное количество признаков, которое можно оставить без понижения скора