AZ

Size: a a a

2018 December 26

на style tokens уже получается очень убедительная интонация. Но ее все равно размечать

ап

https://github.com/Olga-Yakovleva/RHVoice вот не плохой проект по синтезу голоса. Русский язык вполне, единственное на слух ощущается что голос синтетический.

2019 January 02

n

В общем, т. к. Яндекс не продоставляет SDK с функционалом как у Яндекс.Станции (т. е. преобразования голоса в команды и разделение их на команды для колонки (увеличить громкость) и для Алисы (какая завтра погода)), хочу спросить, как реализовать данные функции?

2019 January 04

KD

В общем, т. к. Яндекс не продоставляет SDK с функционалом как у Яндекс.Станции (т. е. преобразования голоса в команды и разделение их на команды для колонки (увеличить громкость) и для Алисы (какая завтра погода)), хочу спросить, как реализовать данные функции?

Если вам нужно распознавание сущностей в тексте, то это Natural Language Processing. Сфинкс этим не занимается совсем. Есть отечественная Open Source разработка на Питон "Наташа", но я с ней не разобрался, могу дать ссылку на чат по NLP в Телеграме (там можно и по Наташе вопросы задавать и более общие вопросы)

UPD: https://t.me/natural_language_processing

UPD2: ну или просто ручками прописывать поиск соответствующих команд в распознаваемом тексте :)

UPD: https://t.me/natural_language_processing

UPD2: ну или просто ручками прописывать поиск соответствующих команд в распознаваемом тексте :)

n

Если вам нужно распознавание сущностей в тексте, то это Natural Language Processing. Сфинкс этим не занимается совсем. Есть отечественная Open Source разработка на Питон "Наташа", но я с ней не разобрался, могу дать ссылку на чат по NLP в Телеграме (там можно и по Наташе вопросы задавать и более общие вопросы)

UPD: https://t.me/natural_language_processing

UPD2: ну или просто ручками прописывать поиск соответствующих команд в распознаваемом тексте :)

UPD: https://t.me/natural_language_processing

UPD2: ну или просто ручками прописывать поиск соответствующих команд в распознаваемом тексте :)

Спасибо большое, просмотрю

2019 January 05

t2

Должно ли падать качество распознавания речи, если модель под 16к, а файлы я перегоняю из 8к (ffmpeg -ar 16000)? Другими словами, имеет ли смысл записывать в 16к либо переобучать модель под 8к?

AZ

Должно. Имеет, записывать на 16кгц

t2

Спасибо, понял

t2

А если допустим нет возможности писать 16к, то что лучше - обучать модель под 8, снижая sample rate обучающей выборки, либо же обучаться на 16к, и конвертировать 8->16 при распознавании?

AZ

Первое, второе бессмысленно. Но первое затратно, акустику учить

t2

Благодарю

t2

Я с espnet сейчас экспериментирую

t2

Еще надо бы добраться до wav2letter

2019 January 13

RF

Всем привет

RF

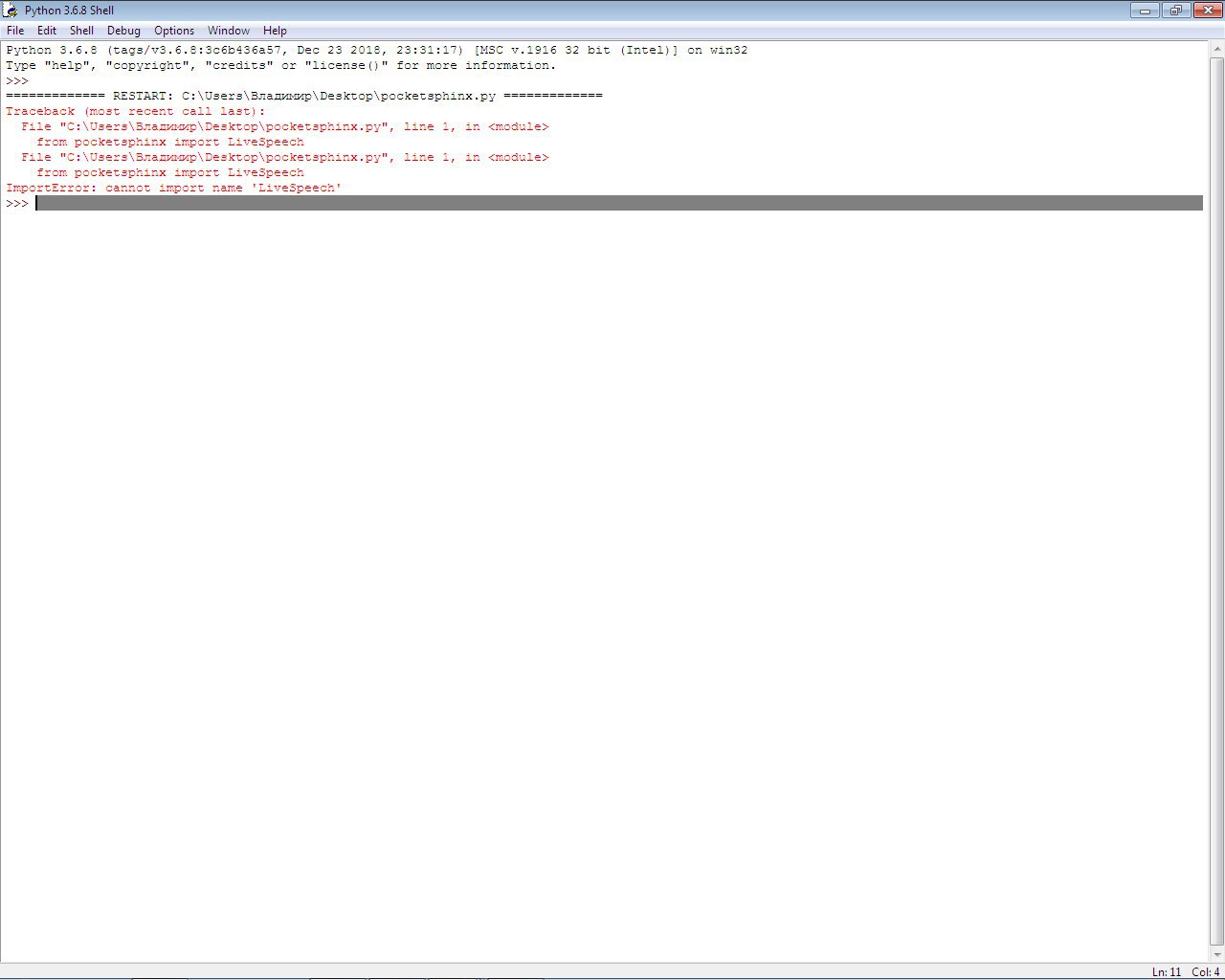

Есть вопрос про livespeech на питон 3.6

RF

RF

с такой ошибкой

RF

может кто-нибудь помочь?

RF

?