TG

Size: a a a

2021 June 12

Я и не смог воспроизвести ошибку при текущей версии , пытался понять что делает пул и какие параметры могли быть установлены автоматически не так как в предыдущий раз...

2021 June 13

TG

Здравствуйте, в продолжении темы использования свободной Ram в процессе обучения модели...

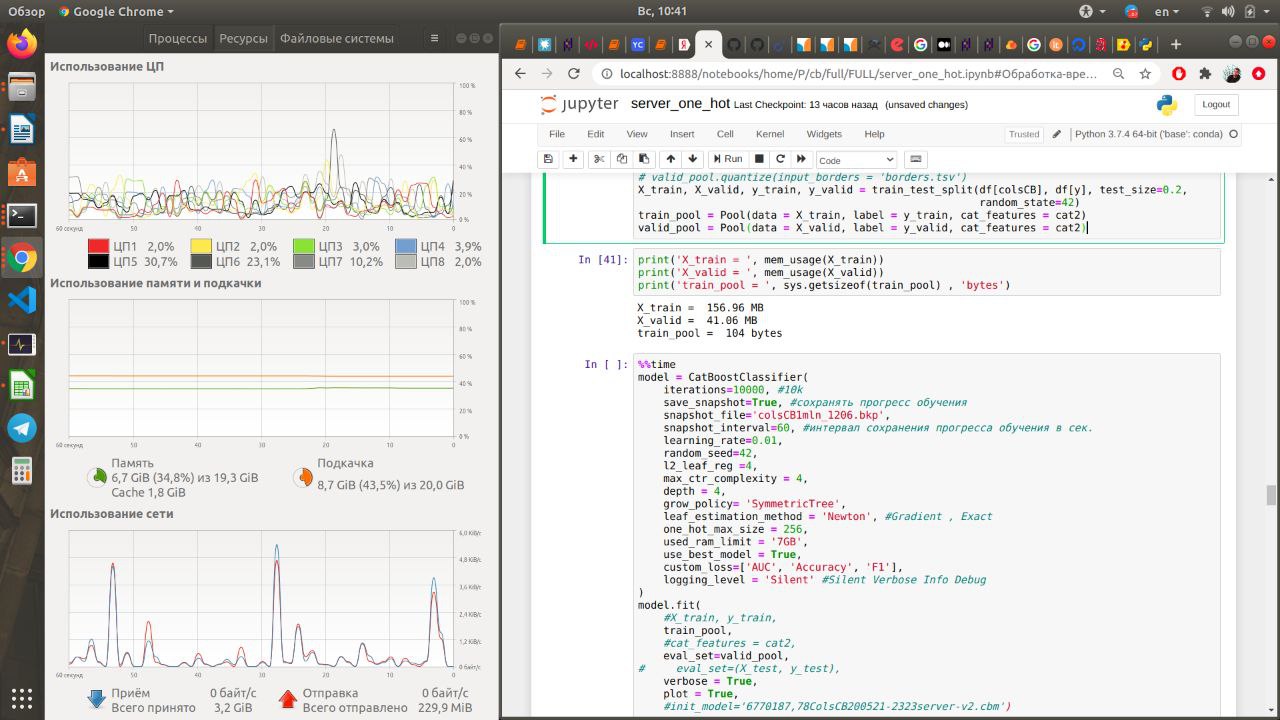

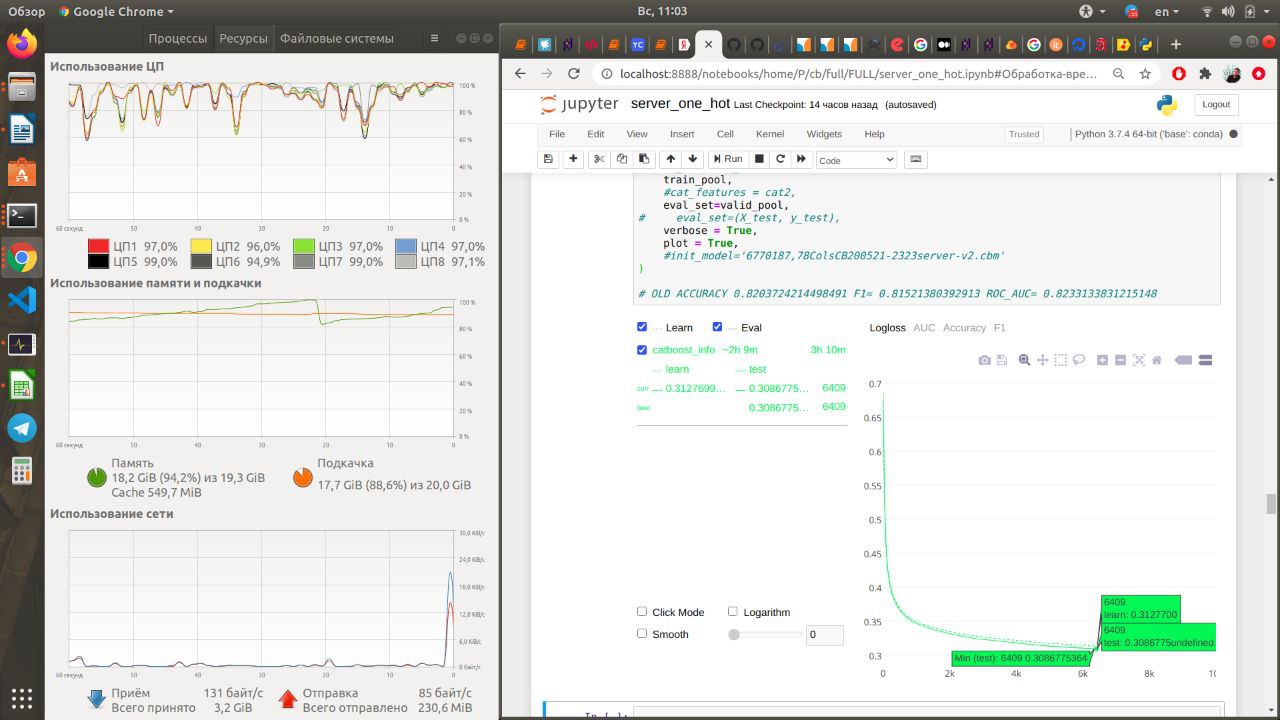

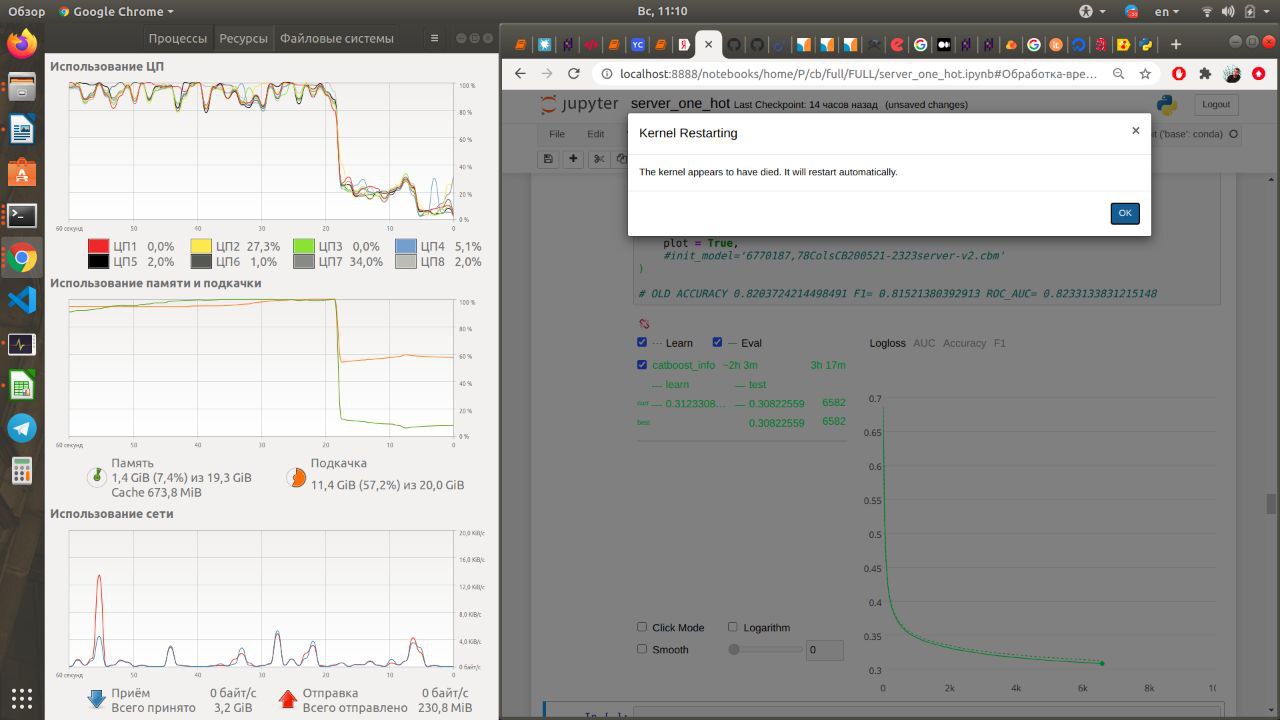

На рабочем ПК с ограниченным числом ресурсов свободной ram~ 20gb пытаюсь отработать часть данных для подбора гиперпараметров и их использовании на сервере с объемом датасета x20... used_ram_limit плохо работает... Мб я его неправильно задал?

Датасет 98фичей 1млн строк, 70%катег. Весит пару сотен Mb, обучение съедает 20гб свободной оперативы, ядро выбивает каждые 800 итераций...

Уменьшение итераций и увеличение learning_rate приводит к переобучению примерно на 100ой итерации, в итоге accuracy 0.65 Vs 0.87...

Есть примеры итеративного обучения и дообучения модели или что можно оптимизировать в параметрах обучения модели?

На рабочем ПК с ограниченным числом ресурсов свободной ram~ 20gb пытаюсь отработать часть данных для подбора гиперпараметров и их использовании на сервере с объемом датасета x20... used_ram_limit плохо работает... Мб я его неправильно задал?

Датасет 98фичей 1млн строк, 70%катег. Весит пару сотен Mb, обучение съедает 20гб свободной оперативы, ядро выбивает каждые 800 итераций...

Уменьшение итераций и увеличение learning_rate приводит к переобучению примерно на 100ой итерации, в итоге accuracy 0.65 Vs 0.87...

Есть примеры итеративного обучения и дообучения модели или что можно оптимизировать в параметрах обучения модели?

TG

TG

SK

Попробуйте

max_ctr_complexity=3 или даже max_ctr_complexity=2TG

Спасибо, а used_ram_limit правильно задал?

SK

Да, то что не сработало - больше похоже на какую-то нашу багу

TG

А какую функцию выполняет pool, если квантизацию не делал, а объявил только x_train, label и catfutures ?

L

Попробуй tsv файл сделать и загрузить его через пул. У меня файл размером 75гиг train и 27гиг validation, загруженные через пул вместе с cd файлом, занимают около 55 гигов памяти. Но у тебя большое количество cat features, возможно ещё из-за этого.

2021 June 17

OA

Товарищи, а по каким параметрам наиболее разумно гридсёрчиться в общем случае по классифаеру, что обычно даёт профит?

Сейчас перебираю learning rate, depth, l2 leaf reg. Думаю что-то добавить, глаза разбегаются.

Сейчас перебираю learning rate, depth, l2 leaf reg. Думаю что-то добавить, глаза разбегаются.

IL

Вот здесь описаны основные параметры, которые имеет смысл подбирать https://catboost.ai/docs/concepts/parameter-tuning.html

OA

Спасибо!

II

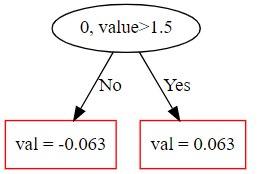

Добрый день, подскажите пожалуйста, как CatBoostRegressor считает конечные результаты?

Я написал небольшой скрипт, чтобы визуализировать дерево, построенное катбустом (model.plot_tree). Но значения в листьях отличаются от прогнозируемых значений (model.predict). Также я нашёл, что катбуст пересчитывает эти значения по формуле RawFormulaVal, но я нигде не могу найти эту формулу.

Код:

import pandas as pd

from catboost import CatBoostRegressor

features = pd.DataFrame({'feature_1':[1,2]})

target = pd.DataFrame({'c':[3,4]})

model_tmp = CatBoostRegressor(iterations=1, depth=1, verbose=0)

model_tmp.fit(features, target)

print('Result:', model_tmp.predict([1]))

Я написал небольшой скрипт, чтобы визуализировать дерево, построенное катбустом (model.plot_tree). Но значения в листьях отличаются от прогнозируемых значений (model.predict). Также я нашёл, что катбуст пересчитывает эти значения по формуле RawFormulaVal, но я нигде не могу найти эту формулу.

Код:

import pandas as pd

from catboost import CatBoostRegressor

features = pd.DataFrame({'feature_1':[1,2]})

target = pd.DataFrame({'c':[3,4]})

model_tmp = CatBoostRegressor(iterations=1, depth=1, verbose=0)

model_tmp.fit(features, target)

print('Result:', model_tmp.predict([1]))

II

и дерево:

II

Предсказанное значение = 3.4375

IL

Привет! Все дело в boost_from_average, который выставлен по умолчанию для RMSE. Обучение начинается не с 0, а со среднего таргета, то есть с 3.5 в твоем примере. Этот начальный отступ можно получить с помощью

model_tmp.get_scale_and_bias()

model_tmp.get_scale_and_bias()

II

точно! всё понятно, если посмотреть на эти значения!

спасибо большое!

спасибо большое!

VS

Добрый день, умирает ядро при использовании GPU (прямо на примере из документации https://catboost.ai/docs/features/training-on-gpu.html). Версии вроде соответствуют требованиям:

catboost 0.26

Windows 10 Pro 20H2 (10.0.19042.782)

NVIDIA GeForce GTX 1650 Ti

NVIDIA-SMI 451.82

Driver Version: 451.82

CUDA Version: 11.0

При этом tensorflow с GPU работает исправно. Как я могу устранить проблему? Буду рад любым идеям.

catboost 0.26

Windows 10 Pro 20H2 (10.0.19042.782)

NVIDIA GeForce GTX 1650 Ti

NVIDIA-SMI 451.82

Driver Version: 451.82

CUDA Version: 11.0

При этом tensorflow с GPU работает исправно. Как я могу устранить проблему? Буду рад любым идеям.

VS

Забыл написать, на версии 0.25.1 работает исправно

SK

Привет, я дебажу это прям сейчас)