OO

Size: a a a

2018 December 29

У меня по 800 итераций и низкий learning rate

AK

С 0.12 есть проблема сейчас со скоростью cv на GPU по умолчанию. Она исправлена в master ветке на github, но еще не выехала на pypi. Пока я бы рекомендовал ставить iterations_batch_size у cv равным числу всех итераций.

OO

А такая ошибка это потому что Cuda видяха не поддерживает ?

Это реальной строкой кода делается ?

task_type=‘GPU’?

Это реальной строкой кода делается ?

task_type=‘GPU’?

OO

С 0.12 есть проблема сейчас со скоростью cv на GPU по умолчанию. Она исправлена в master ветке на github, но еще не выехала на pypi. Пока я бы рекомендовал ставить iterations_batch_size у cv равным числу всех итераций.

А что значит этот показатель? Это скорость на проце

OO

Я пока не пользовался им

OO

Это не вопрос по использованию. Но кто какие методы отбора признаков использует при отборе признаков? Кроме как поочередное исключение на кросс-валидации. Что я имею ввиду. В целом бустинг делает сплиты по всем признаком, да и выкидывать самые бесполезные по версии сплитов с точки зрения метрик не всегда хорошая идея.

Наверное проще для числовых/бинарных взять логрег и посмотреть на веса.

Наверное проще для числовых/бинарных взять логрег и посмотреть на веса.

Ну судя по Pydata нужно юзать

Model.get.feauture.importance для рейтинга признаков

Model.get.feauture.importance для рейтинга признаков

OO

А если изобрёл новый , то catboost_evaluation и смотреть p_value

Если менее 0.05, то предиктор good и стоит брать

Если менее 0.05, то предиктор good и стоит брать

AK

Cv считает итерации блоками на каждом фолде, а потом для всех итераций в этом блоке на всех фолдах усредняет метрики. Этот параметр - размер блока, для Gpu по умолчанию он сейчас занижен относительно оптимального.

OO

Cv считает итерации блоками на каждом фолде, а потом для всех итераций в этом блоке на всех фолдах усредняет метрики. Этот параметр - размер блока, для Gpu по умолчанию он сейчас занижен относительно оптимального.

Понял , попробую .

А что делать с такой ошибкой на cv?

Training has stopped (degenerate solution on iteration 10, probably too small l2-regularization, try to increase it)

По дефолту он 3, поставить 5?

А что делать с такой ошибкой на cv?

Training has stopped (degenerate solution on iteration 10, probably too small l2-regularization, try to increase it)

По дефолту он 3, поставить 5?

AC

AC

очень интересная, катбуст кажется делает это по дефолту из коробки чуть ли не с самого начала)

AC

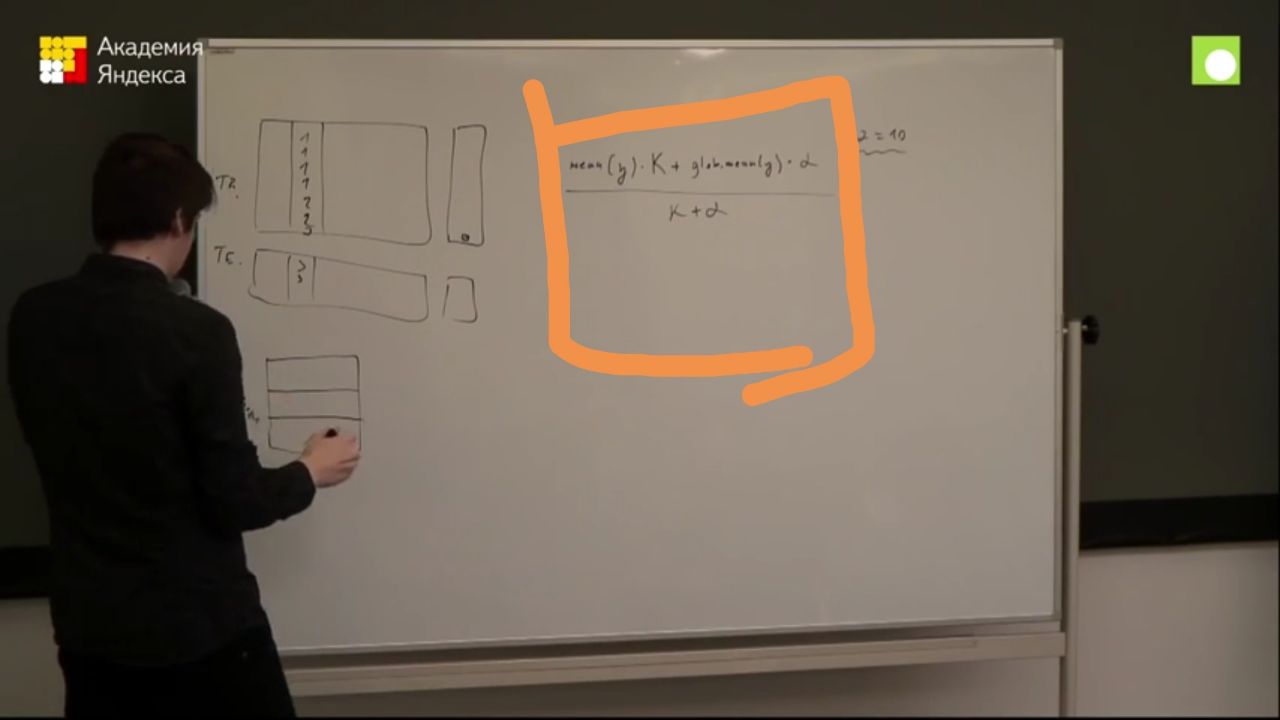

Коллеги, вот говорят, что катбуст делает регуляризованный mean encoding. А как выбирается alpha?

OO

Кстати сделал оптимизацию по Auc

Получил Auc =0.95

Accuracy =0.89

Precision =0.6

Как вообще можно объяснить такую аномалию в задаче бинарной классификации ?

Получил Auc =0.95

Accuracy =0.89

Precision =0.6

Как вообще можно объяснить такую аномалию в задаче бинарной классификации ?

VK

Классы несбалансированные, например

OO

Да 0-80%, 1-20%

OO

Классы несбалансированные, например

На что тогда смотреть?

VK

Можно площадь под precision-recall кривой

OO

Можно площадь под precision-recall кривой

Auc ?

VK

ага, auc-pr

OO

ага, auc-pr

А что за auc-Pr? Catboost просто Auc разрешает