SA

Size: a a a

2020 February 18

A

2020 February 19

C

Алла Маюрова has been banned! Reason: CAS ban.

V

Cas ban

D

Message from . Chira deleted. Reason: external link (?)

РР

Рекомендательные системы для ритейла (вероятностные модели). Что скажите? Цена вопроса, сложность и опыт внедрения? Нужна консультация

МГ

всем привет.

может кто просветить

хочу заказать разработку программы.

обучение по примерам , а потом поиск похожего в новом файле.

где можно разместить заказ?

может кто просветить

хочу заказать разработку программы.

обучение по примерам , а потом поиск похожего в новом файле.

где можно разместить заказ?

2020 February 20

B

🔫 User кикнут — вернуть этого пользователя можно только разбаном в настройках чата.

Проголосовавшие за кик:

@twobeerornottwobear, @eto_j_kotek, @DefragmentedPanda, @TricksterRus, @torsello

Проголосовавшие за кик:

@twobeerornottwobear, @eto_j_kotek, @DefragmentedPanda, @TricksterRus, @torsello

VD

Vladimir

Нет, мне приснился сон как небольшие летательные аппараты двигались на реактивных турбинах без какого либо топлива. Типа на магнитном поле. Бред наверное 😃ну а в друг)))

VD

Жертвуешь временем компа?

GAN, lucky ticket, нейронка вместо cost function, согласие многих паралельно тренируемых нейронок (ошибки разные а правильный ответ более единообразен)

Жертвуешь возможность разметить данные заранее?

Active learning, другие варианты использовать confidence

Жертвуешь возможностью не-собирать другие данные?

Post-training (всех слоев или только пары последних если почти все классы совпадают до-после)

Кто знает еще - дополните

GAN, lucky ticket, нейронка вместо cost function, согласие многих паралельно тренируемых нейронок (ошибки разные а правильный ответ более единообразен)

Жертвуешь возможность разметить данные заранее?

Active learning, другие варианты использовать confidence

Жертвуешь возможностью не-собирать другие данные?

Post-training (всех слоев или только пары последних если почти все классы совпадают до-после)

Кто знает еще - дополните

Плюсы случайного леса

высокая точность предсказания, немного лишь уступающая бустингу

не очень чувствителен к выбросам

также, как и обычные деревья, не чувствителен к масштабу признаков

весьма хорошо работает из коробки

эффективно работает с большим числом признаков и классов

сложно переобучить

имеется возможность оценки важности признаков

возможно распрараллелить

Минусы случайного леса

хуже работет в случае разреженных признаков

также, как и обычные деревья, не умеет экстраполировать

склонен к переобучению на зашумленных данных

большой размер модели

Плюсы AdaBoost

данный алгоритм очень прост для реализации

эффективен с точки зрения вычислительной сложности

позволяет решать достаточно сложные задачи с помощью слабых моделей

фактически только два параметра настройки: класс моделей и их количество

обеспечивает высокую точность прогнозирования

прост для модификации

Плюсы GBM

один из наиболее мощных алгоритмов распознования

если использовать в качестве базовой модели решающее дерево, то не очень чувствителен к масштабу данных

множество способов улучшить алгоритм

общий подход к решению задачи

подходит под регрессию, классификацию и ранжирование

можно использовать произвольную функцию потерь (зависит от поставленной задачи)

есть очень хорошие готовые решения

Минусы

довольно трудоемкий алгоритм, если использовать много базовых моделей

в "чистой" реализации очень склонен к переобучению

не подходит для использования со сложными или сильными моделями

иногда довольно сложная настройка

неинтерпретируем

Slide Type

Минусы AdaBoost

использование сложных или сильных моделей приводит к переобучению

чувствительность к выбросам (им достаются самые высокие значения весов), что приводит к переобучению

практически не поддается интерпретации

желательно иметь достаточно большую выборку, иначе может привести к переобучению

высокая точность предсказания, немного лишь уступающая бустингу

не очень чувствителен к выбросам

также, как и обычные деревья, не чувствителен к масштабу признаков

весьма хорошо работает из коробки

эффективно работает с большим числом признаков и классов

сложно переобучить

имеется возможность оценки важности признаков

возможно распрараллелить

Минусы случайного леса

хуже работет в случае разреженных признаков

также, как и обычные деревья, не умеет экстраполировать

склонен к переобучению на зашумленных данных

большой размер модели

Плюсы AdaBoost

данный алгоритм очень прост для реализации

эффективен с точки зрения вычислительной сложности

позволяет решать достаточно сложные задачи с помощью слабых моделей

фактически только два параметра настройки: класс моделей и их количество

обеспечивает высокую точность прогнозирования

прост для модификации

Плюсы GBM

один из наиболее мощных алгоритмов распознования

если использовать в качестве базовой модели решающее дерево, то не очень чувствителен к масштабу данных

множество способов улучшить алгоритм

общий подход к решению задачи

подходит под регрессию, классификацию и ранжирование

можно использовать произвольную функцию потерь (зависит от поставленной задачи)

есть очень хорошие готовые решения

Минусы

довольно трудоемкий алгоритм, если использовать много базовых моделей

в "чистой" реализации очень склонен к переобучению

не подходит для использования со сложными или сильными моделями

иногда довольно сложная настройка

неинтерпретируем

Slide Type

Минусы AdaBoost

использование сложных или сильных моделей приводит к переобучению

чувствительность к выбросам (им достаются самые высокие значения весов), что приводит к переобучению

практически не поддается интерпретации

желательно иметь достаточно большую выборку, иначе может привести к переобучению

B

🔫 Fleya кикнут — вернуть этого пользователя можно только разбаном в настройках чата.

Проголосовавшие за кик:

@twobeerornottwobear, Yurii, @arthin, @DenisKalyshkin, @DefragmentedPanda

Проголосовавшие за кик:

@twobeerornottwobear, Yurii, @arthin, @DenisKalyshkin, @DefragmentedPanda

N

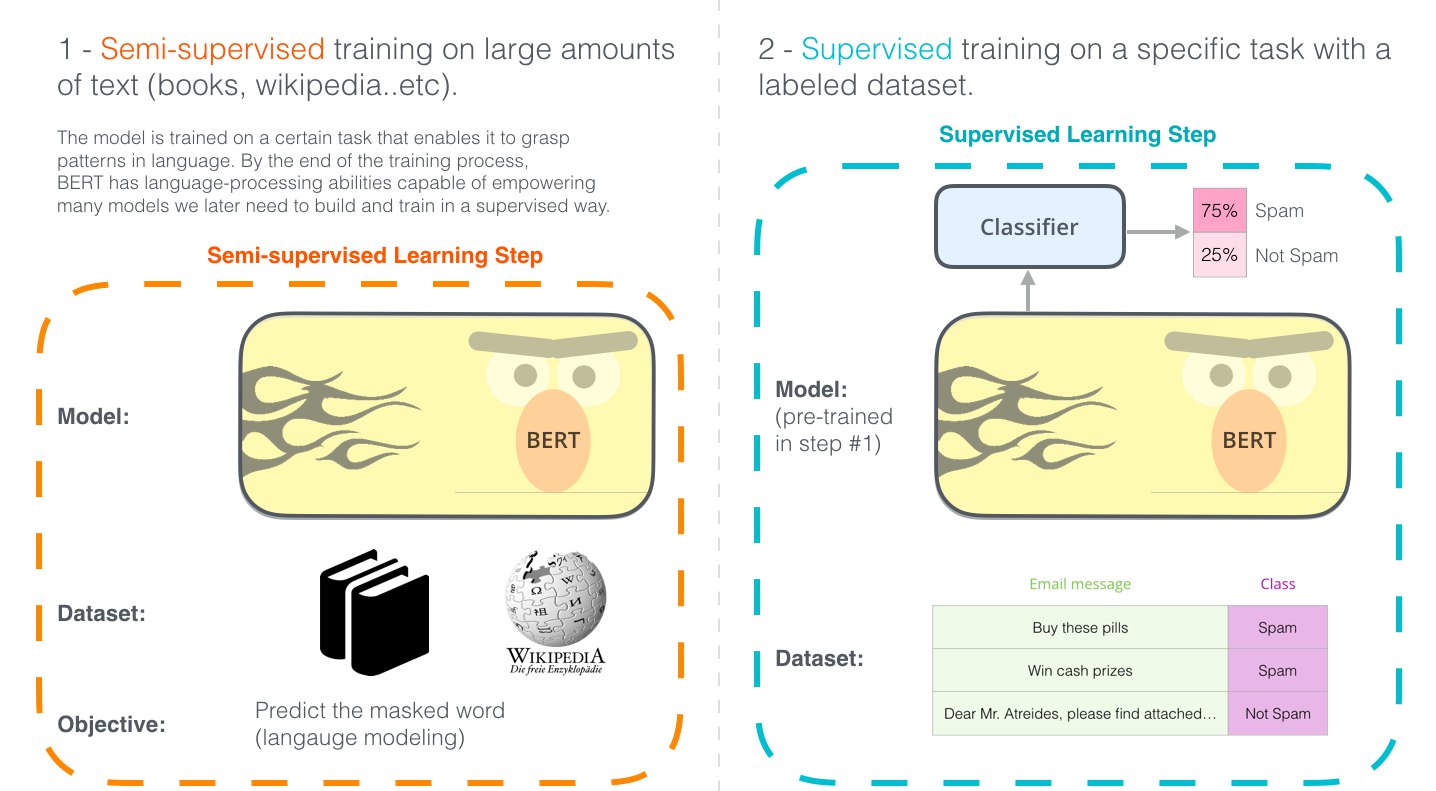

The Illustrated BERT, ELMo, and co. (How NLP Cracked Transfer Learning)

https://jalammar.github.io/illustrated-bert/

Habr ru: https://habr.com/ru/post/487358/

BERT FineTuning with Cloud TPUs notebook: https://colab.research.google.com/github/tensorflow/tpu/blob/master/tools/colab/bert_finetuning_with_cloud_tpus.ipynb

https://jalammar.github.io/illustrated-bert/

Habr ru: https://habr.com/ru/post/487358/

BERT FineTuning with Cloud TPUs notebook: https://colab.research.google.com/github/tensorflow/tpu/blob/master/tools/colab/bert_finetuning_with_cloud_tpus.ipynb

KP

На https://t.me/ICT_Moscow_chat планируется текстовая трансляция с OpenTalks.AI

SD

The Illustrated BERT, ELMo, and co. (How NLP Cracked Transfer Learning)

https://jalammar.github.io/illustrated-bert/

Habr ru: https://habr.com/ru/post/487358/

BERT FineTuning with Cloud TPUs notebook: https://colab.research.google.com/github/tensorflow/tpu/blob/master/tools/colab/bert_finetuning_with_cloud_tpus.ipynb

https://jalammar.github.io/illustrated-bert/

Habr ru: https://habr.com/ru/post/487358/

BERT FineTuning with Cloud TPUs notebook: https://colab.research.google.com/github/tensorflow/tpu/blob/master/tools/colab/bert_finetuning_with_cloud_tpus.ipynb

Вчера на туториалах хорошо рассказывали про Берт

V

Привет 👋