2*

Size: a a a

2019 December 26

Доволно интересная ветка ии для оценки рисков пока восновнов это отценка результтатов лотерей ное сть перспектива сделать модель многозадачной

B

🔫 @infodietolog кикнут — вернуть этого пользователя можно только разбаном в настройках чата.

Проголосовавшие за кик:

@twobeerornottwobear, @Haarrp, @VadosCo, @Wedjoyet, @roodyla

Проголосовавшие за кик:

@twobeerornottwobear, @Haarrp, @VadosCo, @Wedjoyet, @roodyla

2019 December 27

AT

точнее этих фронтах

Одним словом - плохо. Питон победил.

D

/help@GroupButler_bot

e

#aboutme

Канал - "блог" нейросети. Мнения ИИ о кино, технологиях, мировых проблемах, ответы на вопросы и т.д. Все посты сгенерированны нейросетью, логично. Материал, в основном, развлекательный, но не лишён смысловой нагрузки.

Линк здесь банят, поэтому вот так) @ muesli_ai

Канал - "блог" нейросети. Мнения ИИ о кино, технологиях, мировых проблемах, ответы на вопросы и т.д. Все посты сгенерированны нейросетью, логично. Материал, в основном, развлекательный, но не лишён смысловой нагрузки.

Линк здесь банят, поэтому вот так) @ muesli_ai

BA

Одним словом - плохо. Питон победил.

почему это плохо?

2*

почему это плохо?

потому что интеллект любит многообразие а питоща больше шаблонизатор 😍

2*

прогнозирвоанеи рсиков камуто интересно ?

SA

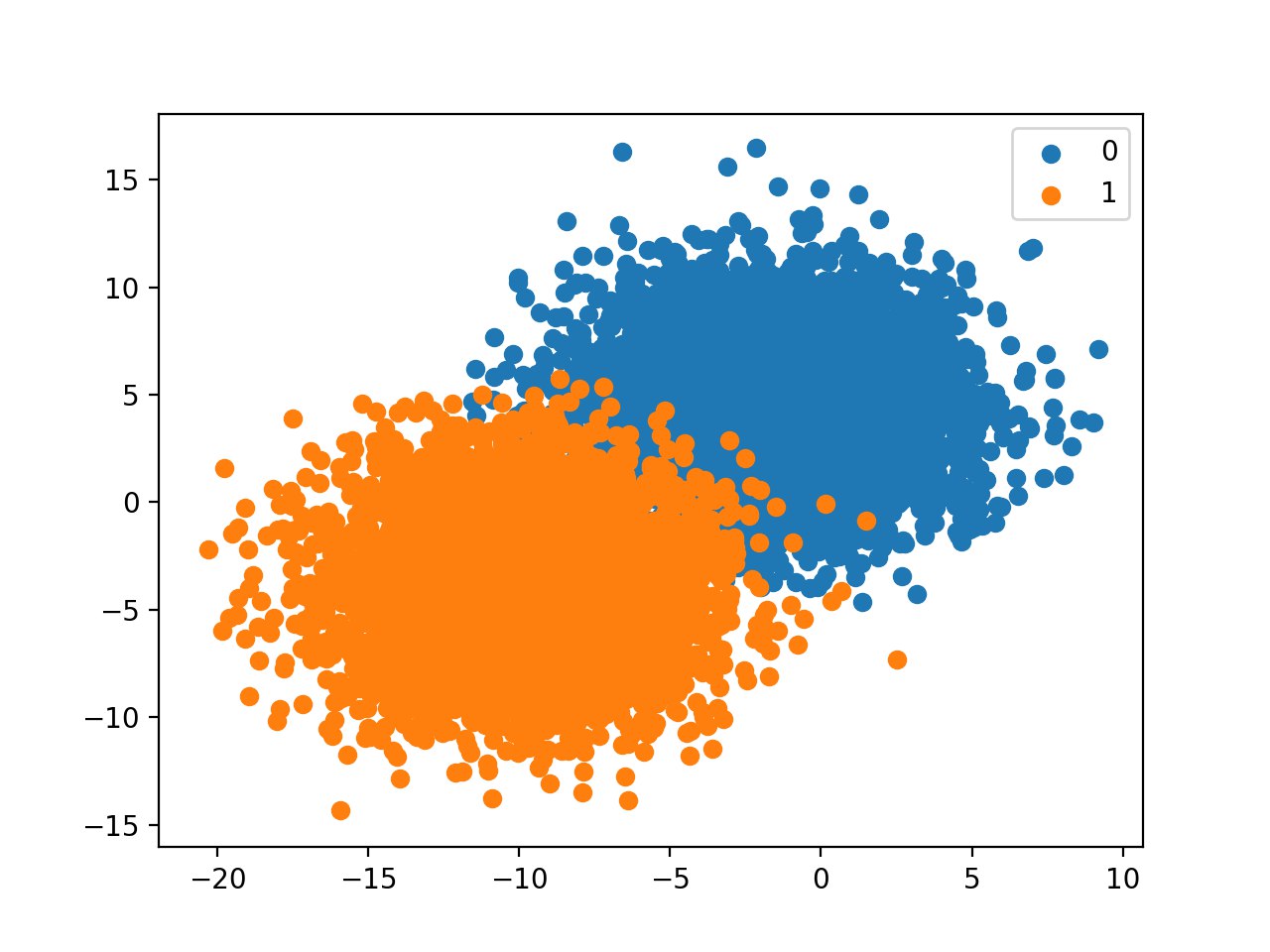

Develop an Intuition for Severely Skewed Class Distributions

https://machinelearningmastery.com/how-to-develop-an-intuition-skewed-class-distributions/

https://machinelearningmastery.com/how-to-develop-an-intuition-skewed-class-distributions/

Y

прогнозирвоанеи рсиков камуто интересно ?

Каких еще рисков?

BA

прогнозирвоанеи рсиков камуто интересно ?

моя идея

BA

Yurii

Каких еще рисков?

тех же рисков информационной безопасности

2019 December 31

A

Ребят, у меня здесь NLP задача и я был бы очень благодарен если бы подсказал в каком направлении двигаться!

Есть значит у меня телефонные разговоры операторов с абонентами (речь уже преобразована в текст , и уже произведена классификация того что говорит абонент, и то что говорит оператор). Задача выявить чем абонент разочарован, чтобы при последующим звонке того же абонента, оператор выдел на экране в чём разочарование состояло.

Сейчас все реализовано следующим образом: с помощью regular expressions ведётся поиск отрицательных слов, типа "разочарован", "зол", и т.д. Далее от каждого такого слова отчитывается десять слов в право и десять в лево (пунктуации в тексте нету, поэтому нельзя просто выбрать интересуемое предложение). Получаем кусок текста который потенциально несет negative sentiment. Если в одном разговоре таких слов много, то будет создано много кусков текста. Далее используется Vader из NLTK для скоринга каждого такого куска текста. Выбирается наиболее негативный кусок и он и показывается оператору, когда этот же абонент звонит в следующий раз.

Алгоритм не идеальный по многим причинам. Основная:

Vader приписывает значительный отрицательный скор, обрывкам теста, которые по сути являются набором бессвязных слов. Понятно что Vader не особо в этом виноват, так как такое качество исходного текста. К слову, я не могу повлиять на способ преобразования звука в текст :(

Есть значит у меня телефонные разговоры операторов с абонентами (речь уже преобразована в текст , и уже произведена классификация того что говорит абонент, и то что говорит оператор). Задача выявить чем абонент разочарован, чтобы при последующим звонке того же абонента, оператор выдел на экране в чём разочарование состояло.

Сейчас все реализовано следующим образом: с помощью regular expressions ведётся поиск отрицательных слов, типа "разочарован", "зол", и т.д. Далее от каждого такого слова отчитывается десять слов в право и десять в лево (пунктуации в тексте нету, поэтому нельзя просто выбрать интересуемое предложение). Получаем кусок текста который потенциально несет negative sentiment. Если в одном разговоре таких слов много, то будет создано много кусков текста. Далее используется Vader из NLTK для скоринга каждого такого куска текста. Выбирается наиболее негативный кусок и он и показывается оператору, когда этот же абонент звонит в следующий раз.

Алгоритм не идеальный по многим причинам. Основная:

Vader приписывает значительный отрицательный скор, обрывкам теста, которые по сути являются набором бессвязных слов. Понятно что Vader не особо в этом виноват, так как такое качество исходного текста. К слову, я не могу повлиять на способ преобразования звука в текст :(

A

Какие есть идеи на сегодняшний день:

1) Попробовать другие pre-trained модели (какие порекомендуете?).

2) Попробовать отследить где начинается предложение с негативным словом и где оно заканчивается (есть ли разработанные модели для этого?).

3) Модель которая бы говорила что-то вроде "этот кусок текста мусор и его оценивать не надо, его выкидываем".

4) Topic modeling. То есть все негативные куски текста классифицировать по топикам.

5) Выкинуть этап с regular expressions.

6) Сделать тестовые данные для модели, а не использовать pre-trained модель

1) Попробовать другие pre-trained модели (какие порекомендуете?).

2) Попробовать отследить где начинается предложение с негативным словом и где оно заканчивается (есть ли разработанные модели для этого?).

3) Модель которая бы говорила что-то вроде "этот кусок текста мусор и его оценивать не надо, его выкидываем".

4) Topic modeling. То есть все негативные куски текста классифицировать по топикам.

5) Выкинуть этап с regular expressions.

6) Сделать тестовые данные для модели, а не использовать pre-trained модель