AG

node_selector = {

"beta.kubernetes.io/os" = "linux"

} именно так заработало

node_selector {

"beta.kubernetes.io/os" = "linux"

}так ругалось

спасибо!

Size: a a a

AG

node_selector = {

"beta.kubernetes.io/os" = "linux"

} node_selector {

"beta.kubernetes.io/os" = "linux"

}KT

resource "kubernetes_secret" "example_tls" {

type = "kubernetes.io/tls"

metadata {

name = "example-tls"

}

data = {

"tls.crt" = file("./tls/example.crt")

"tls.key" = file("./tls/example.key")

}

}

resource "kubernetes_ingress" "admin_ingress" {

metadata {

name = "admin-ingress"

}

spec {

backend {

service_name = "admin-ui"

service_port = 80

}

tls {

hosts = ["*.example.com"]

secret_name = "example-tls"

}

}

}AR

resource "kubernetes_secret" "example_tls" {

type = "kubernetes.io/tls"

metadata {

name = "example-tls"

}

data = {

"tls.crt" = file("./tls/example.crt")

"tls.key" = file("./tls/example.key")

}

}

resource "kubernetes_ingress" "admin_ingress" {

metadata {

name = "admin-ingress"

}

spec {

backend {

service_name = "admin-ui"

service_port = 80

}

tls {

hosts = ["*.example.com"]

secret_name = "example-tls"

}

}

}KT

KT

IB

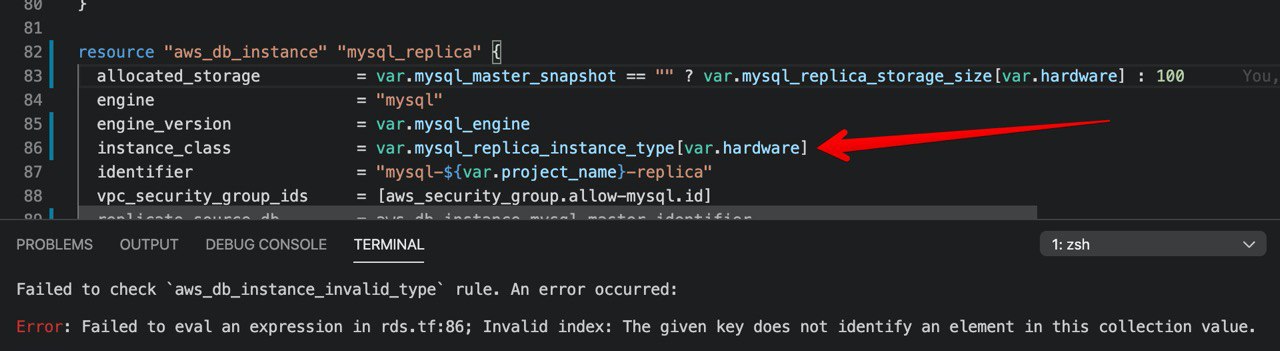

Failed to check `aws_db_instance_invalid_type` rule. An error occurred:

Error: Failed to eval an expression in rds.tf:86; Invalid index: The given key does not identify an element in this collection value.

IB

IB

terraform validate показываєт, что все норм.IB

hardware надо было задать дефолтное значениеA

AK

DZ

AK

N

resource "openstack_blockstorage_volume_v2" "rke_node_root_volume_workernode" {

count = local.cluster.workernodes.count

name = "rke-node-volume-workernodes-${count.index}"

size = local.cluster.etcd.volume_size

snapshot_id = data.openstack_blockstorage_snapshot_v2.rke_nodes_base-snap.id

}

resource "openstack_compute_instance_v2" "rke_node_etcd" {

for_each = "${join(",", openstack_blockstorage_volume_v2.rke_node_root_volume_etcd.*.id)}"

name = "${local.rke_cluster_name}-etcd-${each.key}"

....Error: Invalid for_each argument

on main.tf line 34, in resource "openstack_compute_instance_v2" "rke_node_etcd":

34: for_each = "${join(",", openstack_blockstorage_volume_v2.rke_node_root_volume_etcd.*.id)}"

The "for_each" value depends on resource attributes that cannot be determined

until apply, so Terraform cannot predict how many instances will be created.

To work around this, use the -target argument to first apply only the

resources that the for_each depends on.

A

A

A

N

A

N