Про тестирование UX и то, должен ли им заниматься QA инженер.

Говорить о качестве UX довольно сложно.

Прежде всего потому, что UX - это история, в которой смешивается всё: ожидания и привычки пользователей, хотелки и представления о прекрасном у дизайнеров и продакт оунеров, гайдлайны платформы, тренды дизайна интерфейсов, технические ограничения и особенности реализации продукта.

Зачастую нельзя чётко сказать “здесь плохой UX”, “здесь хороший UX”.

Его, этого самого UX, качество выражается только в метриках - конверсии, вовлеченности, ретеншене, количестве обращений в саппорт и т.д.

Тестирование UX - гораздо больше про фокус группы, аб-тесты и тестирование гипотез, чем про тест-кейсы и бинарные проверки.

В результате, тестирование UX почти полностью переходит в ответственность тех, кто занимается проверкой этих гипотез - настраивает а/б-тесты, собирает фокус группы, мониторит пользовательскую аналитику и продуктовые метрики.

Где-то этим занимаются аналитики, где-то менеджеры продукта, где-то дизайнеры, где-то отдельные команды UX-дизайнеров\исследователей.

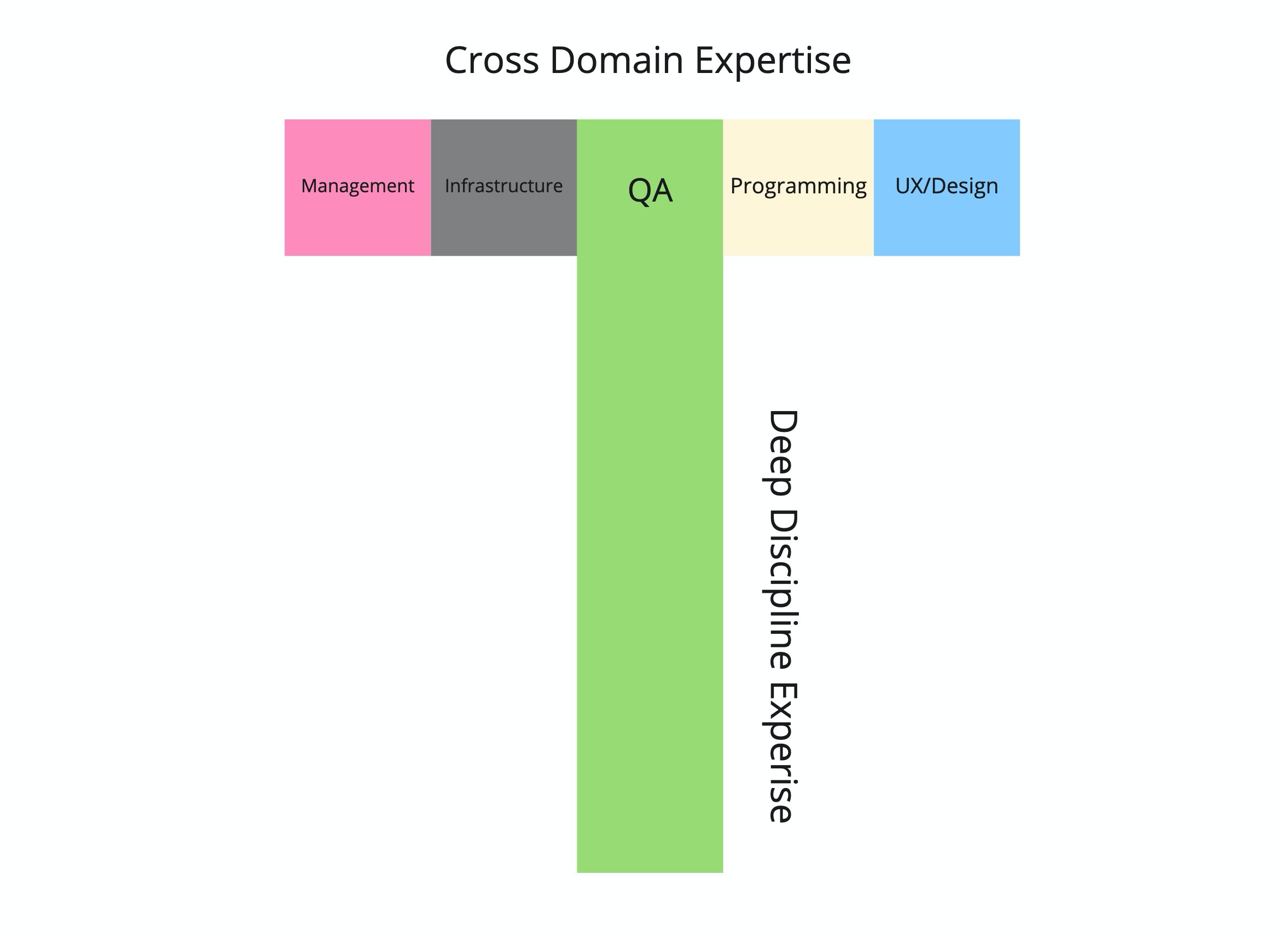

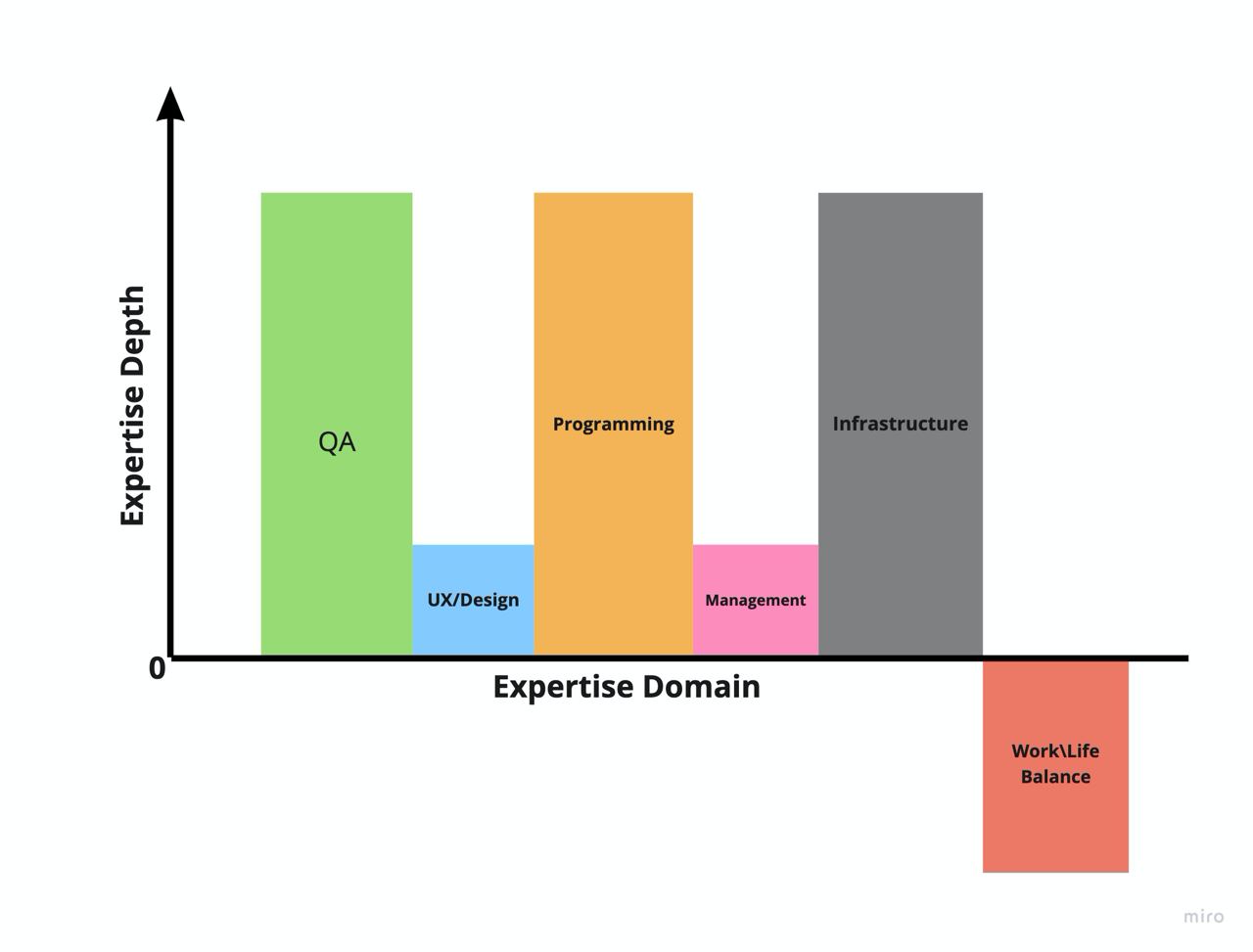

Значит ли это, что QA инженеров это не касается? В целом, нет.

Как и во множестве других случаев, задача QA здесь - предоставить дополнительную экспертизу и информацию ребятам, отвечающим за UX.

Дать фидбэк, задать вопросы, посоветовать или предложить что-то относительно гипотез, которые выдвигаются, их реализации и результатов проверки.

Вы можете указать на кейс, который они упустили, на конфликт с другими АБ-тестами или событиями, указать на неконсистентность или противоречие стандартам и гайдлайнам платформы, предложить другой вариант реализации и т.д.

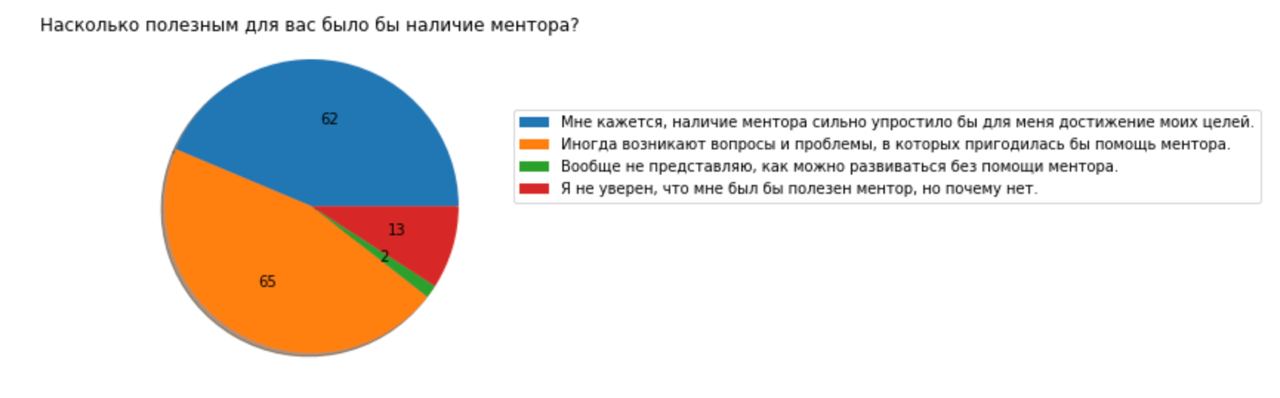

Помните, что тестирование UX - это дорого. Организация фокус групп требует серьезной работы, большого количество времени и денег.

А\Б тесты требуют времени на составление, поддержку и анализ результатов (и повышают сложность системы).

Поэтому, чем раньше вы придете с фидбэком или идеями к коллегам - тем лучше.

Главное, что бы этот фидбэк был полезным.

И, в целом, чем больше у вас экспертизы в UX - тем больше шансов давать действительно полезный фидбэк.

Откуда брать экспертизу?

Учитесь.

Есть миллионы видео и куча интересных книжек про UX, дизайн и поведение пользователей.

Например, можно начать с классической

Dont Make Me Think и книжки

Эдварда Сталла про UX.

Изучайте гайдлайны платформ, стандарты отрасли и требования. В некоторых случаях это просто набор рекомендаций, в других - это обязательные стандарты и требования сертификации.

Довольно часто они содержат в себе довольно серьёзные требования к UX и интерфейсам.

Например, почитайте

Apple HIG, если вы делаете приложение под iOS или ISO-13485 если ваш продукт - медицинское изделие.

Повышайте насмотренность интерфейсов.

Смотрите на конкурентов и просто популярные приложения, читайте и смотрите рассказы от ребят, следите за тем, что происходит в отрасли.

Это помогает понять, как другие команды решают типовые проблемы, какие есть варианты и на что стоит ориентироваться.

Смотрите на фидбэк пользователей.

Но не забывайте, что хороший фидбэк приходит реже, чем плохой.

Работайте с метриками.

Обсуждайте гипотезы, следите за результатами экспериментов, пытайтесь понять, что работает для ваших пользователей.

Даже если это не входит в ваши непосредственные обязанности.