К

Size: a a a

2020 December 07

МС

А если dont_merge_cookies=true поставить, то по-идее это должно решить проблему?

"To create a request that does not send stored cookies and does not store received cookies, set the dont_merge_cookies key to True in request.meta."

кажется оно по другому работатет

кажется оно по другому работатет

D

"To create a request that does not send stored cookies and does not store received cookies, set the dont_merge_cookies key to True in request.meta."

кажется оно по другому работатет

кажется оно по другому работатет

Почему? Ровно так. Я прописываю свои куки в хедер, а сохраненные не передаются и не получаются ни в какие джары.

МС

Ну, хз. Мне показалось что ты не через Хидер передаеш

A

'DOWNLOADER_MIDDLEWARES': {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

'scrapy_user_agents.middlewares.RandomUserAgentMiddleware': 700,

'rotating_proxies.middlewares.RotatingProxyMiddleware': 610,

'rotating_proxies.middlewares.BanDetectionMiddleware': 620,

}, почему не ротейтит ЮА ?A

с каждим запросом

К

Andrii

'DOWNLOADER_MIDDLEWARES': {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

'scrapy_user_agents.middlewares.RandomUserAgentMiddleware': 700,

'rotating_proxies.middlewares.RotatingProxyMiddleware': 610,

'rotating_proxies.middlewares.BanDetectionMiddleware': 620,

}, почему не ротейтит ЮА ?

A

да, вот так у меня

custom_settings = {

"ROTATING_PROXY_LIST": [

'http://22225',

],

'DOWNLOADER_MIDDLEWARES': {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

'scrapy_user_agents.middlewares.RandomUserAgentMiddleware': 700,

'rotating_proxies.middlewares.RotatingProxyMiddleware': 610,

'rotating_proxies.middlewares.BanDetectionMiddleware': 620,

},

'DOWNLOAD_DELAY': 0.7,

'HTTPCACHE_ENABLED': True,

'RANDOM_UA_PER_PROXY': True

}ГП

Народ посоветуйте норм уроки по splash + scrapy

B

Народ посоветуйте норм уроки по splash + scrapy

для начала лучше освоить документацию по scrapy

A

Народ посоветуйте норм уроки по splash + scrapy

К

Andrii

да, вот так у меня

custom_settings = {

"ROTATING_PROXY_LIST": [

'http://22225',

],

'DOWNLOADER_MIDDLEWARES': {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

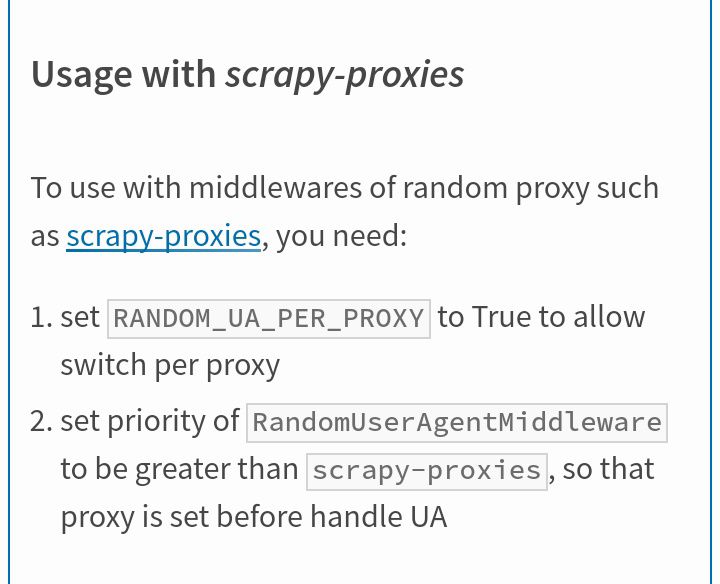

'scrapy_user_agents.middlewares.RandomUserAgentMiddleware': 700,

'rotating_proxies.middlewares.RotatingProxyMiddleware': 610,

'rotating_proxies.middlewares.BanDetectionMiddleware': 620,

},

'DOWNLOAD_DELAY': 0.7,

'HTTPCACHE_ENABLED': True,

'RANDOM_UA_PER_PROXY': True

}Тогда хз, может, что-то с обновлениями поломалось, пакет то старый. Дэбаж

П

Ребят. Кто работал со Scrapy, подскажите пжлст куда двигаться

Необходимо натравить паука на сайт, собрать все ссылки, и если они включают в себя /profiles/ - распарсить данные.

использовал rule, но проблема в том, что данные находятся в глубине примерно 3-4 и правила сразу отсекают все ссылки на главной

Необходимо натравить паука на сайт, собрать все ссылки, и если они включают в себя /profiles/ - распарсить данные.

использовал rule, но проблема в том, что данные находятся в глубине примерно 3-4 и правила сразу отсекают все ссылки на главной

AR

не используй rule

К

Ребят. Кто работал со Scrapy, подскажите пжлст куда двигаться

Необходимо натравить паука на сайт, собрать все ссылки, и если они включают в себя /profiles/ - распарсить данные.

использовал rule, но проблема в том, что данные находятся в глубине примерно 3-4 и правила сразу отсекают все ссылки на главной

Необходимо натравить паука на сайт, собрать все ссылки, и если они включают в себя /profiles/ - распарсить данные.

использовал rule, но проблема в том, что данные находятся в глубине примерно 3-4 и правила сразу отсекают все ссылки на главной

Или сразу давай такую страницу чтоб там были подходящие ссылки, или пиши ещё правила, чтоб довести паука до нужных страниц на которых есть нужные ссылки