AR

Size: a a a

2020 March 01

ладно, проехали

🇺L

https://hastebin.com/ - вообще крутая вещь, узнал из фака. жаль, что нельзя хранить свои пасты

AR

а что это?

2020 March 02

🇺L

https://hastebin.com/ugiyulades.rb

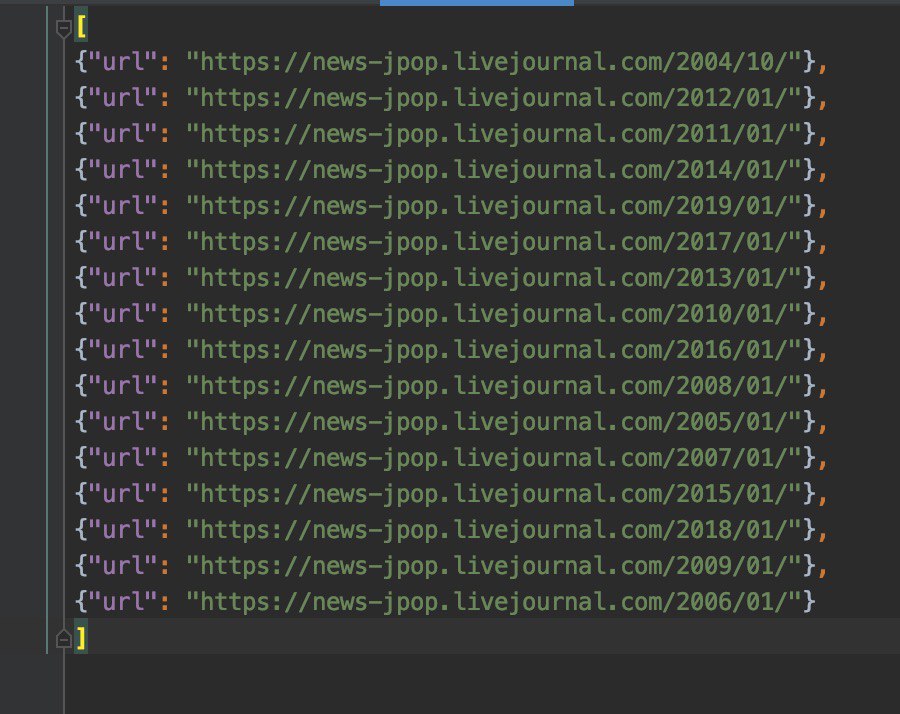

пытаюсь понять, делая runspider -o в json почему оно мне выводит вот такое, а не список всех URL с месяцами в каждом году.

пытаюсь понять, делая runspider -o в json почему оно мне выводит вот такое, а не список всех URL с месяцами в каждом году.

🇺L

Пытаюсь понять коллбэки, как ты и советовал

🇺L

А, кажется дошло. Вместо get должен быть getAll

🇺L

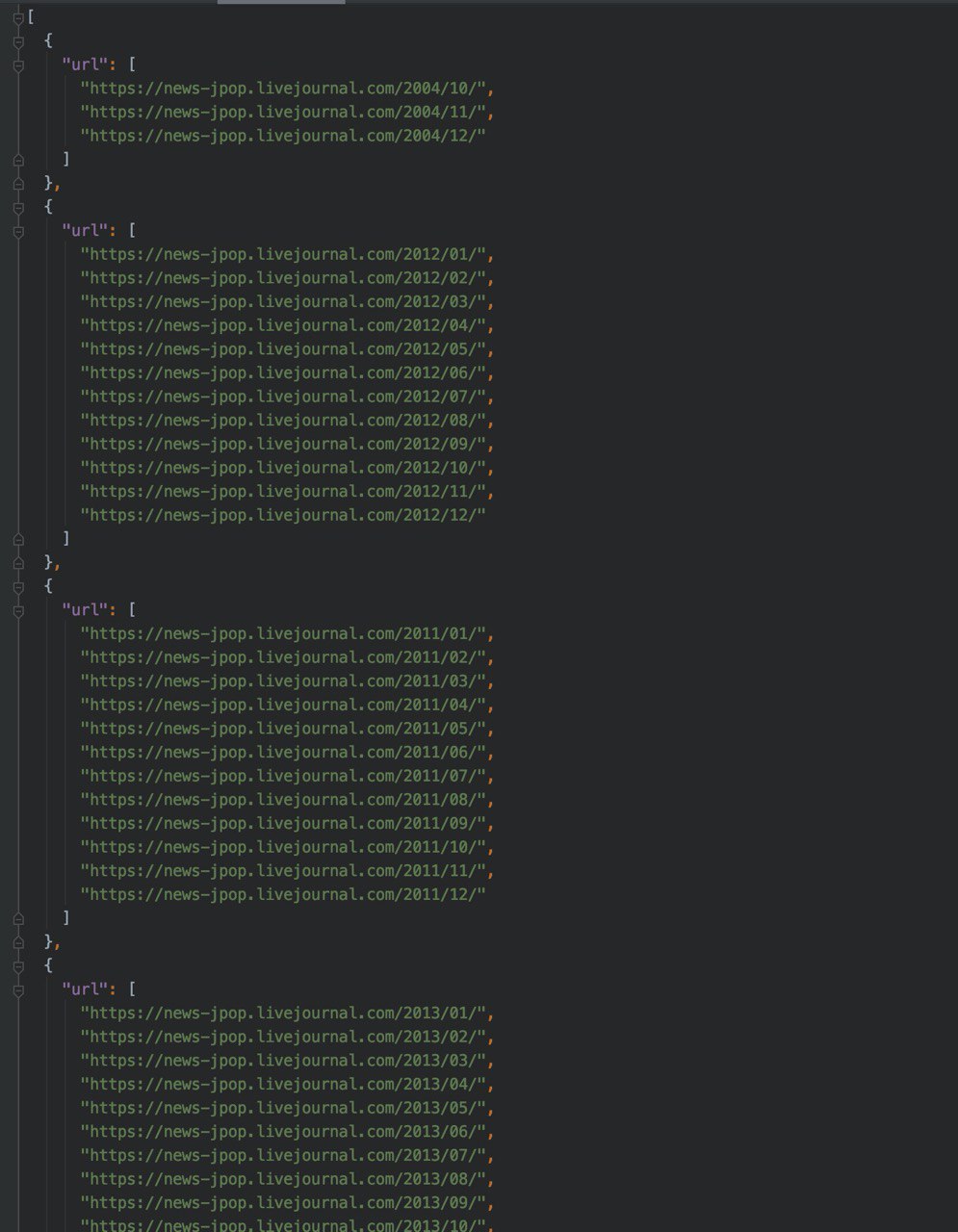

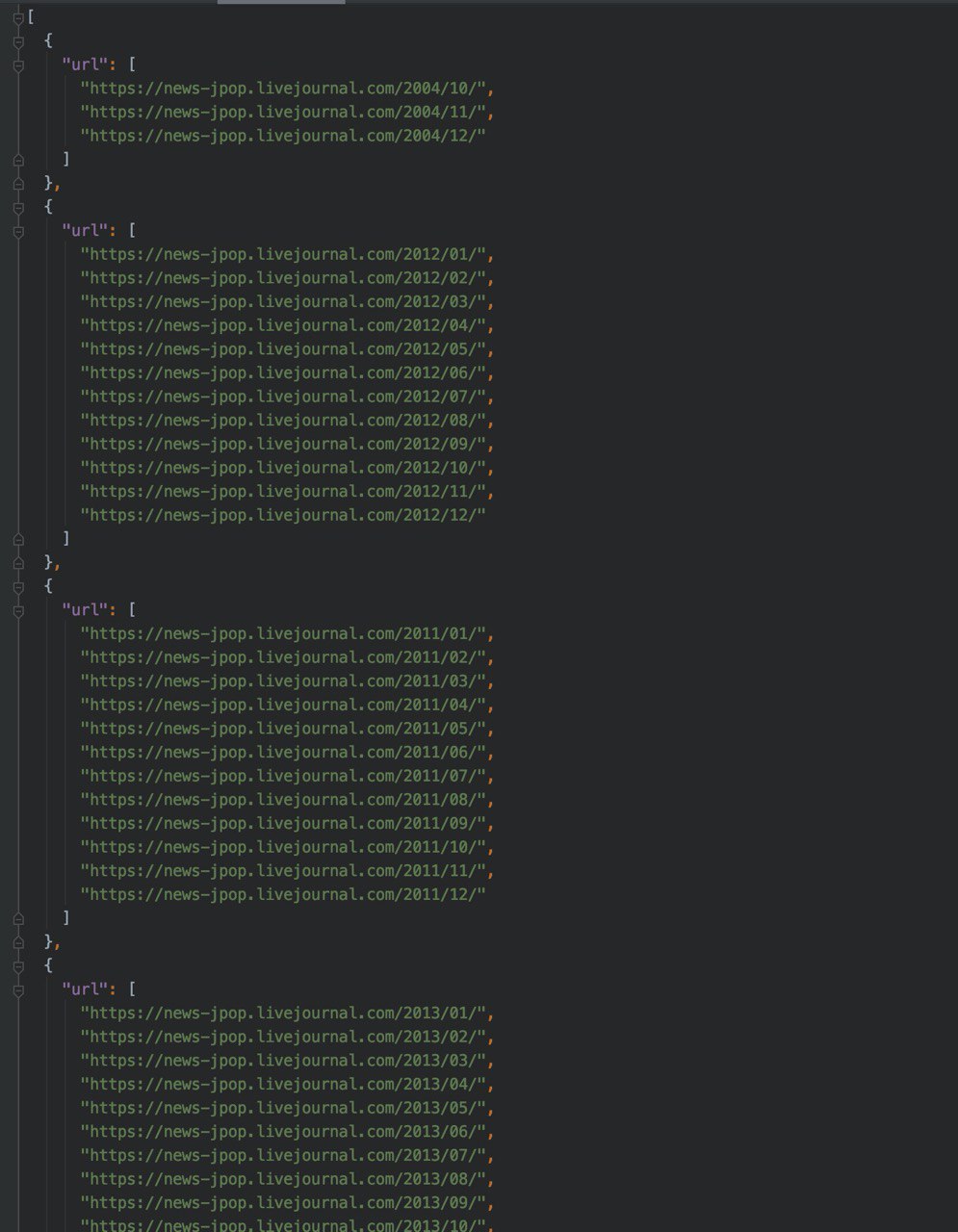

всё получилось. Но почему-то года идут не по порядку. можно ли как-то отсортировать года в json?

🇺L

https://hastebin.com/ifavebihih.rb - вот так у меня генерируется список всех URL с месяцами в году. Но я не могу понять куда мне привязать коллбэк для parse_day чтобы после того, как scrapy получила url месяца она поперла скрапить дни в нём

🇺L

а, дошло

🇺L

надо ещё for()

🇺L

Доброе утро. Чтобы избавиться от \n \r \t пишут, что надо использовать unicode.strip(). Но я не могу понять как его правильно применить: response.css('h1::text').extract().unicode.strip() не работает.

🇺L

так вообще можно, вместе с extract()? :)

🇺L

А, всё, дошло. strip() работает с extract_first() только. логично.

МС

Доброе утро. Чтобы избавиться от \n \r \t пишут, что надо использовать unicode.strip(). Но я не могу понять как его правильно применить: response.css('h1::text').extract().unicode.strip() не работает.

я так понимаю, ошибку выдивает?

records = response.css('h1::text').getall()

for rec in records:

rec = rec.strip()🇺L

я так понимаю, ошибку выдивает?

records = response.css('h1::text').getall()

for rec in records:

rec = rec.strip()Спасибо, это для меня слишком сложно пока. Я только extract() осваиваю.

МС

А, всё, дошло. strip() работает с extract_first() только. логично.

не, не дошло, стрип работает со строкой а не со списком, extract() все вхождения выдает, в виде списка

и да, напиши себе шпаргалку

и да, напиши себе шпаргалку

extratc() = getall()у тебя методы устаревшие, могут скоро вообще их вырезать

extract_first() = get()

🇺L

ок. тогда такой вопрос.

дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

>>> response.css('div.field--name-node-post-date::text').get().strip()

'10:55 17.02.2020'дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

МС

ок. тогда такой вопрос.

дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

>>> response.css('div.field--name-node-post-date::text').get().strip()

'10:55 17.02.2020'дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

ну, насчет MySQL не скажу, правда, на первый взгляд - не стандартная запись даты. Внутренние пробелы - обычно костылю решение. Хотя, может что и умное есть

AR

ок. тогда такой вопрос.

дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

>>> response.css('div.field--name-node-post-date::text').get().strip()

'10:55 17.02.2020'дохера пробелов между временем и датой. И вообще ее надо ручками парсить, чтобы привести в mysql date формат или что-то уже придумано до меня?

dateparser, но не знаю что такое mysql date, если это строка, то просто руками потом сгенерить из datetime

AR

всё получилось. Но почему-то года идут не по порядку. можно ли как-то отсортировать года в json?

Порядок зависит от того как спайдер страницы обошел и обычно это не проблема, если надо сортировать то уже потом, отдельно от спайдера