AR

Size: a a a

2020 February 17

а код неправильный, нельзя все подряд хедеры совать, как минимум Content-Length нельзя совать вручную никогда

АМ

я нубас просто 🌚

АМ

спасибо, пошел гуглить

АМ

curl -k 'https://yweb.ymcaboston.org/SpiritWeb/SearchClass' -H 'Content-Type: application/x-www-form-urlencoded' -H 'User-Agent: Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.17 Safari/537.36' -H 'Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9' -H 'Referer: https://yweb.ymcaboston.org/SpiritWeb/SearchClass' --data '_EXECEVENT=ONSEARCH&BRANCH_IDENTIFIER=&SELECT_AGE=&PPG_PROGRAM_IDENTIFIER=&POF_CLASS_IDENTIFIER=&_BRIEF_DESC=&SELECT_MONTH=&_CLASS_OFFERING_IDENTIFIER=&SORTBY=AGE' --compressedблин, и правда ж работает!

М

парни, посоветуйте как правильнее обыграть такой момент: с помощью сплеша заходим на страницу - там получает токен. с присутствием этого токена можем сделать запрос уже без сплеша несколько раз, для получения конечной информации. потом токен блочится и надо опять через сплеш заходить и получать новый токен. в общем на несколько обычных запросов необходимо заходить один раз сплешем на другую страницу и получать новый токен.

МС

тебе прям серьезное решение, или накостылить?

если более/менее серьезное, мое мнение, смотреть в сторону мидлварей.

взять за основу что-то вроде

https://github.com/TeamHG-Memex/scrapy-rotating-proxies

и препилить под себя

хотя тут то-же вопрос. У тебя на момент бана ведь уже есть 100500 реквестов в очереди, с протухшим токеном...

если более/менее серьезное, мое мнение, смотреть в сторону мидлварей.

взять за основу что-то вроде

https://github.com/TeamHG-Memex/scrapy-rotating-proxies

и препилить под себя

хотя тут то-же вопрос. У тебя на момент бана ведь уже есть 100500 реквестов в очереди, с протухшим токеном...

AB

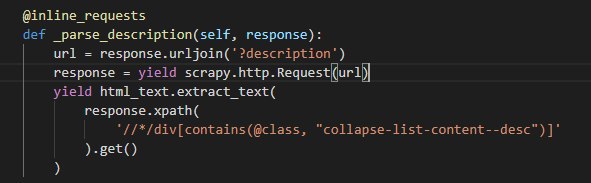

возвращаясь к inline_requests, чет не робит(

AB

response - не респонс, а реквест(

AB

а наверное проблема там где вызываю..

МС

стоп, а нахрена scrapy.http.Request?

разве не scrapy.Request должно быть?

разве не scrapy.Request должно быть?

AB

в примерах так

МС

om inline_requests import inline_requests

from scrapy import Spider, Request

class MySpider(Spider):

name = 'myspider'

start_urls = ['http://httpbin.org/html']

@inline_requests

def parse(self, response):

urls = [response.url]

for i in range(10):

next_url = response.urljoin('?page=%d' % i)

try:

next_resp = yield Request(next_url)

urls.append(next_resp.url)

except Exception:

self.logger.info("Failed request %s", i, exc_info=True)

yield {'urls': urls}

МС

хде?

AB

здесь https://github.com/rmax/scrapy-inline-requests ..... я правильно понимаю что этот генератор первым вызовом вернет реквест, а вторым дескрипшн

AB

?

МС

мой пример оттуда и есть :)

МС

попробуй scrapy.Request

AB

мой из examples) нет, не помогло

AB

это одно и тоже вангую))