YB

Size: a a a

2018 July 22

Дай через полчаса доберусь до компа и выведу рантайм параметры

YB

ID:347198853

то что сжимают картинки это понятно, непонятно зачем использовать фильтры (41,11) и (21,11)

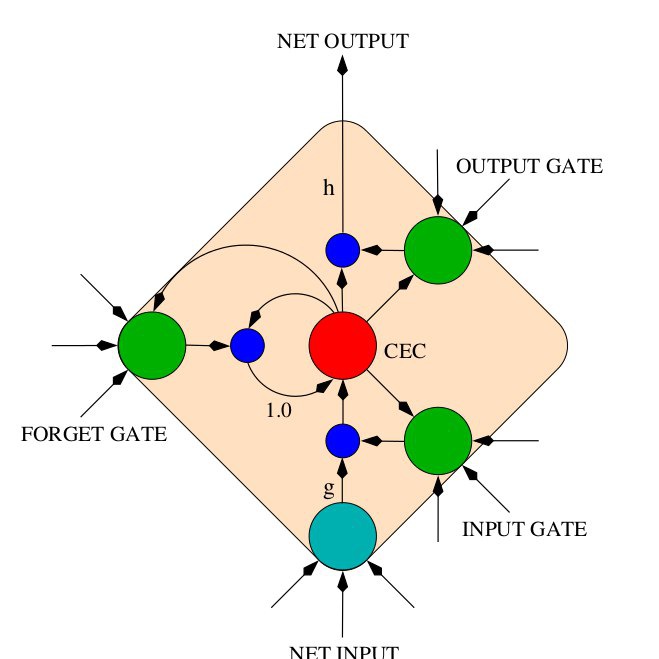

Почитай работу, там рисунок даже есть

NK

читал, но там просто указаны параметры без какого-либо обьяснения

NK

а вообще, у тебя есть интуиция насчет какие изменения модели помогают больше всего? Например, conv layers, or LSTM/GRU cells, or batchnorm, or more layers, etc?

NK

кстати, какой у тебя "комбинированный английский датасет"?

NK

в librispeech 1000 часов, где взять еще 1000?

YB

ID:347198853

в librispeech 1000 часов, где взять еще 1000?

Currently supports AN4, TEDLIUM, Voxforge and LibriSpeech

YB

ID:347198853

а вообще, у тебя есть интуиция насчет какие изменения модели помогают больше всего? Например, conv layers, or LSTM/GRU cells, or batchnorm, or more layers, etc?

вообще, я уже много экспериментов делал, LSTM > GRU > RNN, но и скорость сильно падает. Аналогично, ширина у LSTM и количество слоёв помогает, но при увеличении ширины падает скорость тренировки и увеличивается время обучения.

KS

вообще, я уже много экспериментов делал, LSTM > GRU > RNN, но и скорость сильно падает. Аналогично, ширина у LSTM и количество слоёв помогает, но при увеличении ширины падает скорость тренировки и увеличивается время обучения.

А свёртки какие используешь?

AB

А есть ли натренированная модель, которая генерит речь по транскрипции слов, а не по самим словам? Выдирать из Wiktionary транскрипцию ручками это дикость.

YB

А есть ли натренированная модель, которая генерит речь по транскрипции слов, а не по самим словам? Выдирать из Wiktionary транскрипцию ручками это дикость.

а зачем транскрипцию брать? DS2 не нужна транскрипция вообще

AB

а зачем транскрипцию брать? DS2 не нужна транскрипция вообще

ну ... мне так нужно.

YB

ну ... мне так нужно.

ну возьми словарь с транскрипциями тогда. из Voxforge для англ и для рус, скажем

AB

да у меня редкий язык. корпуса совсем нет. может есть где вводишь транскрипцию в IPA, а она ее произносит.

NK

Currently supports AN4, TEDLIUM, Voxforge and LibriSpeech

я сейчас тренирую на train-clean-100 + train-clean-360. Насколько поможет увеличение датасета?

YB

А свёртки какие используешь?

я изначально экспериментировал со своими аугментациями, свёртками, Dropout, параметрами фурье. но они особо преимущества не дают -- всё в языковую модель и разнообразие в датасете упирается.

NK

то есть у меня цель это результат на test-clean

YB

ID:347198853

я сейчас тренирую на train-clean-100 + train-clean-360. Насколько поможет увеличение датасета?

чем больше датасет, тем выше качество. бери все 2000 часов и простые аугментации из пакета, получишь WER около 7% на test-clean .

YB

я ещё хочу 430 часов из mozilla взять, давайте просто потом всё для английского выложу в open-source вместе с натренированными моделями.

YB

https://github.com/SeanNaren/deepspeech.pytorch очень шустрый, ему нужно 4 часа на эпоху с 2000 часами речи на одной GTX 1080 . за сутки-двое уже отличный результат, ещё сутки-двое дают снижение WER с 8% до 7% на clean, или типа того.