AA

Size: a a a

2021 April 23

Там же делается снапшот, мигрируется основа, потом пауза машины и пробуем долить изменения со снапшота за таймаут, если нет увеличиваем время, если несколько увеличений не вышло- завершаем с ошибкой

AA

Там есть env файла экзампл где можно указать что делать а что нет. Копируешь в файл с таким же названием без example и редактируешь его.

AA

Ага, ток написано же с потерей данных )

I

тогда это не может конвертированием зваться.

AA

Ну в итоге же получится то что хочется )

AA

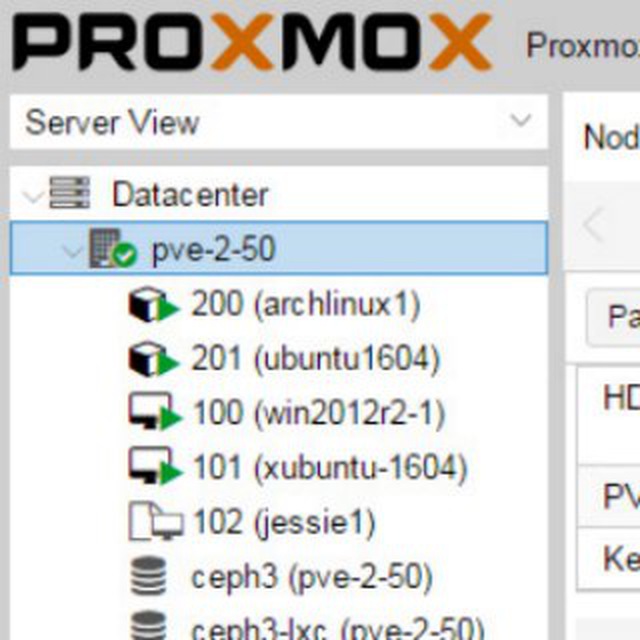

Эх, хотел скриншот...

AA

Convert from LVM to ZFS (lvm-2-zfs.sh) run once

Converts the a MDADM BASED LVM into a ZFS raid 1 (mirror)

Defaults to mount point: /var/lib/vz

Optional: specify the LVM_MOUNT_POINT ( ./lvm-2-zfs.sh LVM_MOUNT_POINT )

Creates the following storage/rpools

zfsbackup (rpool/backup)

zfsvmdata (rpool/vmdata)

/var/lib/vz/tmp_backup (rpool/tmp_backup)

Will automatically detect the required raid level and optimise.

1 Drive = zfs

2 Drives = mirror

3-5 Drives = raidz-1

6-11 Drives = raidz-2

11+ Drives = raidz-3

NOTE: WILL DESTROY ALL DATA ON LVM_MOUNT_POINT

AA

Последняя строчка

2021 April 24

w

Только, если ms sql развернуть надо

w

Там 64к

AA

В zfs только ashift надо менять в зависимости от реального размера сектора на диске (дефолтные 12 это для 4к) и включение сжатия, как ни странно, ускоряет работу даже на серверных sata ssd

AA

И ограничить используемую память, до неё он очень охотлив

AP

Или не парить моск и не использовать зфс, как Линус завещал.

AA

В проксмоксе это один из двух с половиной способов сделать распределённое хранилище

AA

Ceph и неподдерживаемое самими разработчиками Drbd

SM

Буквально вчера тестировал RAIDZ2 с помощью fio:

команда: fio --filename=./file --size=4GB --direct=1 --rw=randrw --bs=64k --ioengine=libaio --iodepth=64 --runtime=120 --numjobs=4 --time_based --group_reporting --name=throughput-test-job --eta-newline=1

Результат для блока 8k:

Run status group 0 (all jobs):

READ: bw=77.4MiB/s (81.2MB/s), 77.4MiB/s-77.4MiB/s (81.2MB/s-81.2MB/s), io=9302MiB (9754MB), run=120105-120105msec

WRITE: bw=77.6MiB/s (81.3MB/s), 77.6MiB/s-77.6MiB/s (81.3MB/s-81.3MB/s), io=9316MiB (9769MB), run=120105-120105msec

Disk stats (read/write):

sda: ios=148443/148718, merge=139/248, ticks=13259629/17094904, in_queue=29760664, util=100.00%

Результат для блока 128k:

Run status group 0 (all jobs):

READ: bw=222MiB/s (233MB/s), 222MiB/s-222MiB/s (233MB/s-233MB/s), io=26.0GiB (27.9GB), run=120033-120033msec

WRITE: bw=222MiB/s (233MB/s), 222MiB/s-222MiB/s (233MB/s-233MB/s), io=26.0GiB (27.9GB), run=120033-120033msec

Disk stats (read/write):

sda: ios=425074/425388, merge=572/637, ticks=13323836/17087667, in_queue=28751116, util=100.00%

команда: fio --filename=./file --size=4GB --direct=1 --rw=randrw --bs=64k --ioengine=libaio --iodepth=64 --runtime=120 --numjobs=4 --time_based --group_reporting --name=throughput-test-job --eta-newline=1

Результат для блока 8k:

Run status group 0 (all jobs):

READ: bw=77.4MiB/s (81.2MB/s), 77.4MiB/s-77.4MiB/s (81.2MB/s-81.2MB/s), io=9302MiB (9754MB), run=120105-120105msec

WRITE: bw=77.6MiB/s (81.3MB/s), 77.6MiB/s-77.6MiB/s (81.3MB/s-81.3MB/s), io=9316MiB (9769MB), run=120105-120105msec

Disk stats (read/write):

sda: ios=148443/148718, merge=139/248, ticks=13259629/17094904, in_queue=29760664, util=100.00%

Результат для блока 128k:

Run status group 0 (all jobs):

READ: bw=222MiB/s (233MB/s), 222MiB/s-222MiB/s (233MB/s-233MB/s), io=26.0GiB (27.9GB), run=120033-120033msec

WRITE: bw=222MiB/s (233MB/s), 222MiB/s-222MiB/s (233MB/s-233MB/s), io=26.0GiB (27.9GB), run=120033-120033msec

Disk stats (read/write):

sda: ios=425074/425388, merge=572/637, ticks=13323836/17087667, in_queue=28751116, util=100.00%

w

только у блока на 128к есть нюанс

данные при этом больше места занимают на диске

данные при этом больше места занимают на диске

AA

Это hdd? У меня в raidz1 (то что аналог raid5) из 4х micron 5300 4Gb чтение было выше 1гб/сек и запись больше 600мб/сек, но до ограничения памяти на хосте с 512гб оперативы, потом ограничил в 16гиг и смысла уже мерить не было- уже машины жили там.

SM

Да, RAIDZ2 из 8 HDD

SM

в итоге отказался от RAIDZ2 в пользу RAID10, там на 128k блоке результат такой:

Run status group 0 (all jobs):

READ: bw=426MiB/s (447MB/s), 426MiB/s-426MiB/s (447MB/s-447MB/s), io=50.2GiB (53.0GB), run=120666-120666msec

WRITE: bw=427MiB/s (448MB/s), 427MiB/s-427MiB/s (448MB/s-448MB/s), io=50.3GiB (54.1GB), run=120666-120666msec

Disk stats (read/write):

sda: ios=822188/823798, merge=1064/1153, ticks=13432815/17038857, in_queue=27214948, util=99.99%

Run status group 0 (all jobs):

READ: bw=426MiB/s (447MB/s), 426MiB/s-426MiB/s (447MB/s-447MB/s), io=50.2GiB (53.0GB), run=120666-120666msec

WRITE: bw=427MiB/s (448MB/s), 427MiB/s-427MiB/s (448MB/s-448MB/s), io=50.3GiB (54.1GB), run=120666-120666msec

Disk stats (read/write):

sda: ios=822188/823798, merge=1064/1153, ticks=13432815/17038857, in_queue=27214948, util=99.99%