DN

Size: a a a

2019 September 21

Лвм говно посоны

i

Лвм говно посоны

С ним онлайн-ресайз работает, что удобно

i

Как на увеличение, так и на сокращение

I

Лвм говно посоны

сломался то не лвм, а фс внутри него

i

сломался то не лвм, а фс внутри него

Пропустил немного, суперблоки живые?

i

Я бы через Sleuth Kit прогнал фс, если просто dd блочного устройства не помогает. Был ещё дистрибутив CAINE, но с ним сложнее

VM

Всем добрый. Есть вопрос по lvm. Кто-нибудь делал так:

# for n in {b,c,d,e}; do sgdisk -N 1 /dev/sd$n; done

# pvcreate /dev/sd{b1,c1,d1,e1}

# vgcreate r10 /dev/sd{b1,c1,d1,e1}

# lvcreate --type raid10 --mirrors 1 --stripes 2 -l 70%FREE --name r10_thinpool r10 /dev/sd{b1,c1,d1,e1}

# lvcreate --type raid10 --mirrors 1 --stripes 2 -l 50%FREE --name r10_thinmeta r10 /dev/sd{b1,c1,d1,e1}

# lvconvert --thinpool r10/r10_thinpool --poolmetadata r10/r10_thinmeta

В итоге получаем raid 10 тонкий том, где сам рейд собирает lvm обращаясь к md прослойке без mdadm.

# for n in {b,c,d,e}; do sgdisk -N 1 /dev/sd$n; done

# pvcreate /dev/sd{b1,c1,d1,e1}

# vgcreate r10 /dev/sd{b1,c1,d1,e1}

# lvcreate --type raid10 --mirrors 1 --stripes 2 -l 70%FREE --name r10_thinpool r10 /dev/sd{b1,c1,d1,e1}

# lvcreate --type raid10 --mirrors 1 --stripes 2 -l 50%FREE --name r10_thinmeta r10 /dev/sd{b1,c1,d1,e1}

# lvconvert --thinpool r10/r10_thinpool --poolmetadata r10/r10_thinmeta

В итоге получаем raid 10 тонкий том, где сам рейд собирает lvm обращаясь к md прослойке без mdadm.

VM

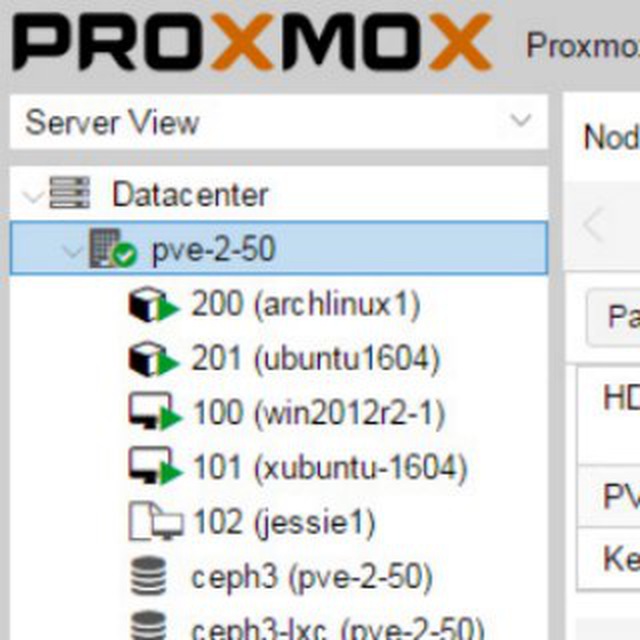

Хочу такую штуку использовать для проксмокс кластера, в связке с DRBD9

VM

Технически я оттестил это решение, все работает норм, но вот я никак не могу решить проблему с восстановлением thin lvm массива типа raid 10, по каким только инструкциям не делал - ничего не получается.

VM

Если вынуть из массива диск, а вставить новый, то никак без потери массива или данных он не собирается.

VM

скурил man thinlvm за ним man lvmraid, а затем еще и gentoo wiki + rhel lvm guide и не пойму, вот собрав по командам выше массив, вынув из него диск, как подключить новый и на горячую ребилднуть массив?

VM

На вопрос зачем - вводная, 3 сервера по 2 зеона(8 ядер 16 потоков), 12 дисков по 8ТБ, 4 ссд по 800ГБ, и 64ГБ памяти. Исходя из условий ceph, а за ним zfs+что-то(glusterfs/drbd9 ...) отпадают из-за конских требований по памяти для обслуживания такого RAW пространства. Остается thinlvm+drbd9, как drbd9 по памяти я не знаю, подозреваю лучше чем zfs или ceph, а вот то что thinlvm по скорости одно из самых быстрых решений, а по памяти можно вообще не заморачиваться, это да.

2019 September 22

TF

TL\DR

если ваш друг никогда не работал с Linux и ему досталось что-то подобное в наследство, то лучше сразу под угрозой паяльника предложите ему переехать на что-то привычное ему

если ваш друг никогда не работал с Linux и ему досталось что-то подобное в наследство, то лучше сразу под угрозой паяльника предложите ему переехать на что-то привычное ему

потому, стоит кому-то переехать из proxmox, я верно понял намек?

G

Vladimir Manko

На вопрос зачем - вводная, 3 сервера по 2 зеона(8 ядер 16 потоков), 12 дисков по 8ТБ, 4 ссд по 800ГБ, и 64ГБ памяти. Исходя из условий ceph, а за ним zfs+что-то(glusterfs/drbd9 ...) отпадают из-за конских требований по памяти для обслуживания такого RAW пространства. Остается thinlvm+drbd9, как drbd9 по памяти я не знаю, подозреваю лучше чем zfs или ceph, а вот то что thinlvm по скорости одно из самых быстрых решений, а по памяти можно вообще не заморачиваться, это да.

Zfs'у сколько памяти дадите - столько и заюзает под кеш, смотрите https://github.com/zfsonlinux/zfs/wiki/ZFS-on-Linux-Module-Parameters#zfs_arc_max

NS

Vladimir Manko

На вопрос зачем - вводная, 3 сервера по 2 зеона(8 ядер 16 потоков), 12 дисков по 8ТБ, 4 ссд по 800ГБ, и 64ГБ памяти. Исходя из условий ceph, а за ним zfs+что-то(glusterfs/drbd9 ...) отпадают из-за конских требований по памяти для обслуживания такого RAW пространства. Остается thinlvm+drbd9, как drbd9 по памяти я не знаю, подозреваю лучше чем zfs или ceph, а вот то что thinlvm по скорости одно из самых быстрых решений, а по памяти можно вообще не заморачиваться, это да.

1. Чем вам не угодил mdraid, что решили от него прям отказаться? На lvm много ругани было помню и много функций связанных с восстановлением отсутствовало.

2. Выбор тонких томов обусловлен чем? Если будете много клонировать/снапшотить - тогда понятно, если не будете то зачем? оно тормознее чем raw.

3. Когда я выбирал cow под определенные задачи, то у нас на всех тестах лучше всего себя показал mdraid + vdo (правда на ssd-дисках), память тоже жрет, но тонко настраивается в одном конфиге, чем больше памяти - тем лучше работает.

2. Выбор тонких томов обусловлен чем? Если будете много клонировать/снапшотить - тогда понятно, если не будете то зачем? оно тормознее чем raw.

3. Когда я выбирал cow под определенные задачи, то у нас на всех тестах лучше всего себя показал mdraid + vdo (правда на ssd-дисках), память тоже жрет, но тонко настраивается в одном конфиге, чем больше памяти - тем лучше работает.

VM

Zfs'у сколько памяти дадите - столько и заюзает под кеш, смотрите https://github.com/zfsonlinux/zfs/wiki/ZFS-on-Linux-Module-Parameters#zfs_arc_max

Это я знаю, но остается вопрос производительности, ну урежу я его гиг до 64. А везде требуют 1 гиг памяти на 1ТБ чистого дискового пространства. Каковы потери производительности zfs в таком режиме. Ну и придется 2 ссд отдать под zil, а не хотелось бы.

VM

1. Чем вам не угодил mdraid, что решили от него прям отказаться? На lvm много ругани было помню и много функций связанных с восстановлением отсутствовало.

2. Выбор тонких томов обусловлен чем? Если будете много клонировать/снапшотить - тогда понятно, если не будете то зачем? оно тормознее чем raw.

3. Когда я выбирал cow под определенные задачи, то у нас на всех тестах лучше всего себя показал mdraid + vdo (правда на ssd-дисках), память тоже жрет, но тонко настраивается в одном конфиге, чем больше памяти - тем лучше работает.

2. Выбор тонких томов обусловлен чем? Если будете много клонировать/снапшотить - тогда понятно, если не будете то зачем? оно тормознее чем raw.

3. Когда я выбирал cow под определенные задачи, то у нас на всех тестах лучше всего себя показал mdraid + vdo (правда на ssd-дисках), память тоже жрет, но тонко настраивается в одном конфиге, чем больше памяти - тем лучше работает.

Зачем лишняя прослойка, ну и рпзрабы рекоммендуют не делать mdadm а сразу юзать lvmraid. Да планируются снапшоты. Выбор обусловлен минимальными затратами на память и по тестам фактически самой высокой производительностью, быстрее только lvm чистый.

G

Vladimir Manko

Это я знаю, но остается вопрос производительности, ну урежу я его гиг до 64. А везде требуют 1 гиг памяти на 1ТБ чистого дискового пространства. Каковы потери производительности zfs в таком режиме. Ну и придется 2 ссд отдать под zil, а не хотелось бы.

Кто где требует гиг на тб?) миф, как и на любой другой фс - сколько отдадите под кеш - на столько хорошо и будет. Если что в этот гиг не поместилось - значит это менее актуально было. Главное дедуп не включайте - там да, т.к. дедупликация онлайн, сейчас нужно около 320байт озу на каждый recordsize блок, не поместится в озу вся ddt - привет дикая просадка.

G

но стоит всё тестить, да, zfs не панацея

s

mdraid и zfs хоть работает, а lvmthin у меня развалился 1раз, когда данных стало больше чем места. причем как я понял прокс не контроллит этот момент