i

Size: a a a

2019 April 30

Причём паттерн повторяется и на ESXi, и под KVM

NS

SSD мы как раз используем в штатной корзине, конфигурация обычно RAID-6 + SSD-кэш. Только вот результаты взрывают мозг - уже 2-3 года стабильно работает кэш на дешмани вроде adata или smartbuy, а вот intel серии 545s гарантированно сдiхают уже через месяц-два-три. Причём никаких MLC/QLC, только TLC. Для меня это абсолютная загадка, как так проиходит. Нагрузка, конечно, приличная, но и те старые почему-то ещё живут. Просто мистика какая-то.

мож там записи мало на них? или нагрузка одинаковая?

i

мож там записи мало на них? или нагрузка одинаковая?

Один и тот же гипервизор, просто сначала "проапгрейдили", а потом аж охуели от такого апгрейда

i

Каюсь, не скажу модели предыдущих ссдшек, они уже давно уехали обратно в цод, но всё равно херня какая-то, так не должно быть

i

Нагрузка там на уровне ≤ 20 vm на ноду, но внутри СУБД различные. Не использовать SSD - не вариант.

NS

Нагрузка там на уровне ≤ 20 vm на ноду, но внутри СУБД различные. Не использовать SSD - не вариант.

хз, у нас микроны самые дешманские на 960 хорошо жили на кэш пару лет назад, ща проще двухтерабайтников по 500 баксов набрать, чем с кэшем воевать. Ну или вынести на чистый ссд базы хотя бы.

i

хз, у нас микроны самые дешманские на 960 хорошо жили на кэш пару лет назад, ща проще двухтерабайтников по 500 баксов набрать, чем с кэшем воевать. Ну или вынести на чистый ссд базы хотя бы.

Пожалуй, закину в список закупок.

h

купили по 2 960 на ноду и врубили бикеш, стало раком через 20 минут

h

на ссд кончился slc-кеш и всё уперлось в медленный tlc

i

Пробовали комбинацию 4xNVME на PCI-E x16 плате, Gen8 видит в лучшем случае 2. И вот тоже хуй пойми, это NVMe битые (1 dead on arrival точно была), плата дефектная, райзер на серваке разводит x8 в x16 слоте, или комбинация этих факапов.

NS

Пробовали комбинацию 4xNVME на PCI-E x16 плате, Gen8 видит в лучшем случае 2. И вот тоже хуй пойми, это NVMe битые (1 dead on arrival точно была), плата дефектная, райзер на серваке разводит x8 в x16 слоте, или комбинация этих факапов.

Не, для nvme надо брать ваще новье, проверено, или пихать по 1 диску в сервер - не более. Забивать все слоты nvme можно только на голдах вроде, и то там свои ограничения.

NS

Во всяком случае нас так поставщики уверяли.

NS

На ща оно все дешевеет, можно хоть 4 тб nvme взять один в сервер и не париться(пока не сдохнет канешн.)

i

Странно, в консьюмерских компах работает (по словам производителя). Сама карта тут описана.

i

Ой бля, какая огромная превьюшка, простите

NS

Странно, в консьюмерских компах работает (по словам производителя). Сама карта тут описана.

А прокачает ли оно 4х3.2Гб в сек.? Сомневаюсь...

i

Ещё бы найти подопытного, который бы все 4 nvme увидел, уже было бы неплохо

i

А на один ssd вроде и так 4 линии максимум по стандарту, так что в теории должно прокачивать.

IH

Нет, далеко до ceph, более того, где можно обойтись без ceph - лучше туда не лезть. Это отдельная песня, куда более "тонкая" и чувствительная ко всякому, чем zfs даже :)

Кроме того, ceph условно начинается с 3 узлов хранилища и то в варианте для тестов погонять, в продакшн нужно минимум 5 ставить... и это для скромного ceph хранилища. Вопрос, с какого размера кластера рабочих нод можно начинать разговор про выделенные 5 нод по ceph?

Я уже не говорю про требования к сети, к железу (процам), и при всем этом latency всегда будет больше чем через 1гбит сеть на iscsi :)

P. S. Если у вас есть ceph как система хранения, созданная под те задачи где она нужна, и вы сбоку хотите крутить насколько десятков виртуалок не особо требовательных к lat и операциями записи в один поток, то в принципе можно. Делать отдельный ceph кластер как хранилище образов виртуалок под систему виртуализации -- это ещё нужно доказать, что оно вам хоть как-то оправдано (95% нет), по сравнению с другими более простыми решениями (в первую очередь iscsi или fc хранилками). Я тут даже не начинаю обсуждать нюансы.

Кроме того, ceph условно начинается с 3 узлов хранилища и то в варианте для тестов погонять, в продакшн нужно минимум 5 ставить... и это для скромного ceph хранилища. Вопрос, с какого размера кластера рабочих нод можно начинать разговор про выделенные 5 нод по ceph?

Я уже не говорю про требования к сети, к железу (процам), и при всем этом latency всегда будет больше чем через 1гбит сеть на iscsi :)

P. S. Если у вас есть ceph как система хранения, созданная под те задачи где она нужна, и вы сбоку хотите крутить насколько десятков виртуалок не особо требовательных к lat и операциями записи в один поток, то в принципе можно. Делать отдельный ceph кластер как хранилище образов виртуалок под систему виртуализации -- это ещё нужно доказать, что оно вам хоть как-то оправдано (95% нет), по сравнению с другими более простыми решениями (в первую очередь iscsi или fc хранилками). Я тут даже не начинаю обсуждать нюансы.

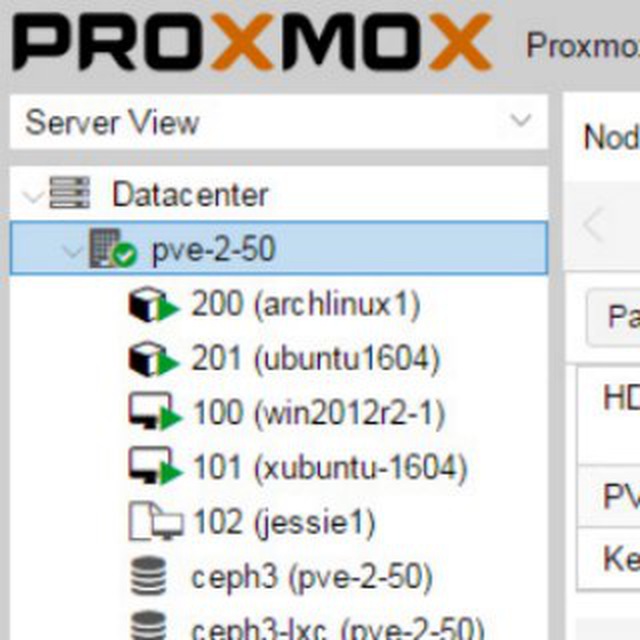

Вот что можно сделать, допустим с 3-х нод у которых один интерфейс 1Гбит, 2x1ТБ NVME SSD