i

я у одних товарищей использую 2 ноды FreeNAS - мастер и слэйв и с них раздаю сторэйджи по ISCSI на 4 ноды ESXi. Итого: 6 серверов.

На FreeNAS - ZFS со снимками средствами ZFS, как таковых бэкапов нет, т.к. ZFS зеркалирована между нодами FreeNAS.

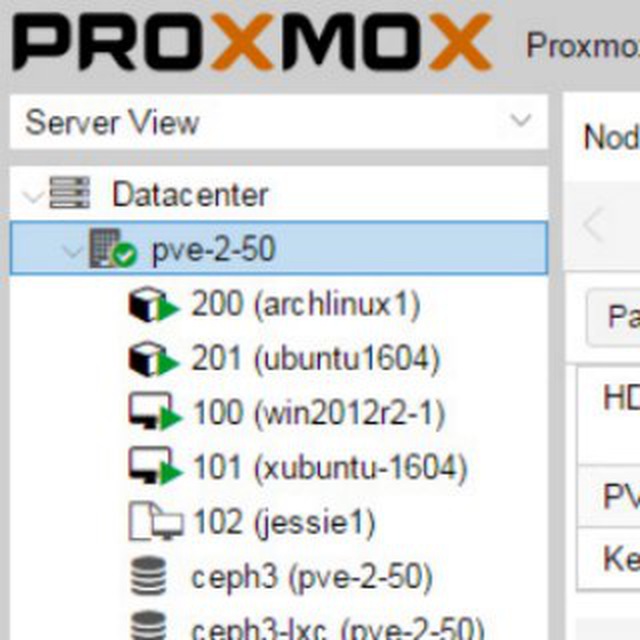

Думаю переезд на Proxmox и из 6 имеющихся железок поднять кластер и так же использовать снэпшоты ZFS для нужд отката нежелательных изменений и т.п.

Хотелось бы услышать мнение сообщества.