TM

Size: a a a

2020 November 19

KL

Друзья, всем привет.

Есть кто-то, кто съел собаку на эластике? Пара вопросов.

1. Использовали ли эмбеддинги (USE) ? Есть какие-то подводные камни? Интересно, какие токены там векторизуются для поиска по телу документа. Или это только для поиска заголовков...

2. Удалось ли вам использовать какую-то хитрость для поиска неявного, но смыслового совпадения запроса и тела документа. Расскажите

Есть кто-то, кто съел собаку на эластике? Пара вопросов.

1. Использовали ли эмбеддинги (USE) ? Есть какие-то подводные камни? Интересно, какие токены там векторизуются для поиска по телу документа. Или это только для поиска заголовков...

2. Удалось ли вам использовать какую-то хитрость для поиска неявного, но смыслового совпадения запроса и тела документа. Расскажите

SP

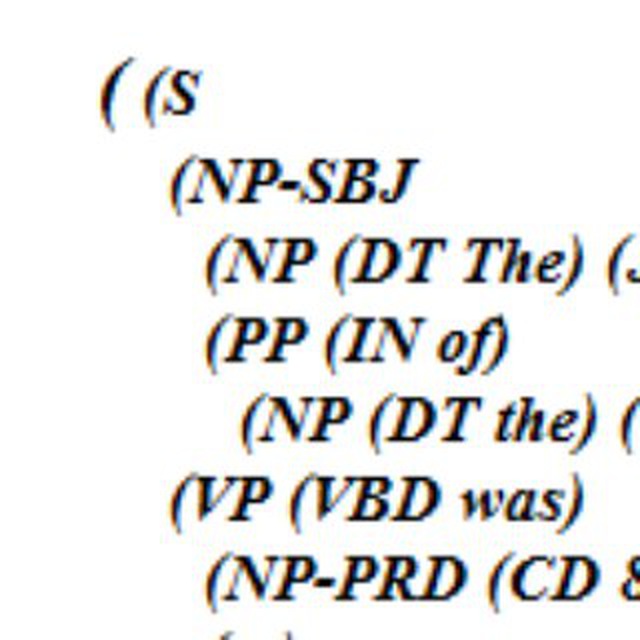

import spacyМиру 7 11 PER

sample_sentences = "Привет Миру! Как твои дела? 14 октября. 12 рублей. Лондон. Понедельник. Сегодня неплохая погода."

if __name__ == '__main__':

nlp = spacy.load('/content/ru2_nerus_800ks_96')

doc = nlp(sample_sentences)

for ent in doc.ents:

print(ent.text, ent.start_char, ent.end_char, ent.label_)

Лондон 51 57 LOC

код из прямо из туториала 10 секунд

SP

Друзья, всем привет.

Есть кто-то, кто съел собаку на эластике? Пара вопросов.

1. Использовали ли эмбеддинги (USE) ? Есть какие-то подводные камни? Интересно, какие токены там векторизуются для поиска по телу документа. Или это только для поиска заголовков...

2. Удалось ли вам использовать какую-то хитрость для поиска неявного, но смыслового совпадения запроса и тела документа. Расскажите

Есть кто-то, кто съел собаку на эластике? Пара вопросов.

1. Использовали ли эмбеддинги (USE) ? Есть какие-то подводные камни? Интересно, какие токены там векторизуются для поиска по телу документа. Или это только для поиска заголовков...

2. Удалось ли вам использовать какую-то хитрость для поиска неявного, но смыслового совпадения запроса и тела документа. Расскажите

Использовали, как следует из названия он для предложений предназначен, что MUSE, что LASER - оба хороши.

KL

Использовали, как следует из названия он для предложений предназначен, что MUSE, что LASER - оба хороши.

И что же там, эластик векторизует все предложения тела документа? Это же жесть сколько векторов получается, не совсем понятен этот момент

KL

Сам USE понятен как явление, не понятно, как его использует эластиг

YB

там выложено 4 модели, и в двух из них нет NER, а в двух есть.

НК

Семантический поиск в эластике готовил кто-нибудь? Толк есть?

TM

там выложено 4 модели, и в двух из них нет NER, а в двух есть.

спасибо, разобрался

2020 November 20

AK

Библиотеки из проекта Natasha скачивают примерно 3700 раз в месяц (1500 natasha, 1000(!) yargy, 1000 razdel). Это не очень много, но и не мало. Для сравнения DeepPavlov скачивают ~4000 раз. Мне стало интересно, кто все эти люди, особенно, герои кто осилил Yargy. Пройдите, пожалуйста, опросик, может быть, я вам напишу, поспрашиваю. #natasha

AK

Natasha и я

Анонимный опрос

Проголосовало: 198k

Библиотеки из проекта Natasha скачивают примерно 3700 раз в месяц (1500 natasha, 1000(!) yargy, 1000 razdel). Это не очень много, но и не мало. Для сравнения DeepPavlov скачивают ~4000 раз. Мне стало интересно, кто все эти люди, особенно, герои кто осилил Yargy. Пройдите, пожалуйста, опросик, может быть, я вам напишу, поспрашиваю. #natasha

Но ведь не все кто есть в этом чате используют Natasha, и не все кто использует Natasha, есть в этом чате.

AK

Но ведь не все кто есть в этом чате используют Natasha, и не все кто использует Natasha, есть в этом чате.

Все и нужны, достаточно выборки

AS

Подскажите пожалуйста,как можно сделать токенизацию, но так чтобы whitespace тоже остались на своих местах?

НК

Все и нужны, достаточно выборки

хотелось бы razdel в качестве сервера с api, вы можете помочь написать? лучше в докер сразу

AK

хотелось бы razdel в качестве сервера с api, вы можете помочь написать? лучше в докер сразу

Причина в том что у вас язык программирования не Питон? Просто razdel легкая библиотека, обычно удобно использлвать ее не как сервис. Вы можете взять https://github.com/natasha/natasha-demo, убрать часть кода, будет то что надо

НК

Да, часто проект вне питона, плюс надо на микросервисы масштабировать нагрузку. Спасибо, гляну Natasha.

НК

А есть ли возможность через elmo написать алгоритм, который определяет, что у слова или фразы есть множество значений в зависимости от контекста?

MF

А есть ли возможность через elmo написать алгоритм, который определяет, что у слова или фразы есть множество значений в зависимости от контекста?

в контекстах с разными значениями вектора для одного слова по косинусу (или другой метрике) дальше будут. Подойдёт ли именно под вашу задачу - только пробовать

НК

Есть ли смысл сделать свою elmo модель из текста 300-500гб?