EU

Size: a a a

2020 June 30

Или я неверно задачу грамматики понимаю? Кажется, что это эквивалент регулярки. Только грамматики более читаемые.

AK

Я с регулярками не очень дружу. А с yargy раньше работал и он мне понравился. Кроме того, yargy проще читать и потом изменять, если потребуется. Я не уверен, что регуляркой я напишу также эффективно

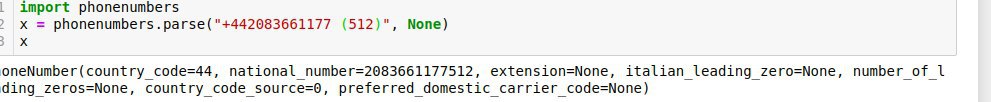

Для извлечения телефон лучше использовать библиотеку https://github.com/daviddrysdale/python-phonenumbers

AK

Мне нужно извлекать телефоны. natasha этого делать не умеет. Я написал грамматики на yargy, которые уже неплохо работают. С вопросом выше разобрался.

Верно ли я понимаю, что наташа — это заготовленные грамматики и, в принципе, всё. Их там то ли 3, то ли 4 штуки (я имею ввиду 3 или 4 кейса: адреса, имена...)?

Верно ли я понимаю, что наташа — это заготовленные грамматики и, в принципе, всё. Их там то ли 3, то ли 4 штуки (я имею ввиду 3 или 4 кейса: адреса, имена...)?

> Верно ли я понимаю, что наташа — это заготовленные грамматики и, в принципе, всё.

Это устаревшая информация ) см https://t.me/natural_language_processing/16962

Это устаревшая информация ) см https://t.me/natural_language_processing/16962

EU

> Верно ли я понимаю, что наташа — это заготовленные грамматики и, в принципе, всё.

Это устаревшая информация ) см https://t.me/natural_language_processing/16962

Это устаревшая информация ) см https://t.me/natural_language_processing/16962

https://github.com/natasha/natasha

Я говорил про вот эту репу, которая находится в проекте наташа. Вижу, она интегрирует в себе несколько технологий. Я на это внимания до этого не обратил и плохо прочитал то, что вы написали. Окей, спасибо

Я говорил про вот эту репу, которая находится в проекте наташа. Вижу, она интегрирует в себе несколько технологий. Я на это внимания до этого не обратил и плохо прочитал то, что вы написали. Окей, спасибо

EU

EU

Его кастомизировать можно как-нибудь внутренними средствами?

EU

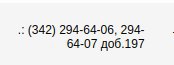

Вот такую штуку не взял

AK

Его кастомизировать можно как-нибудь внутренними средствами?

Кастомизировать нет. Там действитель две проблемы: доп. коды и телефоны с общим префиксом (+7 (123) 456-56-56, 123-12-12). Можно накручивать логику сбоку от phonenumbers

EU

Понял, буду yargy допиливать

EU

Там я общий случай разберу. А здесь костыли будут

SS

Вопрос поиска похожих эмбедингов. Чтобы не поднимать фаис или любую другую ann, есть желание писать вектора в бд, а поиск стоить через Эластик, никто не сталкивался, как это настроить и как быстро это работает? Просто индекс выходит очень большой, в память грузить не хочется, а понижение размерности в моей задаче снижает сильно качество выдачи.

VB

Вопрос поиска похожих эмбедингов. Чтобы не поднимать фаис или любую другую ann, есть желание писать вектора в бд, а поиск стоить через Эластик, никто не сталкивался, как это настроить и как быстро это работает? Просто индекс выходит очень большой, в память грузить не хочется, а понижение размерности в моей задаче снижает сильно качество выдачи.

РН

Вопрос поиска похожих эмбедингов. Чтобы не поднимать фаис или любую другую ann, есть желание писать вектора в бд, а поиск стоить через Эластик, никто не сталкивался, как это настроить и как быстро это работает? Просто индекс выходит очень большой, в память грузить не хочется, а понижение размерности в моей задаче снижает сильно качество выдачи.

Зачем вектора в БД? Есть же удобная вещь для индексирования векторов https://github.com/spotify/annoy

VB

Вопрос поиска похожих эмбедингов. Чтобы не поднимать фаис или любую другую ann, есть желание писать вектора в бд, а поиск стоить через Эластик, никто не сталкивался, как это настроить и как быстро это работает? Просто индекс выходит очень большой, в память грузить не хочется, а понижение размерности в моей задаче снижает сильно качество выдачи.

Вопрос в том сколько у вас документов и какая размерность векторов

EU

Лучше hnsw

EU

Вот бенчи

DK

hnsw не поддерживается больше

EU

Ого. Чего это так. Хороший инструмент.

SS

Зачем вектора в БД? Есть же удобная вещь для индексирования векторов https://github.com/spotify/annoy

Он плохо апроксимирует