NT

Size: a a a

2017 February 03

не хотелось бы*

DV

кстати, если хочется ускорить всё это - можешь попробовать pypy, оно раз в 5-10 быстрее работает)

DV

например, у меня на этих данных (https://github.com/bureaucratic-labs/natasha/issues/9#issuecomment-276799414) с полным набором грамматик скорость около 900 КБ/м

DV

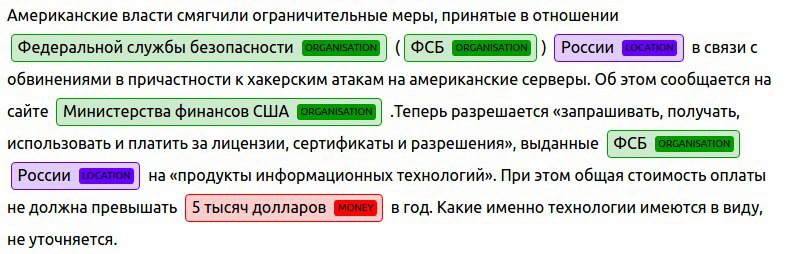

обновил онлайн демку (если кто-то вообще ею пользуется :), теперь это выглядит так

2017 February 04

AK

А 900 КБ/м — это много или мало? Не известно как это соотносится с участниками factRuEval и Томитой?

DV

В статьях про томиту говорят про 80 МБ/час (например, https://habrahabr.ru/company/yandex/blog/219311/#comment_7496031), комментарием ниже скорость примерно 22 МБ/м

DV

Про других участников не знаю.

DV

Вообще, всё это дело параллелится же на раз-два, т.ч. это не самая большая проблема (как мне кажется)

DV

Я как-то считал: можно распарсить условный дамп википедии (100 GB) параллельно, используя API на AWS Lambda, с ограничением в 1 MB загружаемого текста (чтобы уложится в 128 МБ оперативки) и всё это обойдется примерно в $2.

DV

(распарсить полным набором грамматик наташи)

AK

Кстати, кому-то может быть удобно использовать Наташу через HTTP, чтобы на бекэнде всё уже было распараллено и на pypy

DV

Ну да, когда-нибудь сделаю.

DV

Сейчас, если хочется попробовать, можно делать запросы к https://github.com/bureaucratic-labs/playground

2017 February 06

NT

Возвращаюсь сюда со строкой-киллером, как и обещал

NT

Код:

combinator = Combinator([Person, Organisation, Brand, Date, Location, Money])

matches = combinator.extract(text)

for grammar, match in combinator.resolve_matches(matches):

NT

и строка ‘1433 - 40817810505751201174’

NT

Ошибка: OverflowError: Python int too large to convert to C long