AK

Size: a a a

2017 February 17

а у нас других не бывает

KB

бывает, когда тут начинают что-то про машинное обучение разводить

KB

идите в специализированные чаты!

VM

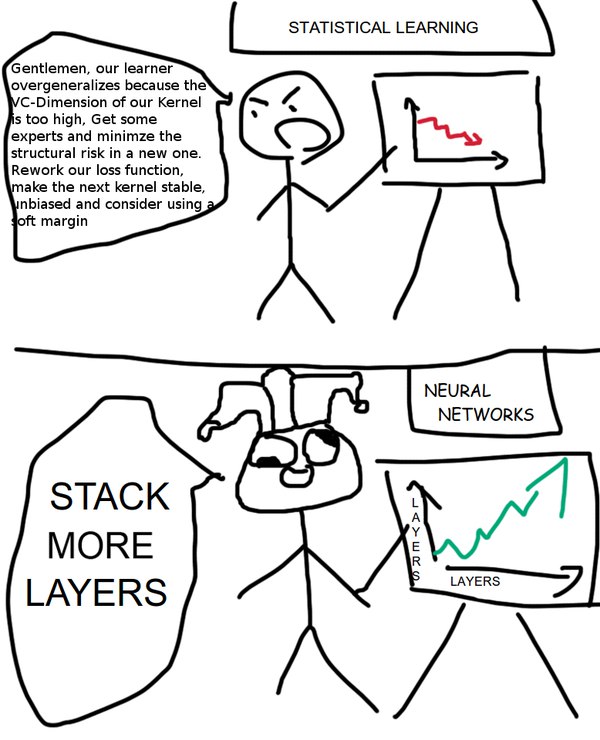

Моя любимая картинка

AA

KB

а за мою любимую картинку меня выгонят с позором :(

AK

Моя любимая картинка

т.е. ты шаришь. Что там с обучающими выборками?)

VM

Боюсь, что без контекста непонятно)

AA

Есть ощущение, что это такая изысканная подъёжка

AK

ну я просто совсем зеленый и пытаюсь понять как делают многослойные модели.

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

TG

ну я просто совсем зеленый и пытаюсь понять как делают многослойные модели.

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

надеюсь, не для этой задачи?

AK

ну если повезет то я попробовал бы, чем бог не шутит. Но я пару недель назад только в руки взял scikit

VM

ну я просто совсем зеленый и пытаюсь понять как делают многослойные модели.

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

т.е. у нас изначально есть X u y и мы получается первый слой обучаем используя только половину этих данных.

Потом вторую половину Х скармливаем первому слоую для предсказания и на этих значениях обучаем второй слой?

если я правильно тебя понял, то ты говоришь про иное, нежели ситуация как на картинке

AK

почему же?

VM

на картинке более хитрые stacked models, которые могут быть какими угодно

VM

многослойные же модели работают примерно так:

слой 1 -> слой 2 -> слой 3 -> ...

где на каждом слою каким-то образом данные обрабатываются и передаются дальше

слой 1 -> слой 2 -> слой 3 -> ...

где на каждом слою каким-то образом данные обрабатываются и передаются дальше

VM

многослойные нейронные сети*

AK

не, я про ансамбли, скорее

AK

не совсем может верно выражаюсь и правильно использую терминологию