SS

Size: a a a

2020 April 04

Alex Grishkevich

главная рекомендация по рекурсии - не использовать рекурсию. в ВК группа есть. там, обычно, помогают

Ну всё же бывают ситуации, когда это лучшее решение, не?

DE

Ну всё же бывают ситуации, когда это лучшее решение, не?

Для обхода деревьев, когда нет альтернатив.

PL

рекурсия в миллионе алгоритмов есть

DE

рекурсия в миллионе алгоритмов есть

Но не во всех она к месту. И не во всех языках программирования она оптимально работает.

PL

явно не только в деревьях. Да она повсюду, в тех же regex например

A

Разобрался, конечно, на первый взгляд это логично, но при отправке методом POST $request->post('param') пустой. А $request->input('param') норм отрабатывает.

Можно просто $request->param inputпросто даёт возможность проставить дефолтное значение

ED

У меня всегда был вопрос, а нет вот какой то штуки для тестов, как tinker например, например я как в контроллер написал код, он исполнился и дал мне результат, чтобы не создавать тестовой контроллер, суть вопроса : есть ли может какой нибудь «правильный» способ эксперементировать с данными, дампить их, только делая как задумано?

xdebug

К

Приветствую. Лар 6. Наследую родительский контроллер, далее в родительском вызываю вид. Но возвращает пустой DOM. Если вызвать вид в дочернем - то все норм . Что может быть? В 6 версии какие-то нововведения ?

Д

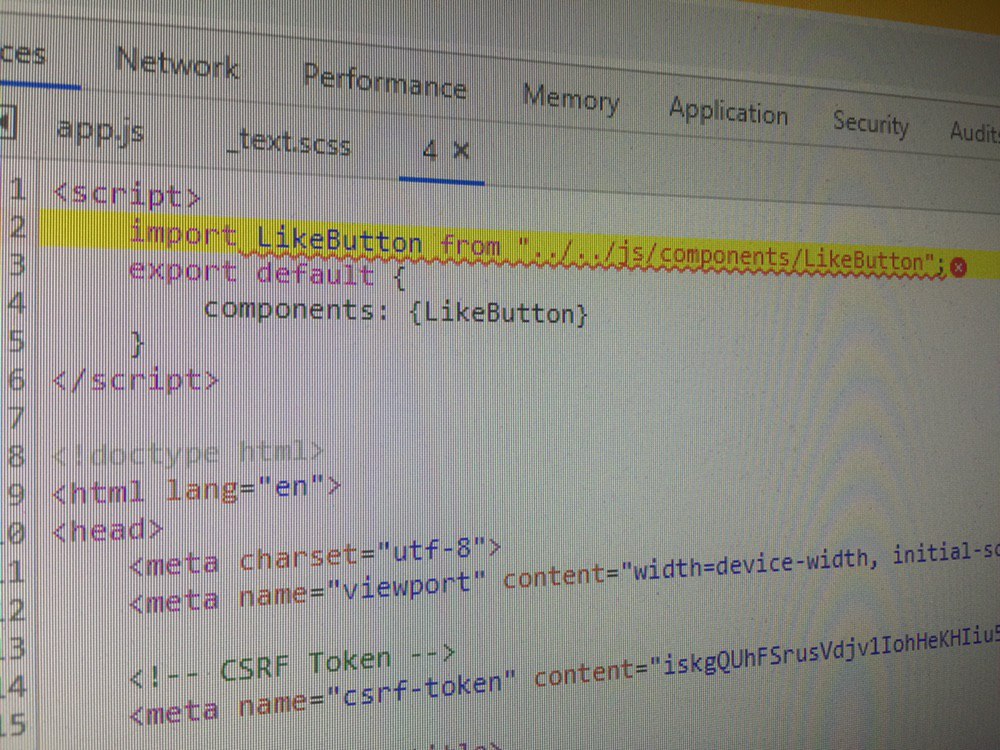

Всем привет. Сразу хочу извиниться за такой "скрин". В чем проблема может быть ? Создать компонент, подключил его в app.js

Д

К

Всем привет. Сразу хочу извиниться за такой "скрин". В чем проблема может быть ? Создать компонент, подключил его в app.js

Путь проверь

К

И почему у тебя в верху DOM код . До vue

Д

И почему у тебя в верху DOM код . До vue

Это видимо он сам как-то вставляется, его нет в коде

2020 April 05

Д

Все нормально. Я просто идиот. Всем спасибо

СЕ

Но не во всех она к месту. И не во всех языках программирования она оптимально работает.

В Laravel например рукурсивно ищутся алиасы, контейнером рекурсивно создаются обьекты.

DE

Сергей Енотов

В Laravel например рукурсивно ищутся алиасы, контейнером рекурсивно создаются обьекты.

Да, рекурсивно обходятся дерево маршрутов и дерево зависимостей.

J

Всем привет. Вопрос по архитектуре.

У меня поступает запрос от браузера пользователя в Laravel-приложение. По этому запросу нужно загрузить из другого источника данные и отдать пользователю.

Запрос поступает скажем в метод AnyController::loadData()

Раньше источник данных был один.

В этом случае я прямо в коде AnyController::loadData() я делал запрос через PHP библиотеку Guzzle к стороннему api, обрабатывал запрос, ошибки и возвращал назад пользователю.

Сейчас источников данных три. Они отвечают с разной скоростью и разной полнотой ответа. При этом есть задача максимально быстро показать пользователю результат, а потом уже догружать данные.

Есть три варианта, но все они работают по одному принципу:

В AnyController::loadData() я создаю идентификатор ответа IDRESPONCE и сразу его возвращаю пользователю в браузер. И тут же параллельно запускаются три задачи на дозагрузку данных. Каждая из этих задач кладет ответ в БД и указывает IDRESPONCE.

А в браузере я поллингом ломлюсь каждую секунду к другому методу AnyController::getNewData(передаю ему IDRESPONCE) и жду появления записей.

Вопрос: как организовать параллельную загрузку данных?

1. PHP PThreads. в методе AnyController::loadData() стартануть три потока и они пусть молотят данные дальше. Но множить потоки на каждый запрос, это стрёмно, откровенно.

2. Queue. в методе AnyController::loadData() кладу в очередь три задачи на загрузку, а дальше их воркеры берут из очереди и обрабатывают. Тут всё отлично, кроме того, что нужна работоспособная очередь и я не знаю насколько это будет быстро.

3. Node.js Реализовать метод AnyController::loadData() не на Laravel а в Node.js. Но тут проблема с CSRF-токеном, не хотелось бы терять его, а в ноду его не прокинешь.

У меня поступает запрос от браузера пользователя в Laravel-приложение. По этому запросу нужно загрузить из другого источника данные и отдать пользователю.

Запрос поступает скажем в метод AnyController::loadData()

Раньше источник данных был один.

В этом случае я прямо в коде AnyController::loadData() я делал запрос через PHP библиотеку Guzzle к стороннему api, обрабатывал запрос, ошибки и возвращал назад пользователю.

Сейчас источников данных три. Они отвечают с разной скоростью и разной полнотой ответа. При этом есть задача максимально быстро показать пользователю результат, а потом уже догружать данные.

Есть три варианта, но все они работают по одному принципу:

В AnyController::loadData() я создаю идентификатор ответа IDRESPONCE и сразу его возвращаю пользователю в браузер. И тут же параллельно запускаются три задачи на дозагрузку данных. Каждая из этих задач кладет ответ в БД и указывает IDRESPONCE.

А в браузере я поллингом ломлюсь каждую секунду к другому методу AnyController::getNewData(передаю ему IDRESPONCE) и жду появления записей.

Вопрос: как организовать параллельную загрузку данных?

1. PHP PThreads. в методе AnyController::loadData() стартануть три потока и они пусть молотят данные дальше. Но множить потоки на каждый запрос, это стрёмно, откровенно.

2. Queue. в методе AnyController::loadData() кладу в очередь три задачи на загрузку, а дальше их воркеры берут из очереди и обрабатывают. Тут всё отлично, кроме того, что нужна работоспособная очередь и я не знаю насколько это будет быстро.

3. Node.js Реализовать метод AnyController::loadData() не на Laravel а в Node.js. Но тут проблема с CSRF-токеном, не хотелось бы терять его, а в ноду его не прокинешь.

Mb

Google yandex mozzila, работают без перебоя, edge выдаёт Page expired, {{csrf}} стоит и на страницу в форму token попадает.

Mb

Кто сталкивался, подскажите как лечили.

s

Всем привет. Вопрос по архитектуре.

У меня поступает запрос от браузера пользователя в Laravel-приложение. По этому запросу нужно загрузить из другого источника данные и отдать пользователю.

Запрос поступает скажем в метод AnyController::loadData()

Раньше источник данных был один.

В этом случае я прямо в коде AnyController::loadData() я делал запрос через PHP библиотеку Guzzle к стороннему api, обрабатывал запрос, ошибки и возвращал назад пользователю.

Сейчас источников данных три. Они отвечают с разной скоростью и разной полнотой ответа. При этом есть задача максимально быстро показать пользователю результат, а потом уже догружать данные.

Есть три варианта, но все они работают по одному принципу:

В AnyController::loadData() я создаю идентификатор ответа IDRESPONCE и сразу его возвращаю пользователю в браузер. И тут же параллельно запускаются три задачи на дозагрузку данных. Каждая из этих задач кладет ответ в БД и указывает IDRESPONCE.

А в браузере я поллингом ломлюсь каждую секунду к другому методу AnyController::getNewData(передаю ему IDRESPONCE) и жду появления записей.

Вопрос: как организовать параллельную загрузку данных?

1. PHP PThreads. в методе AnyController::loadData() стартануть три потока и они пусть молотят данные дальше. Но множить потоки на каждый запрос, это стрёмно, откровенно.

2. Queue. в методе AnyController::loadData() кладу в очередь три задачи на загрузку, а дальше их воркеры берут из очереди и обрабатывают. Тут всё отлично, кроме того, что нужна работоспособная очередь и я не знаю насколько это будет быстро.

3. Node.js Реализовать метод AnyController::loadData() не на Laravel а в Node.js. Но тут проблема с CSRF-токеном, не хотелось бы терять его, а в ноду его не прокинешь.

У меня поступает запрос от браузера пользователя в Laravel-приложение. По этому запросу нужно загрузить из другого источника данные и отдать пользователю.

Запрос поступает скажем в метод AnyController::loadData()

Раньше источник данных был один.

В этом случае я прямо в коде AnyController::loadData() я делал запрос через PHP библиотеку Guzzle к стороннему api, обрабатывал запрос, ошибки и возвращал назад пользователю.

Сейчас источников данных три. Они отвечают с разной скоростью и разной полнотой ответа. При этом есть задача максимально быстро показать пользователю результат, а потом уже догружать данные.

Есть три варианта, но все они работают по одному принципу:

В AnyController::loadData() я создаю идентификатор ответа IDRESPONCE и сразу его возвращаю пользователю в браузер. И тут же параллельно запускаются три задачи на дозагрузку данных. Каждая из этих задач кладет ответ в БД и указывает IDRESPONCE.

А в браузере я поллингом ломлюсь каждую секунду к другому методу AnyController::getNewData(передаю ему IDRESPONCE) и жду появления записей.

Вопрос: как организовать параллельную загрузку данных?

1. PHP PThreads. в методе AnyController::loadData() стартануть три потока и они пусть молотят данные дальше. Но множить потоки на каждый запрос, это стрёмно, откровенно.

2. Queue. в методе AnyController::loadData() кладу в очередь три задачи на загрузку, а дальше их воркеры берут из очереди и обрабатывают. Тут всё отлично, кроме того, что нужна работоспособная очередь и я не знаю насколько это будет быстро.

3. Node.js Реализовать метод AnyController::loadData() не на Laravel а в Node.js. Но тут проблема с CSRF-токеном, не хотелось бы терять его, а в ноду его не прокинешь.

Почему в ноду не прокинешь?