ME

Вывод:

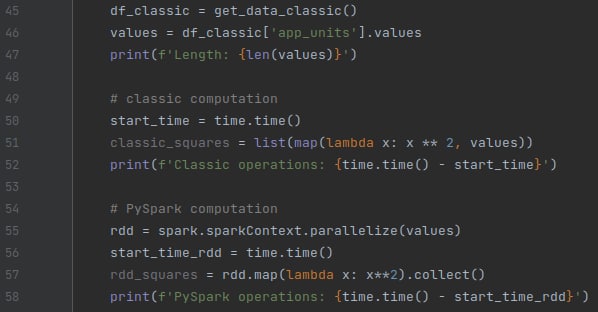

Length: 4160889

Classic operations: 1.4955859184265137

PySpark operations: 4.892405271530151Size: a a a

M

Length: 4160889

Classic operations: 1.4955859184265137

PySpark operations: 4.892405271530151PK

PK

M

AE

M

AE

AE

AE

M

T

AE

AE

AZ

SO

V

GP

V

V