AZ

Size: a a a

2021 March 01

я про элиту в архитектурном смысле писал, понятно что человек, который спрашивает что такое ML врядли будет заниматься проектированием где нужно серьезно задумываться про big data vs many data

AZ

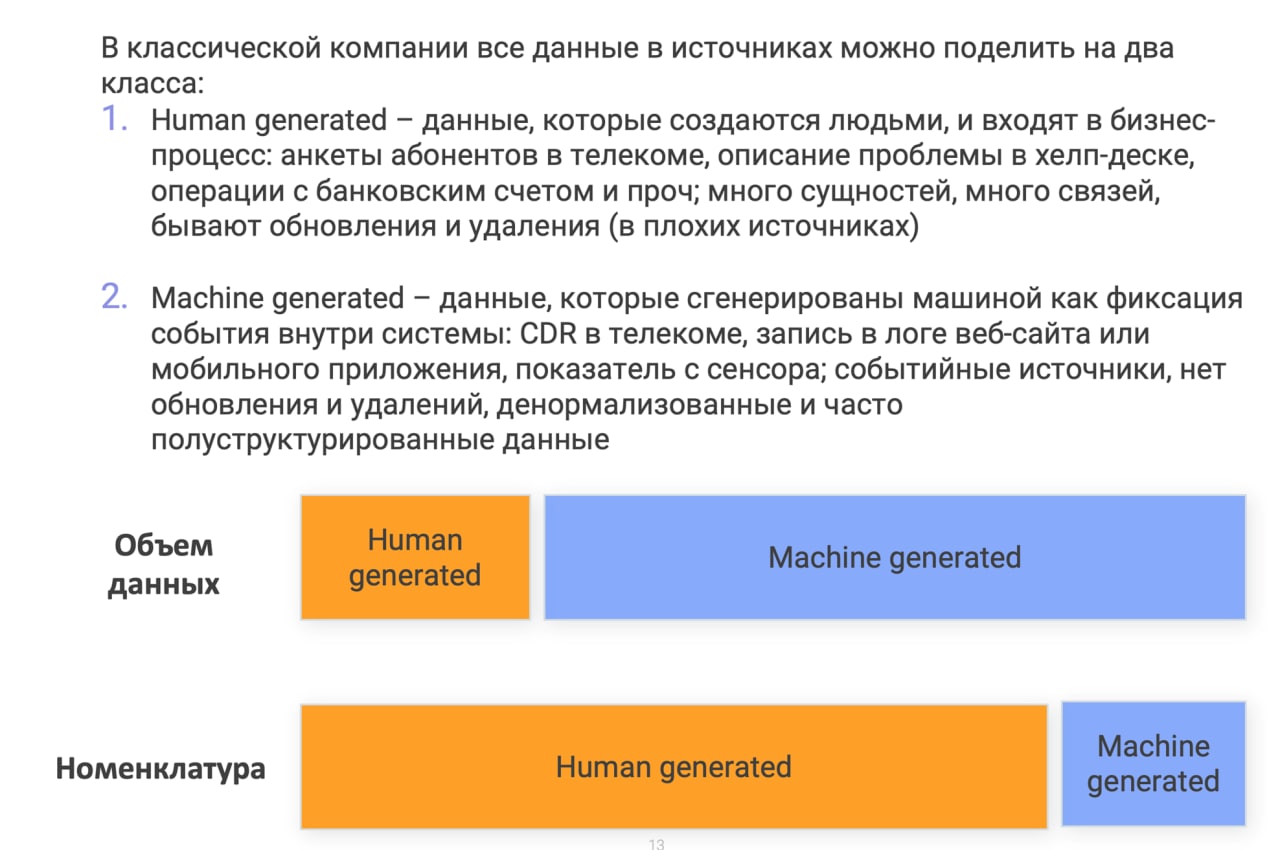

я сам когда студентов и слушателей курсов учил - первым делом толкал телегу про "объем и номенклатуру", разница между machine generated data и business process automation

AE

эх отлить бы эт дело в граните да и тыкать носом маленьких

AZ

эх отлить бы эт дело в граните да и тыкать носом маленьких

вот, даже на русском, дарю

AE

спасибо

NN

А что есть номенклатура?

AZ

А что есть номенклатура?

таблицы, колонки, источники, их количество

AZ

там вообще телега про "сложность" (в смысле объема работ) проектов по даталейку и хранилищу, и что сложность зависит не столько от объема, сколько от номенклатуры

AZ

это был совсем для новичков курс, в универе для магистров уже серьезней подход, мы смотрим на конкретные эстиматоры, всякие конкретные примеры как можно обжигаться на CDC, интеграции данных и всякое такое занудство

AE

слушьте, товарищи. писал кто-нибудь на свежих диалектах ES?

я вон тут в порядке развлечения (а то чё-то устал сигналы по дорожной сети размазывать) решил немного фронта поделать, так у меня вьетнамский синдром. я уже лет 10 в JS не лазил, и ES8 сейчас мне жутко напоминает какой-нить котлин, и синтаксически, и по ощущениям

я вон тут в порядке развлечения (а то чё-то устал сигналы по дорожной сети размазывать) решил немного фронта поделать, так у меня вьетнамский синдром. я уже лет 10 в JS не лазил, и ES8 сейчас мне жутко напоминает какой-нить котлин, и синтаксически, и по ощущениям

AE

смотрю вот на эти дела типа let {a, ...rest} = arrayLike; и прям странно

ЗН

Дайте пожалуйста ссылку на канал где собраны многие чаты по разным ЯП

R

Дайте пожалуйста ссылку на канал где собраны многие чаты по разным ЯП

N

Граждане, кто-то ловил такое? Возникает при overwrite df c

Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

partitionOverwriteMode = dynamic. Я нагуглил, что это баг и он пофикшен в 3.0 версии, но фишка в том, что такая ошибка возникает при записи 1 конкретного датафрейма в 1 конкретный каталог. Ровно та же самая аппликуха на том же самом кластере другой датафрейм в другой каталог пишет без таких ошибок. Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

A

Граждане, кто-то ловил такое? Возникает при overwrite df c

Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

partitionOverwriteMode = dynamic. Я нагуглил, что это баг и он пофикшен в 3.0 версии, но фишка в том, что такая ошибка возникает при записи 1 конкретного датафрейма в 1 конкретный каталог. Ровно та же самая аппликуха на том же самом кластере другой датафрейм в другой каталог пишет без таких ошибок. Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

какой mode стоит? append, overwrite, ignore?

N

Andrey

какой mode стоит? append, overwrite, ignore?

overwrite.

ЗН

Спасибо ь

N

Граждане, кто-то ловил такое? Возникает при overwrite df c

Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

partitionOverwriteMode = dynamic. Я нагуглил, что это баг и он пофикшен в 3.0 версии, но фишка в том, что такая ошибка возникает при записи 1 конкретного датафрейма в 1 конкретный каталог. Ровно та же самая аппликуха на том же самом кластере другой датафрейм в другой каталог пишет без таких ошибок. Caused by: org.apache.hadoop.fs.FileAlreadyExistsException: /data/some_path/.spark-staging-bde11651-6ddc-4ec0-8a41-ec839ce4413f/_part_1=2021-01-10/_part_2=21/_part_3=45/part-00000-bde11651-6ddc-4ec0-8a41-ec839ce4413f.c000.snappy.parquet for client 10.0.0.10 already exists.

реально рядом работает еще 3 таких же сабмита, которые тем же самым кодом пишут другие df в /data/some_path_XX и не валятся.

2021 March 02

RY

Всем добрый день. Хочу услышать ваше мнение и жду ссылки на статьи😁. В данный момент используем cassandra для хранения данных (для построения отчетности я выгружают необходимые таблицы за весь временной промежуток на комп и произвожу манипуляции в питоне, минус в том, что эти таблицы по нескольку часов выгружаются). Так же используем связку Elasticksearc+Kibana для оперативной отчетности, но данные не за весь период хранения. Хотим перенести нашу БД (некоторые таблицы содержат по 10М записей) на Greenplum или Clickhouse. Вопросы: 1. куда лучше перенести? 2. нужно ли изменять структуру БД (добавлять какие-нибудь данные, менять отношения - вместо 1 к 1 менять 1 ко многим)? 3. исходя из чего выбрать промежуток для записи данных? 4. как перелить данные(spark или еще что то использовать, может самим написать)? Буду рад любым идеям и замечаниям😁

AZ

Всем добрый день. Хочу услышать ваше мнение и жду ссылки на статьи😁. В данный момент используем cassandra для хранения данных (для построения отчетности я выгружают необходимые таблицы за весь временной промежуток на комп и произвожу манипуляции в питоне, минус в том, что эти таблицы по нескольку часов выгружаются). Так же используем связку Elasticksearc+Kibana для оперативной отчетности, но данные не за весь период хранения. Хотим перенести нашу БД (некоторые таблицы содержат по 10М записей) на Greenplum или Clickhouse. Вопросы: 1. куда лучше перенести? 2. нужно ли изменять структуру БД (добавлять какие-нибудь данные, менять отношения - вместо 1 к 1 менять 1 ко многим)? 3. исходя из чего выбрать промежуток для записи данных? 4. как перелить данные(spark или еще что то использовать, может самим написать)? Буду рад любым идеям и замечаниям😁

10М это же 10 миллиардов?