K

Size: a a a

2019 October 04

Нет проблем :)

A

окей, спасибо большое)

A

У самих 2 различных варианта:

1) простейший ui который интегрирован с livy, закинул Jar, выбрал спарк версию, отправил submit. (это если нужно какое-то специфические действие)

2) sbt plugin sparkDeploy. Всё спарк версии лежат на hdfs, заливает отдельным Jar все депенденси (чтобы закешировать и по сто раз не лить, если не менял депенденси то зачем перезаливать ещё раз этот жирный jar ), jar уже с твоим кодом из проекта.

По запросу run/deploy делаем корректный xml с путями к спарку, зависимостям, твоему коду (большую часть времени только твой код и меняется, поэтому заливать по минимуму), и сабмитим в oozie или сразу на выполнение, или на скедулинг и периодическое выполнение

1) простейший ui который интегрирован с livy, закинул Jar, выбрал спарк версию, отправил submit. (это если нужно какое-то специфические действие)

2) sbt plugin sparkDeploy. Всё спарк версии лежат на hdfs, заливает отдельным Jar все депенденси (чтобы закешировать и по сто раз не лить, если не менял депенденси то зачем перезаливать ещё раз этот жирный jar ), jar уже с твоим кодом из проекта.

По запросу run/deploy делаем корректный xml с путями к спарку, зависимостям, твоему коду (большую часть времени только твой код и меняется, поэтому заливать по минимуму), и сабмитим в oozie или сразу на выполнение, или на скедулинг и периодическое выполнение

A

Ну и конечно там же зашито в самом узи куда емейл сдать на фейле

VP

Добрый день!

Я хочу распарсить pyspark-ом файл весом 32 Гб, разделителем данных является '~', а разделителем линий -- последовательность символов '#@#@#'. Фактически, так как для файловой системы это одна большая строка, у меня возникают переполнения JVM. Мой вопрос таков -- можно ли как-то задать для pyspark-а дефолтный разделитель линий, чтобы он уже на эта чтения файла (sc.textFile) разбивал его на строки/линии? К сожалению, при задании параметров sep и escape в pyspark он ругается на то, что ими может быть только один символ, а не последовательность

Я хочу распарсить pyspark-ом файл весом 32 Гб, разделителем данных является '~', а разделителем линий -- последовательность символов '#@#@#'. Фактически, так как для файловой системы это одна большая строка, у меня возникают переполнения JVM. Мой вопрос таков -- можно ли как-то задать для pyspark-а дефолтный разделитель линий, чтобы он уже на эта чтения файла (sc.textFile) разбивал его на строки/линии? К сожалению, при задании параметров sep и escape в pyspark он ругается на то, что ими может быть только один символ, а не последовательность

OI

A

там что-то они на него правда подзабили сейчас

0.9.0-SNAPSHOT 2.3.2

висит в ридми

0.9.0-SNAPSHOT 2.3.2

висит в ридми

N

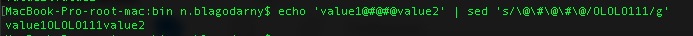

cat filename.txt | sed 's/\~/\t/g' | sed 's/\#\@\#\@\#/\n/g' > normal_file.tsv

N

hdfs dfs -put normal_file.tsv /my/cool/files/path

VP

cat filename.txt | sed 's/\~/\t/g' | sed 's/\#\@\#\@\#/\n/g' > normal_file.tsv

Пробовал

Увы, sed не берет одну строчку в 32 Гб

Увы, sed не берет одну строчку в 32 Гб

VP

На подвыборке из этого файла — все работает

N

IFS многосимвольный не пробовали ставить для перебора?

VP

IFS многосимвольный не пробовали ставить для перебора?

IFS?

Кстати, у меня немного другой sed был — sed 's/#@#@#/\n/g' > normal_file.tsv. Может это как-то влияет

Кстати, у меня немного другой sed был — sed 's/#@#@#/\n/g' > normal_file.tsv. Может это как-то влияет

N

IFS?

Кстати, у меня немного другой sed был — sed 's/#@#@#/\n/g' > normal_file.tsv. Может это как-то влияет

Кстати, у меня немного другой sed был — sed 's/#@#@#/\n/g' > normal_file.tsv. Может это как-то влияет

VP

Так у меня тоже работает)

Проблема в другом — эффект исчезает при увеличении размера файла

Проблема в другом — эффект исчезает при увеличении размера файла

I

Люди может есть пару советов

I

Как студенту начать двигаться в этой профессии

ЕГ

В общем и целом, для работы джуниор ДЕ достаточно изучить apache spark

ЕГ

Плюс то, к чему он может подключаться, и в каких окружениях работать - компоненты hadoop, базы данных, sql

AZ

Добрый день!

Я хочу распарсить pyspark-ом файл весом 32 Гб, разделителем данных является '~', а разделителем линий -- последовательность символов '#@#@#'. Фактически, так как для файловой системы это одна большая строка, у меня возникают переполнения JVM. Мой вопрос таков -- можно ли как-то задать для pyspark-а дефолтный разделитель линий, чтобы он уже на эта чтения файла (sc.textFile) разбивал его на строки/линии? К сожалению, при задании параметров sep и escape в pyspark он ругается на то, что ими может быть только один символ, а не последовательность

Я хочу распарсить pyspark-ом файл весом 32 Гб, разделителем данных является '~', а разделителем линий -- последовательность символов '#@#@#'. Фактически, так как для файловой системы это одна большая строка, у меня возникают переполнения JVM. Мой вопрос таков -- можно ли как-то задать для pyspark-а дефолтный разделитель линий, чтобы он уже на эта чтения файла (sc.textFile) разбивал его на строки/линии? К сожалению, при задании параметров sep и escape в pyspark он ругается на то, что ими может быть только один символ, а не последовательность

реализовать org.apache.hadoop.mapreduce.InputFormat и им прочитать скалой sc.newApiHadoopFile