K

Size: a a a

2019 July 02

Сразу джобы которые требуют только текущие данные, потом те которые требуют немного исторических, по мере миграции переедет всё

Вы не dbs случайно ?

A

Agoda :)

A

@krivdathetriewe тоже данных хватает :)

SB

Nata

Ну у нас тоже, я все хочу спарк под кубер загнать

Вроде это экспериментальная ещё фича. Или уже нет?

A

2.4 вроде уже норм гоняется в кубике

N

Уже не экспериментальная

SB

Nata

Уже не экспериментальная

Они сами пишут в документации на Spark 2.4.3. - "The Kubernetes scheduler is currently experimental. In future versions, there may be behavioral changes around configuration, container images and entrypoints."

https://spark.apache.org/docs/latest/running-on-kubernetes.html

https://spark.apache.org/docs/latest/running-on-kubernetes.html

AK

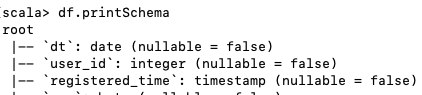

Подскажите, а что делать с backticks (`) в спарке? Все имена столбцов DataFrame обернуты в них, и ничего с ними не могу сделать

AK

df("dt") и df("`dt`") не работают

IR

Получить список колонок без кавычек и сделать df=df.toDF(*columns)

A

например так:

val newNames = df.columns.map( x => if (x.startsWith("`") && x.endsWith("`")) x.tail.init else x)

val dfRenamed = df.toDF(newNames:_*)AK

Спасибо!

AK

Еще вопрос вдогонку) У меня Spark при записи в паркет почему-то какое-то из float-колонок(или даже не одно поле) начинает писать в словарь. Из-за этого запись в паркет растягивается на 3 часа вместо 10-ти минут. Отключение словаря sqlContext.setConf("parquet.enable.dictionary", "false") решает проблему, однако хочется , чтобы для остальных колонок механизм отрабатывал, когда надо. Можно отрубить dictionary только на определенные поля?

AS

всем привет, кто нибудь может подсказать, а hive(version 2.3.5) может работать с openx serde?

CM

Ребята всем привет, такая просьба может ктото скинуть пару примеров как делать quality check идеально в Python, буду очень благодарен! Заранее спасибо!

2019 July 03

VE

Ребят, а кто нибудь знает какие то расширения на апишку airflow? Я посмотрел с этой доки ( https://airflow.apache.org/api.html ), там как то функционал не завезли, может есть какие то кастомные плагины/доделки?

GG

Ребят, а кто нибудь знает какие то расширения на апишку airflow? Я посмотрел с этой доки ( https://airflow.apache.org/api.html ), там как то функционал не завезли, может есть какие то кастомные плагины/доделки?

Привет :-) не видел, иначе бы уже внедрили, правда? По идее там есть cli, который реализует определенный функционал, ну, и не проблема придумать способ его вызывать через http :-)

PI

Ребята, какую CDC заюзать, нужны логи дб в кафке....Attunity Replicate? Debezium? есть какой-то опыт?

PG

Какая бд