A

Size: a a a

2019 June 11

Но статистика у нас такая, 1 из 50

2019 June 12

SB

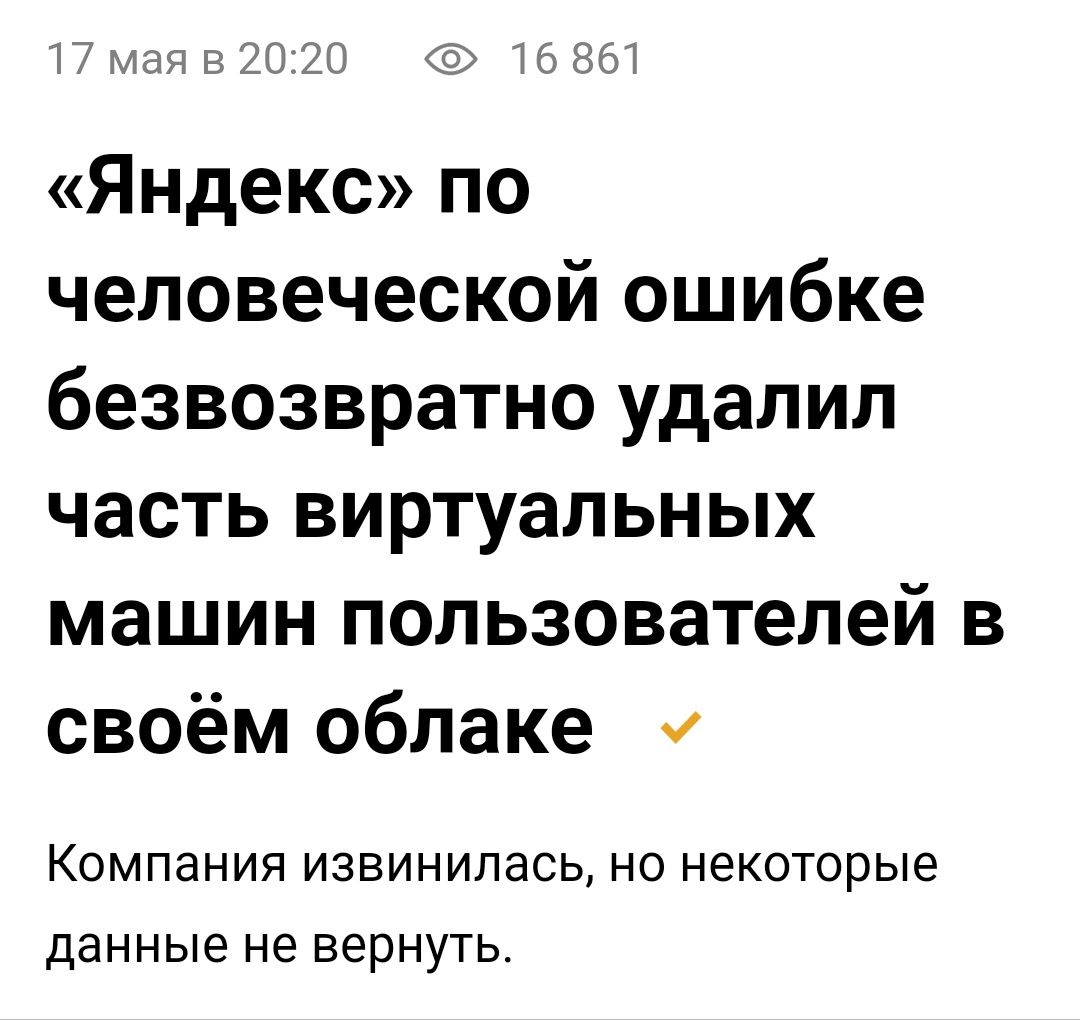

Коллеги, кто-нибуль развертывал Hadoop стек в наших российских облачных сервисах? Что-то мне опасливо разворачивать новый проект на Amazon или Google Cloud в свете всех этих торговых войн и ситуации с Huawei. Смотрел в сторону Яндекс.Облака, но жутко раздражает их аляповый дизайн. Через 10 минут на их сайте глаза начинают кровоточить. А как они в деле (соотношение цена/качество), может кто пробовал?

ЕГ

Ещё есть техносерв клауд, аренадата)

⛰

Думаю не стоит :)

⛰

Коллеги, кто-нибуль развертывал Hadoop стек в наших российских облачных сервисах? Что-то мне опасливо разворачивать новый проект на Amazon или Google Cloud в свете всех этих торговых войн и ситуации с Huawei. Смотрел в сторону Яндекс.Облака, но жутко раздражает их аляповый дизайн. Через 10 минут на их сайте глаза начинают кровоточить. А как они в деле (соотношение цена/качество), может кто пробовал?

SB

Ну так Google Cloud тоже может уничтожить ваши данные, если ему что-то покажется подозрительным - https://habr.com/ru/post/417377/

EV

Коллеги, кто-нибуль развертывал Hadoop стек в наших российских облачных сервисах? Что-то мне опасливо разворачивать новый проект на Amazon или Google Cloud в свете всех этих торговых войн и ситуации с Huawei. Смотрел в сторону Яндекс.Облака, но жутко раздражает их аляповый дизайн. Через 10 минут на их сайте глаза начинают кровоточить. А как они в деле (соотношение цена/качество), может кто пробовал?

А юрлицо в россии?

EV

Просто если нет, то нафиг связываться с российскими сервисами

2019 June 13

O

Коллеги, кто-нибуль развертывал Hadoop стек в наших российских облачных сервисах? Что-то мне опасливо разворачивать новый проект на Amazon или Google Cloud в свете всех этих торговых войн и ситуации с Huawei. Смотрел в сторону Яндекс.Облака, но жутко раздражает их аляповый дизайн. Через 10 минут на их сайте глаза начинают кровоточить. А как они в деле (соотношение цена/качество), может кто пробовал?

Так ведь десятки их, в чем проблема?

SB

Так ведь десятки их, в чем проблема?

Хотелось бы сразу в удобном и не сильно дорогом сервисе разместиться, а не пробовать по очереди все, какие есть 🙂. Какой-нибудь порекомендуете?

TT

Google cloud or AWS

R

Всем привет. Пытаюсь мокнуть тест с записью в S3 из спарка, и тут набрел на прикол.

В качестве мока взял s3 mock от findify, сервер стартует в начале тестов вот так:

sp

Unab

В качестве мока взял s3 mock от findify, сервер стартует в начале тестов вот так:

val endpoint = new EndpointConfiguration("http://127.0.0.1:8001", "eu-central-1")

s3Client = AmazonS3ClientBuilder

.standard

.withEndpointConfiguration(endpoint)

.withPathStyleAccessEnabled(false)

.withCredentials(new AWSStaticCredentialsProvider(new AnonymousAWSCredentials()))

.build

s3Client.createBucket("flux-local-dev")

super.beforeEach()В параметрах спарка прописываю:sp

ark = SparkSession.builder()В тесте

.appName("unit-test")

.master("local[2]")

.config("spark.sql.warehouse.dir", "target/spark-warehouse")

.config("spark.hadoop.fs.s3a.endpoint", "http://127.0.0.1:8001")

.config("spark.hadoop.fs.s3a.impl", "org.apache.hadoop.fs.s3a.S3AFileSystem")

.config("spark.hadoop.fs.s3a.aws.credentials.provider", "org.apache.hadoop.fs.s3a.AnonymousAWSCredentialsProvider<")

.getOrCreate

нормально запускается сервер, спарк стартует ОК, но при попытке записаться получаем:Unab

le to load AWS credentials from any provider in the chain: [BasicAWSCredentialsProvider: Access key or secret key is null, com.amazonaws.auth.InstanceProfileCredentialsProvider@6a26eee6: Unable to load credentials from service endpoint]к с этим жить вообще? Вроде подсунул же параметр по анонимной авторизации(

Ка

R

нашел. воистину, опенсорс - это сам себе злобный буратино - в версии 2.6.0 hadoop-aws это не работает, а в версии 2.8.5 - работает.

на будущее для нуждающихся https://stackoverflow.com/questions/31496152/access-public-available-amazon-s3-file-from-apache-spark

на будущее для нуждающихся https://stackoverflow.com/questions/31496152/access-public-available-amazon-s3-file-from-apache-spark

A

То есть если бы были закрытые сорцы то ты бы даже и не представлял где и почему упало

A

Шикарное чувство смотреть в сишные дампы hdfs от mapr.

R

То есть если бы были закрытые сорцы то ты бы даже и не представлял где и почему упало

Были бы закрытые сорцы - можно вендора трясти «а чего не работает нам обещали космолёт» 😂

K

А будет кто на дататолке сегодня , там места есть ещё ?

РА

я планировал пойти

РА

похоже не пойду 🙁

РА

если есть возможность передать свое место, то я бы передал