AZ

Size: a a a

2019 May 10

я видел попытки запускать hbase внутри yarn services (и других контейнерных оркестраторов), с целью получить много регионсерверов на одной большой железной тачке - всегда было страшной поделкой из скотча и зубочисток, в продакшен не поехала

DM

я видел попытки запускать hbase внутри yarn services (и других контейнерных оркестраторов), с целью получить много регионсерверов на одной большой железной тачке - всегда было страшной поделкой из скотча и зубочисток, в продакшен не поехала

а для чего на одном хосте куча регион-серверов?

AZ

а для чего на одном хосте куча регион-серверов?

ну обычные проблемы с одним большим JVM, если в машине десятки ядер и полтера памяти то сделать на несколько регионсерверов будет выгодно для производительности и отзывчивости hbase

AZ

просто как отдельностоящие RS запускать можно, а не во всяких докерах https://github.com/linehrr/hbase-multi-hosting https://community.hortonworks.com/questions/103072/installing-multiple-regionserver-on-one-host-via-a.html

КБ

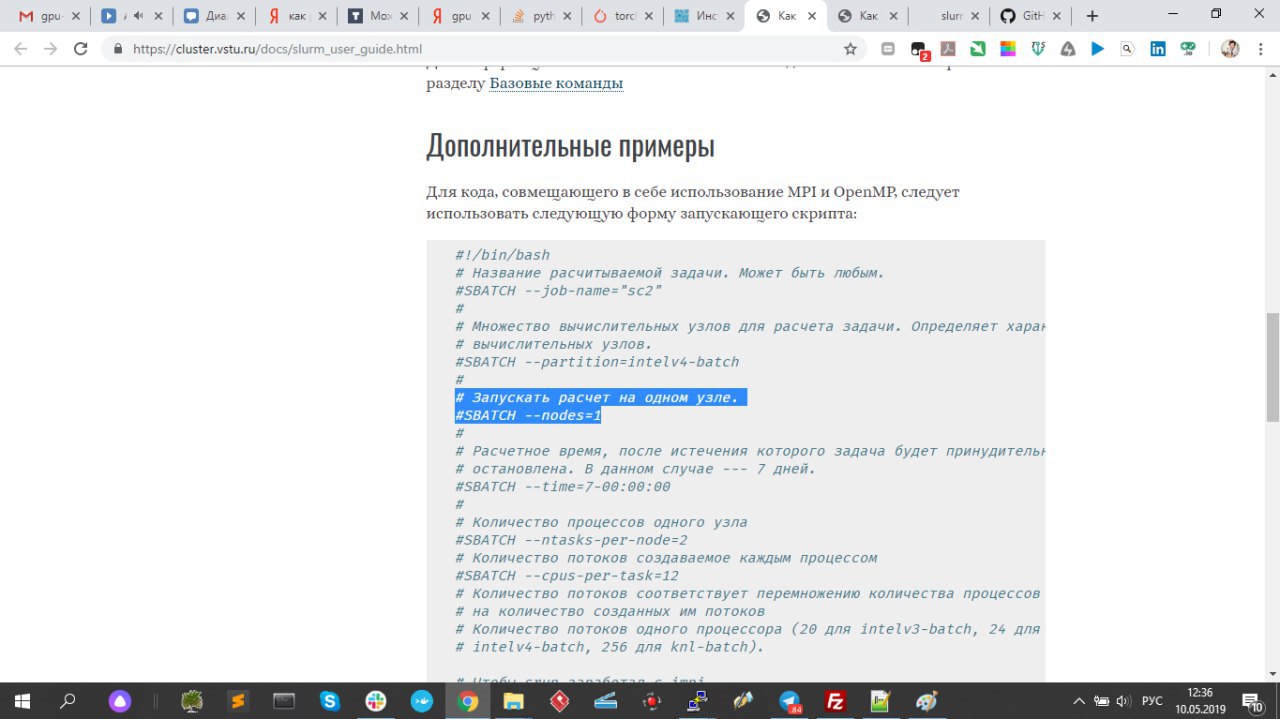

возможно не умный вопрос задаю, просто я почитал документацию ..и тут написано #SBATCH —nodes=2 достаточно для того, чтобы распределить вычисления по 2-м узлам.

https://cluster.vstu.ru/docs/slurm_user_guide.html

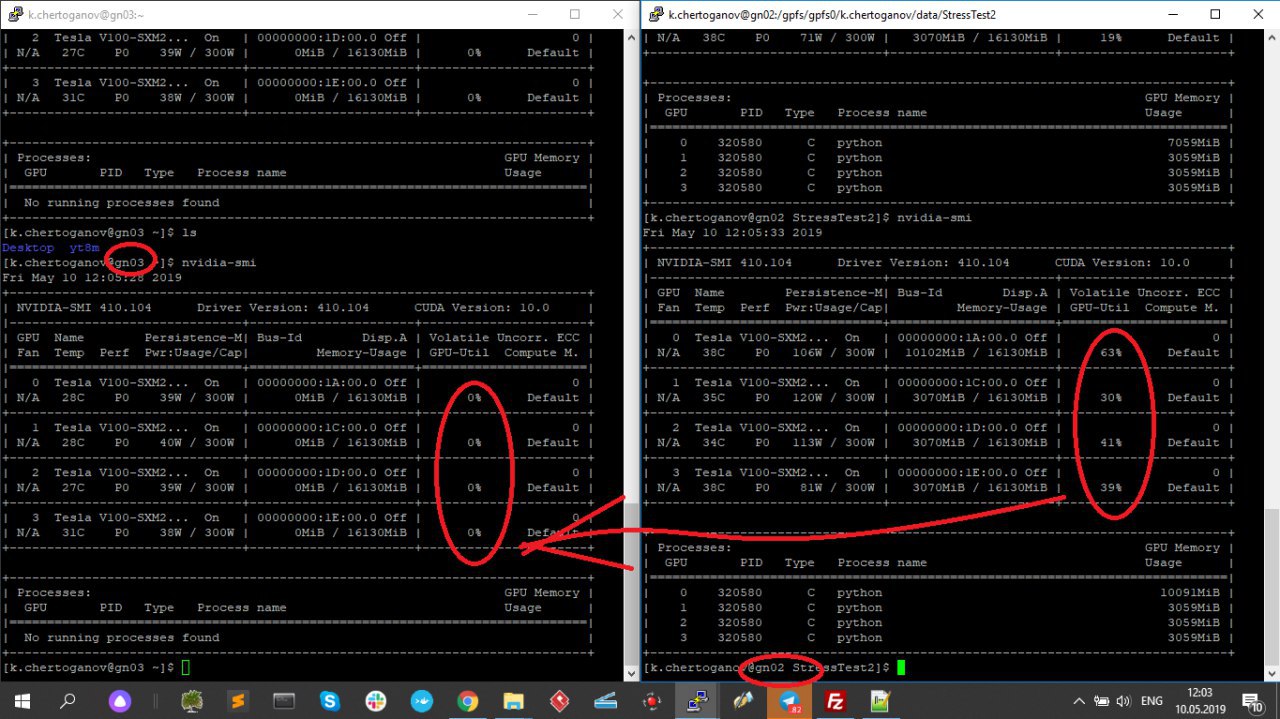

(скриншот1)

я запускаю расчет на двух узлах.

#SBATCH —nodes=2

а получается что на одном узле gn02 все 4GPU загружены, а на второй узле gn03 (скриншот №2) GPU-шки простаивают.

я выделил себе две ноды..хочу чтобы по двум нодам параллельно считало..

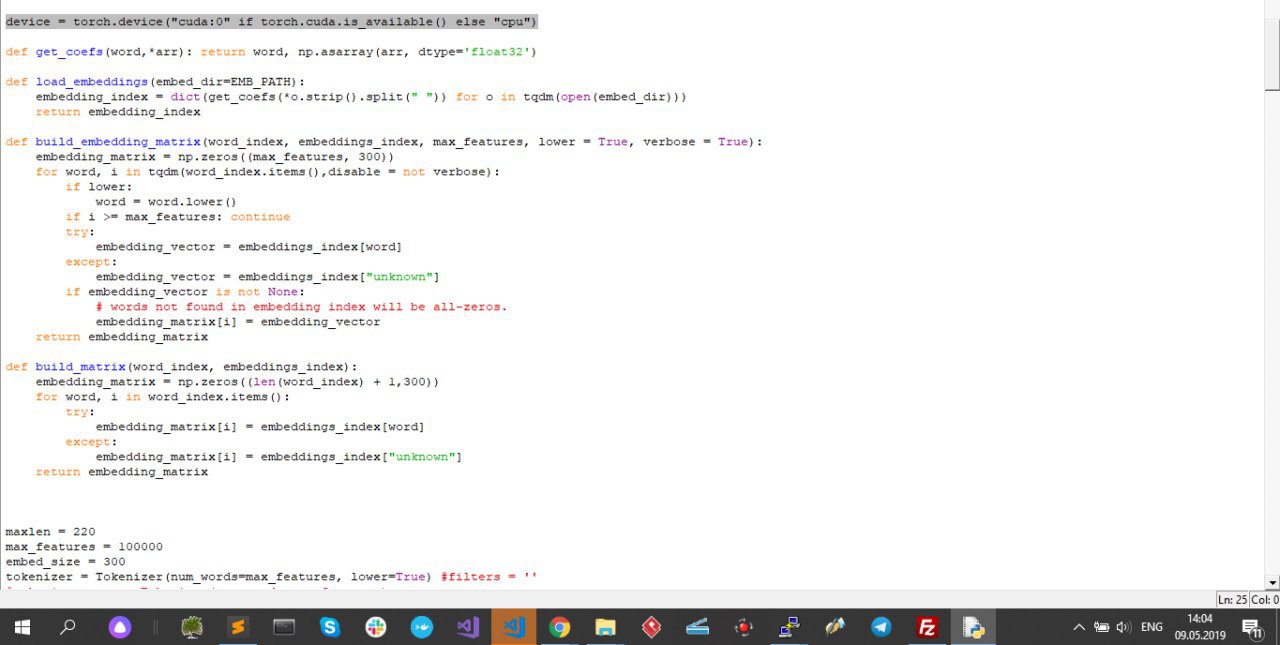

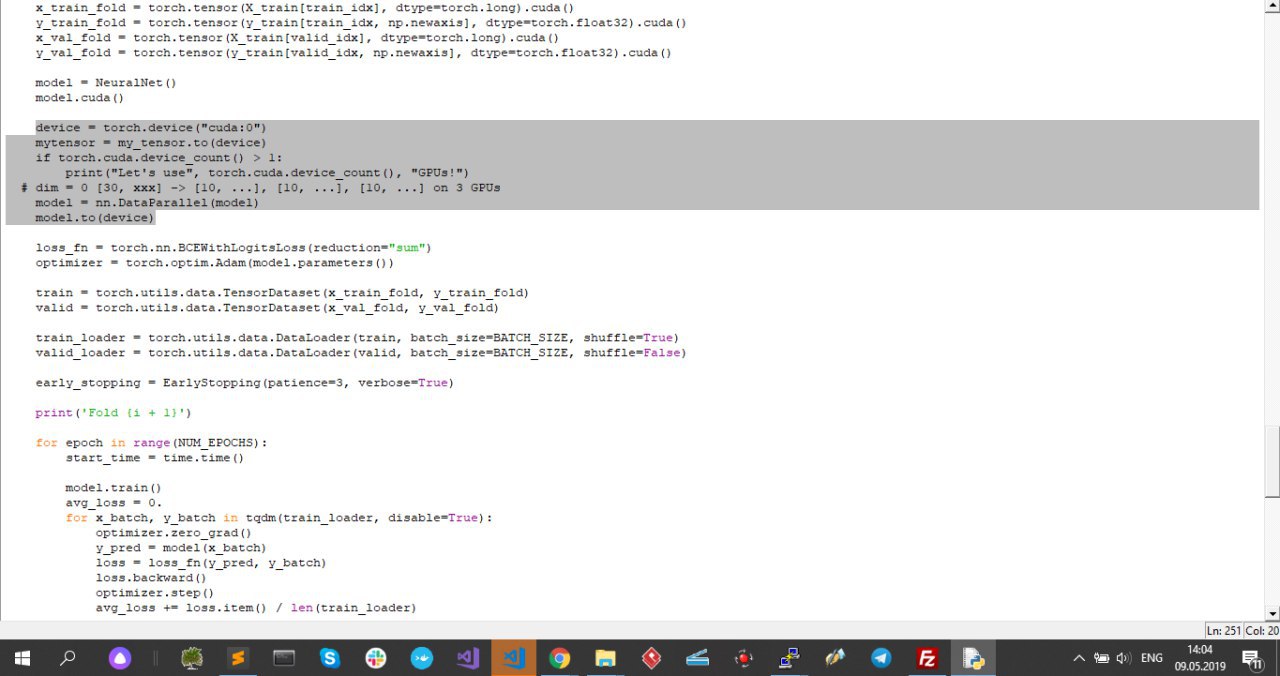

В коде программы я ее распаралелил (как показывал раньше, скриншот3), так что тут все норм..

как мне распараллелить вычисления теперь на 2 ноды ? на одну полностью все загружает, хочу чтобы по двум нодам параллельно вычисления шли..

P.S.

я подумал, что нужно просто прописать

# Количество процессов одного узла

#SBATCH —ntasks-per-node=4

и результат такой же, это был JobID 57044,

теперь поставил

#SBATCH —ntasks-per-node=8

это был JobID 570448

результат и там такой же (скриншот 5 и 6)

https://cluster.vstu.ru/docs/slurm_user_guide.html

(скриншот1)

я запускаю расчет на двух узлах.

#SBATCH —nodes=2

а получается что на одном узле gn02 все 4GPU загружены, а на второй узле gn03 (скриншот №2) GPU-шки простаивают.

я выделил себе две ноды..хочу чтобы по двум нодам параллельно считало..

В коде программы я ее распаралелил (как показывал раньше, скриншот3), так что тут все норм..

как мне распараллелить вычисления теперь на 2 ноды ? на одну полностью все загружает, хочу чтобы по двум нодам параллельно вычисления шли..

P.S.

я подумал, что нужно просто прописать

# Количество процессов одного узла

#SBATCH —ntasks-per-node=4

и результат такой же, это был JobID 57044,

теперь поставил

#SBATCH —ntasks-per-node=8

это был JobID 570448

результат и там такой же (скриншот 5 и 6)

КБ

ну ребят

UD

Остальное к админам твоего кластера, как они слерм настроили

КБ

не надо ли DataParallel на DistributedDataParallel заменить? чтобы он и на другую тачку закидывал

КБ

я пытаюсь эту обертку написать, но ..

КБ

я тупо копирнул весь код от сюда...https://pytorch.org/docs/stable/_modules/torch/nn/parallel/distributed.html

КБ

и получил вот это, как прогу запустить без ошибок ..?

YI

2.0/3.0?

КБ

python ?