i

Size: a a a

2021 February 24

а чем тебе не нравится 1?

Можно придумать задачу в которой жадный алгоритм будет делать не частичный перебор.

DP

Скорее можно найти задачу, где они найдут лучший поднабор признаков, да

DP

Криво тоже сказано

DP

Кванторы понаставлены где не надо, и не поставлены, где надо

ET

Приветик всем

Нужно ли нормализовать данные для задачи кластеризации и пытаться привести их к нормальному ввиду

Если да, то зачем?

Нужно ли нормализовать данные для задачи кластеризации и пытаться привести их к нормальному ввиду

Если да, то зачем?

Если используется в алгоритме расстояние в геометрическом пространстве в качестве критерия схожести, то да, признаки дб в одной «шкале», иначе какой-то признак будет «перевешивать». Мб существуют алгоритмы, где не надо делать нормализацию, но я не знаю про них.

А

Если используется в алгоритме расстояние в геометрическом пространстве в качестве критерия схожести, то да, признаки дб в одной «шкале», иначе какой-то признак будет «перевешивать». Мб существуют алгоритмы, где не надо делать нормализацию, но я не знаю про них.

А нужно ли пытаться приводить мое распределение к нормальному виду?

Просто у меня оно виде экспоненты и если взять ln, то будет как нормальное распределение

Просто у меня оно виде экспоненты и если взять ln, то будет как нормальное распределение

ET

А нужно ли пытаться приводить мое распределение к нормальному виду?

Просто у меня оно виде экспоненты и если взять ln, то будет как нормальное распределение

Просто у меня оно виде экспоненты и если взять ln, то будет как нормальное распределение

В задачах регрессии это иногда улучшает качество модели. С кластеризацией получится, что кластеры по другому будут сформированы, и тут вопрос , какой вариант лучше. Можно попробовать сделать визуализацию на двух признаках и посмотреть с тз практики/бизнес-задачи, что больше похоже на правду, либо посмотреть в сторону метрик оценки качества кластеризации.

А

В задачах регрессии это иногда улучшает качество модели. С кластеризацией получится, что кластеры по другому будут сформированы, и тут вопрос , какой вариант лучше. Можно попробовать сделать визуализацию на двух признаках и посмотреть с тз практики/бизнес-задачи, что больше похоже на правду, либо посмотреть в сторону метрик оценки качества кластеризации.

Спасибо

н

Здравствуйте! Прошу проверить домашнюю работу #C1W4

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

AA

Здравствуйте! Прошу проверить домашнюю работу #C1W4

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

н

AA

Здравствуйте! Прошу проверить домашнюю работу #C1W4

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/L0N0sHYWEeuVRgpkjHwX-Q

слуш, а почему ты из формул не вывела вот эти

mu = ss.expon.expect() # вычисляем параметры нормального распределения

sigma = ss.expon.var()/math.sqrt(5) # через параметры экспоненциального распределения

norm_rv = ss.norm(loc=mu, scale=sigma) # определяем согласно им нормальное распределение

про это же было задание?

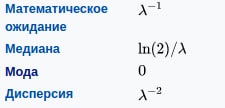

https://ru.wikipedia.org/wiki/%D0%AD%D0%BA%D1%81%D0%BF%D0%BE%D0%BD%D0%B5%D0%BD%D1%86%D0%B8%D0%B0%D0%BB%D1%8C%D0%BD%D0%BE%D0%B5_%D1%80%D0%B0%D1%81%D0%BF%D1%80%D0%B5%D0%B4%D0%B5%D0%BB%D0%B5%D0%BD%D0%B8%D0%B5

mu = ss.expon.expect() # вычисляем параметры нормального распределения

sigma = ss.expon.var()/math.sqrt(5) # через параметры экспоненциального распределения

norm_rv = ss.norm(loc=mu, scale=sigma) # определяем согласно им нормальное распределение

про это же было задание?

https://ru.wikipedia.org/wiki/%D0%AD%D0%BA%D1%81%D0%BF%D0%BE%D0%BD%D0%B5%D0%BD%D1%86%D0%B8%D0%B0%D0%BB%D1%8C%D0%BD%D0%BE%D0%B5_%D1%80%D0%B0%D1%81%D0%BF%D1%80%D0%B5%D0%B4%D0%B5%D0%BB%D0%B5%D0%BD%D0%B8%D0%B5

AA

при лямбде = 1, mu = sigma = 1, ну и все =)

AA

я, правда, сам в этот пункт (вывести значения теоретически) оч долго втыкал, часы потратил, чтобы понять, что от меня требуется)

AA

а лямбда = 1 - это дефолтовое значение

https://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.expon.html

The probability density above is defined in the “standardized” form. To shift and/or scale the distribution use the loc and scale parameters. Specifically, expon.pdf(x, loc, scale) is identically equivalent to expon.pdf(y) / scale with y = (x - loc) / scale. Note that shifting the location of a distribution does not make it a “noncentral” distribution; noncentral generalizations of some distributions are available in separate classes.

A common parameterization for expon is in terms of the rate parameter lambda, such that pdf = lambda * exp(-lambda * x). This parameterization corresponds to using scale = 1 / lambda.

https://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.expon.html

The probability density above is defined in the “standardized” form. To shift and/or scale the distribution use the loc and scale parameters. Specifically, expon.pdf(x, loc, scale) is identically equivalent to expon.pdf(y) / scale with y = (x - loc) / scale. Note that shifting the location of a distribution does not make it a “noncentral” distribution; noncentral generalizations of some distributions are available in separate classes.

A common parameterization for expon is in terms of the rate parameter lambda, such that pdf = lambda * exp(-lambda * x). This parameterization corresponds to using scale = 1 / lambda.

н

Ну я просто в лоб взяла из выборки дисперсию и мат. ожидание. Спасибо, попробую на досуге разобраться с лямбдой

КА

Всем привет. Кто работал с Vowpal Wabbit? Застряла с #C6W6 по идентификации пользователей. Принимает все ответы кроме полученных классификатором этой библиотеки. Может кто-то подсказать? Буду очень благодарна. Уже несколько дней мучаюсь

SS

задачу не знаю, но с vw работал, его надо уметь готовить, особое внимание на генерацию файла и параметры командной строки (для получения вероятностей нужны танцы с бубном)

SS

там классификация?