A

Size: a a a

2021 February 09

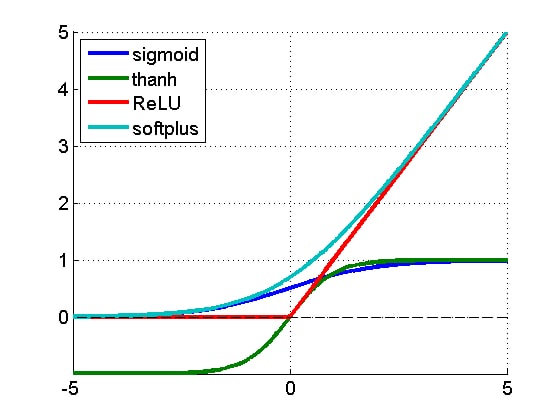

щас почти везде ReLU и ее вариации

P

ну типа прям перемножение матриц с нуля итд

линала у меня курс с института пройденный, сяб

T

Спасибо!!!

P

щас почти везде ReLU и ее вариации

Вот до этого пока не дошёл

A

да эт нюансы

A

зато на нейронках хорошо видно как работает вообще наука в целом

A

все юзали сигмоид

A

потом ОП

P

зато на нейронках хорошо видно как работает вообще наука в целом

Я не зная что это известная проблема сегодня голову ломал как один перцептрон научить XOR решать))

A

появился ReLU, и все перешли на него, все везде стало лучше

A

потом оп, swish

A

в общем задача функции активации - добавить нелинейности в линейную функцию

P

в общем задача функции активации - добавить нелинейности в линейную функцию

Да, понимаю

A

т.е. чтобы описывать более сложные кривые

P

Да, понимаю

Ток единственное, не совсем понял почему везде пишут что со step функцией нельзя сделать backpropagation когда можно

A

Ток единственное, не совсем понял почему везде пишут что со step функцией нельзя сделать backpropagation когда можно

ну мб тогда была какаянить недиффиренцируемая функция там

A

не знаю даже

A

так вот