K

Size: a a a

2019 September 22

Но это будто вопрос для @metrics_ru

Да, мне уже ответили там, спасибо

K

Ну, она классная. Если тебе надо быстро оперативный мониторинг, но до прометеуса полноценного не дорос - почему нет ?

Прометеус есть

2019 September 23

MD

Как именно?

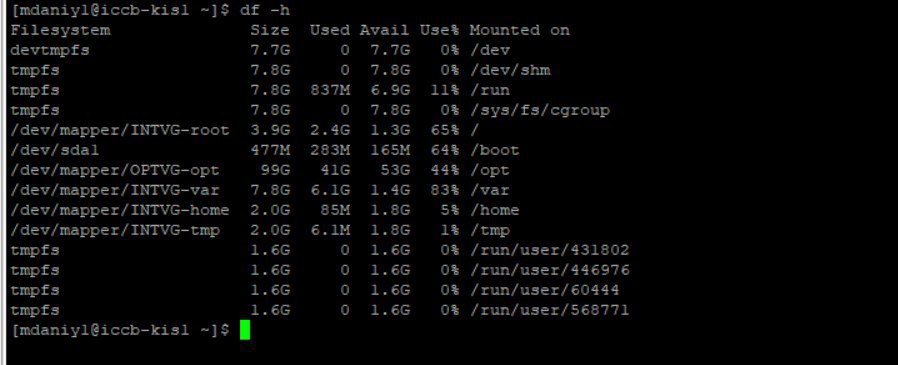

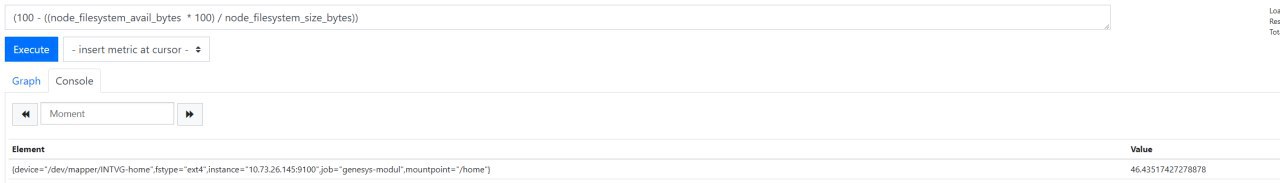

Не правильно считает процент насчёт использованного места..

GG

Martin Danielyan

Не правильно считает процент насчёт использованного места..

Конкретнее плиз

GG

Ты сами pvки мониторишь?

MD

Конкретнее плиз

Пример / или /var

GG

У меня все было ок, но может я невнимательно смотрел

MD

Ты сами pvки мониторишь?

Скажем с нуля поднял тачку есть два дам один дефолтный при создании тачки с разными патрициями. Другой отделений новый дам на /opt .

MD

И он не корректно подсчитывает процент занятого места.

GG

Ну, ок

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

MD

Ну, ок

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

Чуть позже скину.

MD

Ну, ок

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

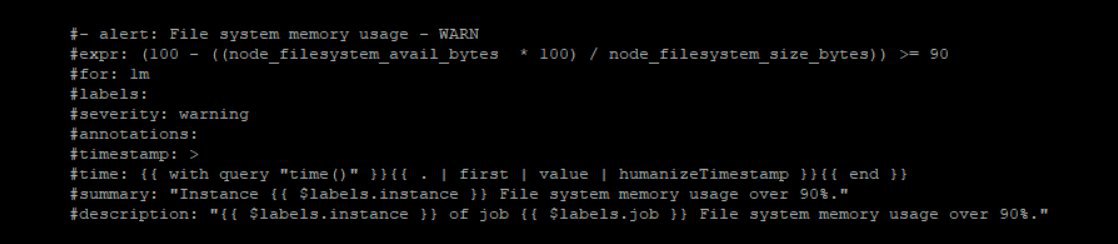

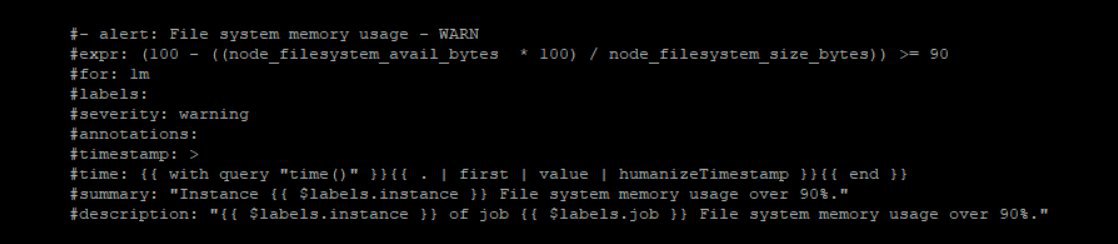

Вот метрика

MD

A

всем привет, может быть кто-то подскажет, хочу поднять кластер эластика в докера на 3 нодах

docker-compose.yml на всех 3 нодах одинаковый

тут меняется только node.name

в логах второй ноды

на первой ноде curl 127.0.0.1:9400/_cat/nodes?v

с первой ноды

с второй

что не так с настройками, почему он коннектится со второй ноды к первой через внутренние айпишки докера или может кто-то такое уже настраивал и поделится конфигами?

docker-compose.yml на всех 3 нодах одинаковый

cat docker-compose.yml

version: '2'

services:

elasticsearch:

image: docker.elastic.co/elasticsearch/elasticsearch:5.0.2

restart: always

container_name: elasticsearch

environment:

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms6g -Xmx6g"

- xpack.security.enabled=false

- "discovery.zen.ping.unicast.hosts=real_ip_node1:9500,real_ip_node2:9500,real_ip_node3:9500"

ulimits:

memlock:

soft: -1

hard: -1

ports:

- "9400:9200"

- "9500:9300"

volumes:

- ./hunspell:/usr/share/elasticsearch/config/hunspell

- esdata:/usr/share/elasticsearch/data

- ./elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /backup_es/snapshot:/backup_es/snapshot

volumes:

esdata:

driver: local

тут меняется только node.name

cat elasticsearch.yml

node1

cluster.name: docker

node.name: n1

network.host: 0.0.0.0

bootstrap.memory_lock: true

xpack.monitoring.enabled: false

cluster.routing.allocation.disk.threshold_enabled: false

discovery.zen.minimum_master_nodes: 2

transport.host: 0.0.0.0

path.repo: ["/backup_es/snapshot"]

node2

cluster.name: docker

node.name: n2

network.host: 0.0.0.0

bootstrap.memory_lock: true

xpack.monitoring.enabled: false

cluster.routing.allocation.disk.threshold_enabled: false

discovery.zen.minimum_master_nodes: 2

transport.host: 0.0.0.0

path.repo: ["/backup_es/snapshot"]

docker exec -it elasticsearch env

PATH=/usr/share/elasticsearch/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

HOSTNAME=c08afe882535

TERM=xterm

bootstrap.memory_lock=true

ES_JAVA_OPTS=-Xms6g -Xmx6g

xpack.security.enabled=false

discovery.zen.ping.unicast.hosts=real_ip_node1:9500,real_ip_node2:9500,real_ip_node3:9500

JAVA_HOME=/usr/lib/jvm/java-1.8-openjdk

HOME=/usr/share/elasticsearch

в логах второй ноды

[2019-09-22T12:37:38,791][WARN ][o.e.d.z.ZenDiscovery ] [n2] failed to connect to master [{db3}{FfkGHzdXT-OJhZ8XWZf1BQ}{Mydsy6sqTOOBSZSrszMjsA}{172.23.0.2}{172.23.0.2:9300}], retrying...

org.elasticsearch.transport.ConnectTransportException: [n1][172.23.0.2:9300] connect_timeout[30s]на первой ноде curl 127.0.0.1:9400/_cat/nodes?v

[2019-09-22T12:38:06,686][WARN ][r.suppressed ] path: /_cat/nodes, params: {v=}

org.elasticsearch.discovery.MasterNotDiscoveredException

at org.elasticsearch.action.support.master.TransportMasterNodeAction$AsyncSingleAction$5.onTimeout(TransportMasterNodeAction.java:214) [elasticsearch-5.0.2.jar:5.0.2]с первой ноды

docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' elasticsearch

172.23.0.2с второй

docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' elasticsearch

172.25.0.2что не так с настройками, почему он коннектится со второй ноды к первой через внутренние айпишки докера или может кто-то такое уже настраивал и поделится конфигами?

MD

Ну, ок

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

Но вообще так помочь невозможно - никаких конкретных данных. Ни версии node exporter, ни метрики и выхлопа df -h

и /home

GG

Martin Danielyan

Вот метрика

Это не метрика, это Алерт

GG

Чтобы понять в чем дело - надо взять ноуд экспортер и в текстовом виде поглядеть на сами значения пустого места

MD

Это не метрика, это Алерт

алерт на основе метрик

GG

всем привет, может быть кто-то подскажет, хочу поднять кластер эластика в докера на 3 нодах

docker-compose.yml на всех 3 нодах одинаковый

тут меняется только node.name

в логах второй ноды

на первой ноде curl 127.0.0.1:9400/_cat/nodes?v

с первой ноды

с второй

что не так с настройками, почему он коннектится со второй ноды к первой через внутренние айпишки докера или может кто-то такое уже настраивал и поделится конфигами?

docker-compose.yml на всех 3 нодах одинаковый

cat docker-compose.yml

version: '2'

services:

elasticsearch:

image: docker.elastic.co/elasticsearch/elasticsearch:5.0.2

restart: always

container_name: elasticsearch

environment:

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms6g -Xmx6g"

- xpack.security.enabled=false

- "discovery.zen.ping.unicast.hosts=real_ip_node1:9500,real_ip_node2:9500,real_ip_node3:9500"

ulimits:

memlock:

soft: -1

hard: -1

ports:

- "9400:9200"

- "9500:9300"

volumes:

- ./hunspell:/usr/share/elasticsearch/config/hunspell

- esdata:/usr/share/elasticsearch/data

- ./elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /backup_es/snapshot:/backup_es/snapshot

volumes:

esdata:

driver: local

тут меняется только node.name

cat elasticsearch.yml

node1

cluster.name: docker

node.name: n1

network.host: 0.0.0.0

bootstrap.memory_lock: true

xpack.monitoring.enabled: false

cluster.routing.allocation.disk.threshold_enabled: false

discovery.zen.minimum_master_nodes: 2

transport.host: 0.0.0.0

path.repo: ["/backup_es/snapshot"]

node2

cluster.name: docker

node.name: n2

network.host: 0.0.0.0

bootstrap.memory_lock: true

xpack.monitoring.enabled: false

cluster.routing.allocation.disk.threshold_enabled: false

discovery.zen.minimum_master_nodes: 2

transport.host: 0.0.0.0

path.repo: ["/backup_es/snapshot"]

docker exec -it elasticsearch env

PATH=/usr/share/elasticsearch/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

HOSTNAME=c08afe882535

TERM=xterm

bootstrap.memory_lock=true

ES_JAVA_OPTS=-Xms6g -Xmx6g

xpack.security.enabled=false

discovery.zen.ping.unicast.hosts=real_ip_node1:9500,real_ip_node2:9500,real_ip_node3:9500

JAVA_HOME=/usr/lib/jvm/java-1.8-openjdk

HOME=/usr/share/elasticsearch

в логах второй ноды

[2019-09-22T12:37:38,791][WARN ][o.e.d.z.ZenDiscovery ] [n2] failed to connect to master [{db3}{FfkGHzdXT-OJhZ8XWZf1BQ}{Mydsy6sqTOOBSZSrszMjsA}{172.23.0.2}{172.23.0.2:9300}], retrying...

org.elasticsearch.transport.ConnectTransportException: [n1][172.23.0.2:9300] connect_timeout[30s]на первой ноде curl 127.0.0.1:9400/_cat/nodes?v

[2019-09-22T12:38:06,686][WARN ][r.suppressed ] path: /_cat/nodes, params: {v=}

org.elasticsearch.discovery.MasterNotDiscoveredException

at org.elasticsearch.action.support.master.TransportMasterNodeAction$AsyncSingleAction$5.onTimeout(TransportMasterNodeAction.java:214) [elasticsearch-5.0.2.jar:5.0.2]с первой ноды

docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' elasticsearch

172.23.0.2с второй

docker inspect -f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{end}}' elasticsearch

172.25.0.2что не так с настройками, почему он коннектится со второй ноды к первой через внутренние айпишки докера или может кто-то такое уже настраивал и поделится конфигами?

Зачем ты так делаешь?

GG

Martin Danielyan

алерт на основе метрик

Отдели проблему с алертом и с метрикой - это для начала